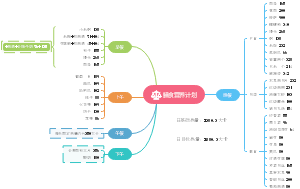

导图社区 外科 8 黄疸

- 37

- 1

- 0

- 举报

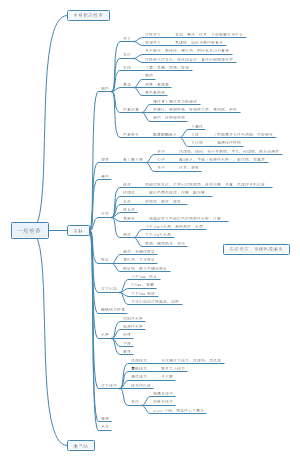

外科 8 黄疸

考研学姐呕心沥血整理,包含徐琦老师的临床思维,结合天天师兄总结,医学考研并不可怕,希望对你有所帮助!

编辑于2024-01-10 21:55:23- 外科

外科 8 黄疸

社区模板帮助中心,点此进入>>

- 相似推荐

- 大纲

胆道疾病

无痛性黄疸(Courvoisier征)

右上腹触及肿大胆囊

出现早、进行性

中下段胆管癌

胆道肿瘤(胆囊癌、胆管癌)

增强CT / MRCP(磁共振胰胆管成像)

*MRCP

替代PTC、ERCP,观察胰胆管最佳无创检查

*PTC

不受肝功能影响(即使黄疸重、肝功能差者也能用)

PTC后需引流(PTCD),兼诊断、治疗作用

并发症:胆瘘、出血、感染

*ERCP

意义:检查、取活检、取石(EST)

ERCP后需引流(ENBD)

并发症

偏左上腹痛:急性胰腺炎

偏右上腹痛 + 黄疸:急性胆管炎

没有治疗作用

若结石、肿瘤:低信号充盈缺损(杯口状)、其上方胆管扩张

对比水:高信号

→无手术机会,减黄治疗--PTCD、ENBD

→手术根治--胆囊癌根治术(ⅡA、ⅡB、ⅢA)、Whipple

胆囊癌

底、体多见,腺癌多见

*腺癌多见:胃癌、肠癌、胰腺癌、胆囊癌、胆管癌

隐匿

触及胆囊肿大多为晚期

不伴感染则无发热

不伴胆管梗阻则无黄疸、无转氨酶↑

淋巴转移--最常侵犯肝

*胆囊癌一般由胆囊息肉恶变而来

分类

肿瘤性息肉:腺瘤(癌前病变)、血管瘤、脂肪瘤、平滑肌瘤、神经纤维瘤

非肿瘤性息肉:胆固醇 / 炎性息肉(几乎不癌变)、腺肌增生、腺瘤样增生、黄色肉芽肿、异位胃黏膜 / 胰腺组织

胆管癌

*肝内胆管上皮恶性肿瘤—原发性肝癌;肝外胆管上皮恶性肿瘤—胆管癌,腺癌多见

胆总管长7~9cm,直径0.6~0.8cm,分4段

*十二指肠上段:行胆总管切开的部位(若结石嵌顿在壶腹部—EST + 取石 + ENBD)

分类

上段:(肝门部)胆管癌最多见

位于胆囊管开口以上

→胆囊不大甚至缩小(废用性萎缩)

分型

Ⅰ(肝总管)、Ⅱ(汇合部)、Ⅲa(右肝管)、Ⅲb(左肝管)、Ⅳ(左右肝管)

治疗

I:切胆囊 & 肝外胆管 + 胆肠吻合

IIIa / IIIb:切胆囊 & 肝外胆管 & 部分肝 + 胆肠吻合

中、下段~

位于胆总管

→无痛、肿大的胆囊(Courvoisier征)

治疗

中段:切肿瘤 & ≥0.5cm的胆管 + 胆总管-空肠吻合

下段:Whipple术

最早、最常见扩散方式:直接蔓延

多为腺癌--高分化癌--预后好

出现早、波动性(有减退)

壶腹癌

*肿瘤极易坏死

胆总管结石

出现晚、进行性

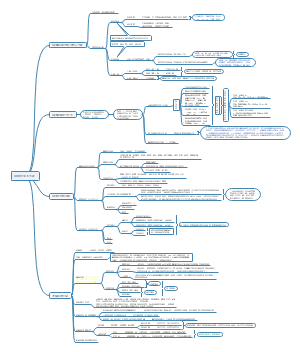

胰头癌

导管腺癌多见

5年生存率< 8%

表现

最常见,首发:上腹隐痛不适

最典型:黄疸、Courvoisier征(吸气时摸到无痛性光滑肿物—胆囊)

隐匿、早期诊断困难(胰腺—腹膜后器官,早期胰头癌肿很少触及)

检查

CA19-9

增强CT(不均匀、乏血供):诊断 & 评估可切除性

内镜超声:作为CT / MRI的补充;可评估切除性

钡餐:反“3”字征

ERCP:直接观察十二指肠壁有无癌肿浸润、可取活检

治疗

胰头十二指肠切除术(Whipple术)

适用于胰头癌、壶腹癌、下段胆管癌、十二指肠癌、胃泌素瘤

*胃泌素瘤

好发于胃泌素三角:胆总管起始处、十二指肠2、3部交界处、胰腺颈体交界处围成

Z-E综合征:顽固性消化性溃疡(十二指肠降部、水平部、空肠近段)+ 腹泻

60%~70%恶性

Whipple术切除肿瘤 + PPI(控制高胃酸)

*胰岛素瘤、胃泌素瘤区分良恶性主要依据生物学行为(侵犯、转移)

*胰岛素瘤

发生率:头=体=尾

<病理学>:尾>体>头

Whipple三联征

空腹 / 运动后出现低血糖症状(头晕、出汗、心慌)

发作葡萄糖 <2.2

*血糖总结

<2.2:Whipple三联征

<2.8 :正常人低血糖标准

<3.9 :糖尿病患者低血糖标准

补葡萄糖迅速缓解

90%单发、良性:首选手术

胆-肠吻合口漏、狭窄:细菌性肝脓肿 / 胆道感染

胰-肠吻合口漏:腹腔引流液—淀粉酶↑↑

胃肠吻合口漏、反流

高龄不耐受、肝转移:放化疗(但敏感性差)

*化疗药:吉西他滨

出现晚、进展慢(程度浅)、进行性

十二指肠腺癌

胆囊可肿大

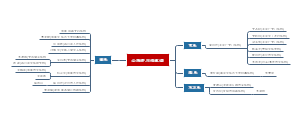

急性腹痛

Charcot三联征(胆绞痛 + 发热 + 黄疸)、WBC↑、转氨酶↑、胆红素↑

急性胆管炎

病因--肝总管/胆总管下段结石、胆肠吻合术后、肿瘤

表现:阵发性胆绞痛 + 波动性黄疸

随炎症发作、控制:黄疸—波动性

*胆管扩张的三联征--腹痛、腹部肿块、黄疸

B超/ MR、血淀粉酶

血淀粉酶(-)

禁食水+抗感染+抑酸+护肝+择期处理结石

血淀粉酶(+)

胆总管结石 + 胆管上下通畅

胆总管切开取石(十二指肠上段)+T管引流

结石嵌顿在胆总管开口

EST + 取石 + ENBD

胆总管远端狭窄(取石也无法解除梗阻)

胆管-空肠R-Y吻合 + 切胆囊

Reynolds五联征(+ 休克 + 中枢抑制)、WBC ↑(中性粒细胞)、Plt可↓

急性梗阻性化脓性胆管炎(AOSC)

病因--胆总管结石、胆道蛔虫症、胆道肿瘤;大肠杆菌

Reynolds征

胆血反流:胆道压力 >15~25cmH2O

>15:细菌可在外周血出现

<20时胆汁、淋巴液培养阴性,>25迅速变为阳性

治疗

抗感染+抗休克+立即紧急引流胆道(解除梗阻!而不是去除病因)

生命体征平稳

胆总管切开减压 +T管引流+胆囊切除

若既往胆囊已切除、高龄

ERCP + EST / ENBD

*缩写

PTC—经皮肝穿刺胆管造影

PTCD--经皮肝穿刺胆管引流

PTGD--经皮经肝胆囊穿刺引流术

ERCP--内镜逆行胰胆管造影术

治疗性ERCP

EST--内镜下Oddi括约肌切开术取石

ENBD--经内镜鼻胆管引流术

LC--腹腔镜胆囊切除

EUS--内镜超声(可显示层次结构)

生命体征很不平稳

PTCD+二期手术

*同时抗休克—补平衡盐溶液,无好转应纠酸

1~3个月后彻底手术根治—避免复发

钻顶样剧烈绞痛、轻度深压痛(症征不符);突发突止

胆道蛔虫症

B超+解痉止痛+口服驱虫治疗

右上腹痛、右肩背痛、发热、Murphy征(+)+WBC↑+腹部B超提示胆囊结石、胆囊壁增厚

急性胆石性胆囊炎

诊断--胆囊壁≥4mm

表现

持续性胆绞痛阵发加剧,多无黄疸

化脓→局限性腹膜炎,坏疽穿孔(底、颈多见)→弥漫性腹膜炎

边界不清的固定压痛肿块:发炎的胆囊被大网膜包裹

治疗:禁食水+补液+抗感染(三代头孢、甲硝唑)+解痉止痛+抑酸

有效

3个月后LC

无效、病程<3天

LC胆囊切除

病程 >3天(胆囊被大网膜包裹)

PTGD / 胆囊造口

3个月后LC

*对比非结石性胆囊炎

动脉粥样硬化(老年男性)、长期肠外营养(缺乏食物刺激—胆汁淤积)

*总结性别差异

胆囊疾病:女性(雌激素—抑制胆囊收缩)(eg.肝硬化—雌激素灭活↓—诱发胆囊结石)

Graves病:女性

*Graves眼病、周期性瘫痪:男性

风湿性疾病:女性

*强直性脊柱炎:男性

病情发展快、坏疽穿孔率高

首选B超(但不易早期诊断);核素、CT利于早期诊断

B超(胆系疾病首选)

胆囊癌:胆囊壁不均匀增厚,腔内有位置形态固定、血供丰富的肿物

急性胆囊炎:胆囊增大,壁毛糙增厚(>4mm)、双边征

胆囊结石:强回声团,后方声影、随体位改变而移动

对比水:无回声(液性暗区)

*水影像:B超—无回声,CT—低密度,MRCP—高信号(胆系疾病—胆汁—常用MRCP)

*B超强回声团

有声影--结石

*结石影像:B超—强回声,CT—密度可高可低(含钙量),MRCP—低信号(充盈缺损)

无声影--息肉

胆管扩张:肝内胆管 >0.4cm,肝外胆管 >1cm

*先天性胆管扩张症

I型(最常见):肝外胆管(尤其胆总管)囊性扩张

II型:胆总管侧壁局限性扩张呈憩室样

III型:胆总管十二指肠壁内段呈囊状膨出

IV型:肝内、外胆管扩张

V型(Caroli病):肝内胆管多发扩张伴肝纤维化;肝外胆管无扩张

表现

腹痛、腹部肿块、间歇性黄疸

10%癌变—应尽早完全切除扩张胆管 + 胆-肠R-Y吻合

合并局限肝内胆管扩张—需同时切除病变部分肝脏

胆管蛔虫:扩张的胆管内有双线状长条形平行强回声带(通心粉征),虫体在胆管内移动

胆管闭锁

分型

I:只涉及胆总管

II:肝管闭锁

III(最常见):肝门部胆管闭锁

表现

出生后1~2个月出现持续性黄疸、肝肿大、营养发育不良

苯巴比妥、激素治疗无效(与新生儿(溶血性)黄疸鉴别)

*苯巴比妥(肝药酶诱导剂):诱导肝脏生物转化—促进UCB → CB

治疗(尽可能在出生后2个月内手术)

肝门部胆管闭锁但肝内仍有胆管腔:肝门空肠吻合术(Kasai术)(P.437)

Kasai术后无效、肝内外胆管完全闭锁、已发生肝硬化

肝移植