导图社区 K8S(1)

- 284

- 5

- 1

- 举报

K8S(1)

K8S的思维导图,包括WHAT、HOW、Docker、istio、prometheus、etcd、service mesh、云原生等内容。

编辑于2022-11-11 22:20:23- 经验分享

- 计算机语言

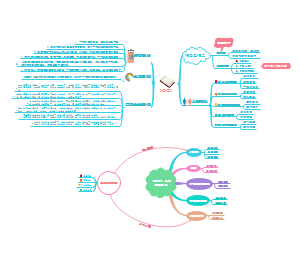

- 时间管理-读书笔记

时间管理-读书笔记,通过学习和应用这些方法,读者可以更加高效地利用时间,重新掌控时间和工作量,实现更高效的工作和生活。

- 设计史理解理论与方法⭐️(谢尔提·法兰2016)

本书是法兰教授的最新作品之一,主要阐明了设计史的来源、设计史现在的状况以及设计史的未来发展可能等三个基本问题。通过对设计史学科理论与方法的讨论,本书旨在促进读者对什么是设计史以及如何写作一部好的设计史等问题的深入认识与反思。

- 计算机组成原理

《计算机组成原理》涵盖了计算机系统的基本组成、数据的表示与运算、存储系统、指令系统、中央处理器(CPU)、输入输出(I/O)系统以及外部设备等关键内容。通过这门课程的学习,学生可以深入了解计算机硬件系统的各个组成部分及其相互之间的连接方式,掌握计算机的基本工作原理。

K8S(1)

社区模板帮助中心,点此进入>>

- 时间管理-读书笔记

时间管理-读书笔记,通过学习和应用这些方法,读者可以更加高效地利用时间,重新掌控时间和工作量,实现更高效的工作和生活。

- 设计史理解理论与方法⭐️(谢尔提·法兰2016)

本书是法兰教授的最新作品之一,主要阐明了设计史的来源、设计史现在的状况以及设计史的未来发展可能等三个基本问题。通过对设计史学科理论与方法的讨论,本书旨在促进读者对什么是设计史以及如何写作一部好的设计史等问题的深入认识与反思。

- 计算机组成原理

《计算机组成原理》涵盖了计算机系统的基本组成、数据的表示与运算、存储系统、指令系统、中央处理器(CPU)、输入输出(I/O)系统以及外部设备等关键内容。通过这门课程的学习,学生可以深入了解计算机硬件系统的各个组成部分及其相互之间的连接方式,掌握计算机的基本工作原理。

- 相似推荐

- 大纲

K8S

k8s

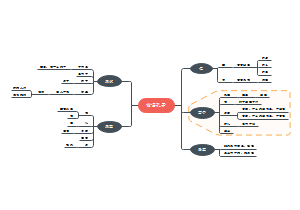

WHAT

架构图

WHY

(1)自动装箱

建构于容器之上,基于资源依赖及其他约束自动完成容器部署且不影响其可用性,并通过调度机制混合关键型应用和非关键型应用的工作负载于同一节点以提升资源利用率。

(2)自我修复(自愈)

支持容器故障后自动重启、节点故障后重新调度容器,以及其他可用节点、健康状态检查失败后关闭容器并重新创建等自我修复机制。

(3)水平扩展

支持通过简单命令或UI手动水平扩展,以及基于CPU等资源负载率的自动水平扩展机制。

(4)服务发现和负载均衡

Kubernetes通过其附加组件之一的KubeDNS(或CoreDNS)为系统内置了服务发现功能,它会为每个Service配置DNS名称,并允许集群内的客户端直接使用此名称发出访问请求,而Service则通过iptables或ipvs内建了负载均衡机制。

(5)自动发布和回滚

Kubernetes支持“灰度”更新应用程序或其配置信息,它会监控更新过程中应用程序的健康状态,以确保它不会在同一时刻杀掉所有实例,而此过程中一旦有故障发生,就会立即自动执行回滚操作。

(6)密钥和配置管理

Kubernetes的ConfigMap实现了配置数据与Docker镜像解耦,需要时,仅对配置做出变更而无须重新构建Docker镜像,这为应用开发部署带来了很大的灵活性。

此外,对于应用所依赖的一些敏感数据,如用户名和密码、令牌、密钥等信息,Kubernetes专门提供了Secret对象为其解耦,既便利了应用的快速开发和交付,又提供了一定程度上的安全保障。

(7)存储编排

Kubernetes支持Pod对象按需自动挂载不同类型的存储系统,这包括节点本地存储、公有云服务商的云存储

(8)批量处理执行

除了服务型应用,Kubernetes还支持批处理作业及CI(持续集成),如果需要,一样可以实现容器故障后恢复。

整体架构🍑

整体架构

图一

图二

图三

概述

图

核心知识

图

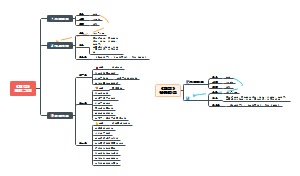

Node

runtime

runtime指的是容器运行环境,目前Kubernetes支持docker和rkt两种容器。

kube-proxy

实现服务发现和反向代理功能。

反向代理方面:kube-proxy支持TCP和UDP连接转发,默认基于Round Robin算法将客户端流量转发到与service对应的一组后端pod。

服务发现方面,kube-proxy使用etcd的watch机制,监控集群中service和endpoint对象数据的动态变化,并且维护一个service到endpoint的映射关系,从而保证了后端pod的IP变化不会对访问者造成影响。另外kube-proxy还支持session affinity。

运行在每个node上的代理组件,提供了tcp和udp的连接转发支持。

图

tu

工作原理使用iptables

监控集群中用户发布的服务,并完成负载均衡配置

每个节点的Kube-Proxy都会配置相同的负载均衡策略,使得整个集群的服务发现建立在分布式负载均衡器之上,服务调用无需经过额外的网络跳转(Network Hop)

kubelet

what

是Master在每个Node节点上面的agent

维护和管理Node上面的所有容器,

汇报当前节点的资源信息和健康状态;

Pod 的健康检查和状态汇报。

但是如果容器不是通过Kubernetes创建的,它并不会管理。

使Pod得运行状态与期望的状态一致。

每个kubelet会定时向master的apiserver汇报节点资源信息。

从不同源获取 Pod 清单,并按需求启停 Pod 的核心组件:

Pod 清单可从本地文件目录,给定的 HTTPServer 或 KubeAPIServer 等源头获取;

Kubelet 将运行时、网络和存储抽象成了 CRI,CNI,CSI。

how

图

在每个node中都会起一个kubelet的服务进程。该进程用于master下发到本节点的任务,管理pod和pod中的容器。

kubelet 的工作核心,就是一个控制循环,即:SyncLoop(图中的大圆圈)。

而驱动这个控制循环运行的事件,包括四种:Pod 更新事件;Pod 生命周期变化;kubelet 本身设置的执行周期;定时的清理事件。

kubelet 启动的时候,要做的第一件事情,就是设置 Listers,也就是注册它所关心的各种事件的 Informer。这些 Informer,就是 SyncLoop 需要处理的数据的来源。

kubelet 还负责维护着很多很多其他的子控制循环(也就是图中的小圆圈)。

这些控制循环的名字,一般被称作某某 Manager,比如 Volume Manager、Image Manager、Node Status Manager 等等。不难想到,这些控制循环的责任,就是通过控制器模式,完成 kubelet 的某项具体职责。

比如 Node Status Manager,就负责响应 Node 的状态变化,然后将 Node 的状态收集起来,并通过 Heartbeat 的方式上报给 APIServer。

再比如 CPU Manager,就负责维护该 Node 的 CPU 核的信息,以便在 Pod 通过 cpuset 的方式请求 CPU 核的时候,能够正确地管理 CPU 核的使用量和可用量。

kubelet 调用下层容器运行时的执行过程,并不会直接调用 Docker 的 API,而是通过一组叫作 CRI(Container Runtime Interface,容器运行时接口)的 gRPC 接口来间接执行的。

Pod

what

Pod是一个服务的多个进程的聚合单位,它由一个或者多个容器组成(例如Docker容器),它们共享容器存储、网络和容器运行配置项。

Pod是kubernetes中你可以创建和部署的最小也是最简单位。一个Pod代表着集群中运行的一个进程。

Pod中封装着应用的容器(有的情况下是好几个容器),存储、独立的网络IP,管理容器如何运行的策略选项。

Pod代表着部署的一个单位:kubernetes中应用的一个实例,可能由一个或者多个容器组合在一起共享资源。

Pod中共享的环境包括Linux的namespace,cgroup和其他可能的隔绝环境,这一点跟Docker容器一致

Pod中的容器总是被同时调度,有共同的运行环境

你可以把单个Pod想象成是运行独立应用的“逻辑主机”——其中运行着一个或者多个紧密耦合的应用容器

每个Pod都是应用的一个实例。如果你想平行扩展应用的话(运行多个实例),你应该运行多个Pod

创建流程

概要图

图

时序图

图

步骤

具体地,Pod 创建过程中每个模块的处理逻辑如下(这里我们以Containerd 为例,其他遵循CRI 的容器运行时的相关调用都是类似的):

(1)用户或者控制器通过kubectl、Rest API 或其他客户端向API Server 提交Pod 创建请求。

(2)API Server 将Pod 对象写入etcd 中进行永久性存储。如果写入成功,那么API Server会收到来自etcd 的确认信息并将创建结果返回给客户端。

(3)API Server 处就能反映出Pod 资源发生的变化,一个新的Pod 被创建出来。

(4)Scheduler 监听到API Server 处新的Pod 被创建。它首先会查看该Pod 是否已经被调度(spec.nodeName 是否为空)。如果该Pod 并没有被调度到任何节点,那么Scheduler会给它计算分配一个最优节点,并把它更新到spec.nodeName 中,从而完成Pod 的节点绑定。

(5)Scheduler 对Pod 的更新也将被API Server 写回到etcd 中。Scheduler 同样会监听到Pod 对象发生了变化。但是由于它已经调度过该Pod(spec.nodeName 不为空),所以它将不做任何处理。

(6)kubelet 也会一直监听API Server 处Pod 资源的变化。当其发现Pod 被分配到自己所在节点上(自身节点名称和Pod 的spec.nodeName 相等)时,kubelet 将会调用CRI gRPC向容器运行时申请启动容器。

(7)kubelet 首先会调用CRI 的RunPodSandbox 接口。Containerd 要确保PodSandbox(即Infra 容器)的镜像是否存在。因为所有PodSandbox 都使用同一个pause 镜像,如果节点上已经有运行的 Pod,那么这个 pause 镜像就已经存在。接着它会创建一个新的Network Namespace,调用CNI 接口为Network Namespace 设置容器网络,Containerd 会使用这个Network Namespace 启动PodSandbox。

(8)当PodSandbox 启动成功后,kubelet 才会在PodSandbox 下请求创建容器。这里kubelet 会先检查容器镜像是否存在,如果容器镜像不存在,则调用CRI 的PullImage 接口并通过Containerd 将容器镜像下载下来。

(9)当容器镜像下载完成后,kubelet 调用CRI 的CreateContainer 接口向容器运行时请求创建容器。

(10)当容器创建成功后,kubelet 调用CRI 的StartContainer 接口向容器运行时请求启动容器。

(11)无论容器是否创建和启动成功,kubelet 都会将最新的容器状态更新到Pod 对象的Status 中,让其他控制器也能够监听到Pod 对象的变化,从而采取相应的措施。

共享资源

一个Pod中的应用容器共享五种资源:

PID命名空间:Pod中的不同应用程序可以看到其他应用程序的进程ID。

网络命名空间:Pod中的多个容器能够访问同一个IP和端口范围。

IPC命名空间:Pod中的多个容器能够使用SystemV IPC或POSIX消息队列进行通信。

UTS命名空间:Pod中的多个容器共享一个主机名。

Volumes(共享存储卷):Pod中的各个容器可以访问在Pod级别定义的Volumes。

Pod的生命周期通过Replication Controller来管理;

通过模板进行定义,然后分配到一个Node上运行,在Pod所包含容器运行结束后,Pod结束。

Kubernetes为Pod设计了一套独特的网络配置,包括:为每个Pod分配一个IP地址,使用Pod名作为通信的主机名等。

安全策略

基于布尔值控制:这种类型的字段默认为最严格限制的值。

基于被允许的值集合控制:这种类型的字段会与这组值进行对比,以确认值被允许。

基于策略控制:设置项通过一种策略提供的机制来生成该值,这种机制能够确保指定的值落在被允许的这组值中。

图

生命周期

生命周期

挂起(Pending):

Pod 已被 Kubernetes 系统接受,但有一个或者多个容器镜像尚未创建。等待时间包括调度 Pod 的时间和通过网络下载镜像的时间,这可能需要花点时间。

运行中(Running):

该 Pod 已经绑定到了一个节点上,Pod 中所有的容器都已被创建。至少有一个容器正在运行,或者正处于启动或重启状态。

成功(Successed):

Pod 中的所有容器都被成功终止,并且不会再重启。

失败(Failed):

Pod 中的所有容器都已终止了,并且至少有一个容器是因为失败终止。也就是说,容器以非0状态退出或者被系统终止。

未知(Unkonwn):

因为某些原因无法取得 Pod 的状态,通常是因为与 Pod 所在主机通信失败。

容器探针

探针 是由 kubelet 对容器执行的定期诊断

成功:容器通过了诊断。

失败:容器未通过诊断。

未知:诊断失败,因此不会采取任何行动。

对Pod的健康状态通过三类探针来检查:LivenessProbe、ReadinessProbe及StartupProbe

其中最主要的探针为LivenessProbe与ReadinessProbe,kubelet会定期执行这两类探针来诊断容器的健康状况。

(1)LivenessProbe探针:

用于判断容器是否存活(Running状态),如果LivenessProbe探针探测到容器不健康,则kubelet将“杀掉”该容器,并根据容器的重启策略做相应的处理。如果一个容器不包含LivenessProbe探针,那么kubelet认为该容器的LivenessProbe探针返回的值永远是Success。

(2)ReadinessProbe探针:

用于判断容器服务是否可用(Ready状态),达到Ready状态的Pod才可以接收请求。

对于被Service管理的Pod,Service与Pod Endpoint的关联关系也将基于Pod是否Ready进行设置。

如果在运行过程中Ready状态变为False,则系统自动将其从Service的后端Endpoint列表中隔离出去,后续再把恢复到Ready状态的Pod加回后端Endpoint列表。这样就能保证客户端在访问Service时不会被转发到服务不可用的Pod实例上。

需要注意的是,ReadinessProbe也是定期触发执行的,存在于Pod的整个生命周期中。

(3)StartupProbe探针:

某些应用会遇到启动比较慢的情况,例如应用程序启动时需要与远程服务器建立网络连接,或者遇到网络访问较慢等情况时,会造成容器启动缓慢,此时ReadinessProbe就不适用了,因为这属于“有且仅有一次”的超长延时,可以通过StartupProbe探针解决该问题。

以上探针均可配置以下三种实现方式。

(1)ExecAction:在容器内部运行一个命令,如果该命令的返回码为0,则表明容器健康。 在下面的例子中,通过运行cat/tmp/health命令来判断一个容器运行是否正常。在该Pod运行后,将在创建/tmp/health文件10s后删除该文件,而LivenessProbe健康检查的初始探测时间(initialDelaySeconds)为15s,探测结果是Fail,将导致kubelet“杀掉”该容器并重启它:

(2)TCPSocketAction:通过容器的IP地址和端口号执行TCP检查,如果能够建立TCP连接,则表明容器健康。 在下面的例子中,通过与容器内的localhost:80建立TCP连接进行健康检查:

(3)HTTPGetAction:通过容器的IP地址、端口号及路径调用HTTP Get方法,如果响应的状态码大于等于200且小于400,则认为容器健康。 在下面的例子中,kubelet定时发送HTTP请求到localhost:80/_status/healthz来进行容器应用的健康检查:

对于每种探测方式,都需要设置initialDelaySeconds和timeoutSeconds两个参数,它们的含义分别如下。

◎ initialDelaySeconds:启动容器后进行首次健康检查的等待时间,单位为s。

◎ timeoutSeconds:健康检查发送请求后等待响应的超时时间,单位为s。当超时发生时,kubelet会认为容器已经无法提供服务,将会重启该容器。 如下代码片段是StartupProbe探针的一个参考配置,可以看到,这个Pod可以有长达30×10=300s的超长启动时间:

Kubernetes的Pod可用性探针机制可能无法满足某些复杂应用对容器内服务可用状态的判断,所以Kubernetes从1.11版本开始,引入了Pod Ready++特性对Readiness探测机制进行扩展,在1.14版本时达到GA稳定版本,称其为Pod Readiness Gates。Pod Readiness Gates给予了Pod之外的组件控制某个Pod就绪的能力,通过Pod Readiness Gates机制,用户可以设置自定义的Pod可用性探测方式来告诉Kubernetes某个Pod是否可用,具体使用方式是用户提供一个外部的控制器(Controller)来设置相应Pod的可用性状态。

Master

APIServer

图

apiserver主要包括认证、授权、准入、处理者四个处理逻辑。

对外提供RESTful的Kubernetes API服务,它是系统管理指令的统一入口,任何对资源进行增删改查的操作都要交给APIServer处理后再提交给etcd。

kubectl(Kubernetes提供的客户端工具,该工具内部就是对Kubernetes API的调用)是直接和APIServer交互的。

• 提供集群管理的 REST API 接口,包括:

• 认证 Authentication;

• 授权 Authorization;

• 准入 Admission(Mutating & Valiating)。

• 提供其他模块之间的数据交互和通信的枢纽(其他模块通过 API Server 查询或修改数据,只有 APIServer 才直接操作 etcd)。

• APIServer 提供 etcd 数据缓存以减少集群对 etcd 的访问。

controller manager

如果说APIServer做的是“前台”的工作的话,那controller manager就是负责“后台”的。

每个资源一般都对应有一个控制器,而controller manager就是负责管理这些控制器的。

比如我们通过APIServer创建一个pod,当这个pod创建成功后,APIServer的任务就算完成了。

而后面保证Pod的状态始终和我们预期的一样的重任就由controller manager去保证了。

Controller Manager 是集群的大脑,是确保整个集群动起来的关键;

其作用是确保 Kubernetes 遵循声明式系统规范,确保系统的真实状态(Actual State)与用户定义的期望状态(Desired State 一致);

Controller Manager 是多个控制器的组合,每个 Controller 事实上都是一个 control loop,负责侦听其管控的对象,当对象发生变更时完成配置;

Controller 配置失败通常会触发自动重试,整个集群会在控制器不断重试的机制下确保最终一致性( Eventual Consistency)。

原理

etcd

etcd是一个高可用的键值存储系统,Kubernetes使用它来存储各个资源的状态,从而实现了Restful的API。

组成

网路层:提供网路数据读写、监听服务端口,完成集群结点之间的数据通信,收发客户端数据。

raft模块:完整实现了raft协议。

存储模块:KV存储,wal存储,snapshot管理

复制状态机:状态机的数据维护在内存中,定期持久化到磁盘,每次写请求都会持久化到wal文件,根据写请求的内容修改状态机的数据。

raft分布式协议

组成

主节点leader

候选节点candidate

从节点flower

客户端只能从主节点写数据而从节点读取数据。

raft选主流程

初始化都是flower状态结点,等待100-300ms没有收到leader的心跳之后就变成了候选节点后给大家发选票,而候选人或得大多数结点的选票就变成了leader结点。

raft事务提交

每次提交事务先提交给leader,leader会暂存数据之后,复制数据到flower结点,等待大多数结点提交事务成功之后再将leader的事务提交。

raft选举超时是如何处理

等待时间短的结点会先发选票从而变为主节点。

但是如果2个候选或得的票数一样多则加时赛。直到选的票数最多的那个。

raft心跳超时

每个结点都会记录主节点是谁,并和主节点维持一个心跳超时时间,一旦没有收到主节点的回复从节点就要重新选举候选人结点。

raft的集群中断、脑裂问题并如何恢复

结点之间部分结点丢失通信,则会导致主节点的数据不能推给多个从节点也就主节点的数据不能进行提交。

集群恢复后,原来的主节点发现自己不是选票最多的结点就会变成从节点,并回滚日志,最后主节点再把数据推给从节点从而保证数据一致性。

scheduler

职责:负责调度pod到合适的Node上。

如果把scheduler看成一个黑匣子,那么它的输入是pod和由多个Node组成的列表,输出是Pod和一个Node的绑定,

即将这个pod部署到这个Node上。Kubernetes目前提供了调度算法,但是同样也保留了接口,用户可以根据自己的需求定义自己的调度算法。

主要是接收调度POD到合适的node节点上

通过apiserver,从etcd中获取资源信息进行调度

只负责调度工作,启动工作是node节点上的kubelet负责

调度策略:预算策略(predict)、优选策略(priorities)

架构设计

特殊的 Controller,工作原理与其他控制器无差别;

特殊职责:监控当前集群所有未调度的Pod,并且获取当前集群所有节点的健康状况和资源使用情况,为待调度 Pod 选择最佳计算节点,完成调度。

调度阶段分为:

• Predict:过滤不能满足业务需求的节点,如资源不足,端口冲突等。

• Priority:按既定要素将满足调度需求的节点评分,选择最佳节点。

• Bind:将计算节点与 Pod 绑定,完成调度。

调度过程

作用是把pod调度到最佳的node上去。需要根据不同的策略考虑node的资源使用情况例如端口、内存、存储等。

组件

核心组件

概述

tu1

1

图2

核心附件

附件(add-ons)用于扩展Kubernetes的基本功能,它们通常运行于Kubernetes集群自身之上,可根据重要程度将其划分为必要和可选两个类别。

网络插件

管理员需要从众多解决方案中根据需要及项目特性选择,常用的有Flannel、Calico、Canal、Cilium和Weave Net等。

KubeDNS

CoreDNS:Kubernetes使用定制的DNS应用程序实现名称解析和服务发现功能,它自1.11版本起默认使用CoreDNS——一种灵活、可扩展的DNS服务器;之前的版本中用到的是kube-dns项目,SkyDNS则是更早一代的解决方案。

Dashboard:基于Web的用户接口,用于可视化Kubernetes集群。

Dashboard可用于获取集群中资源对象的详细信息,

例如集群中的Node、Namespace、Volume、ClusterRole和Job等,

也可以创建或者修改这些资源对象。

容器资源监控系统:监控系统是分布式应用的重要基础设施

Kubernetes常用的指标监控附件有Metrics-Server、kube-state-metrics和Prometheus等。

集群日志系统:日志系统是构建可观测分布式应用的另一个关键性基础设施,用于向监控系统的历史事件补充更详细的信息,帮助管理员发现和定位问题;

Kubernetes常用的集中式日志系统是由ElasticSearch、Fluentd和Kibana(称之为EFK)组合提供的整体解决方案。

Ingress Controller:Ingress资源是Kubernetes将集群外部HTTP/HTTPS流量引入到集群内部专用的资源类型

它仅用于控制流量的规则和配置的集合,其自身并不能进行“流量穿透”,要通过Ingress控制器发挥作用;目前,此类的常用项目有Nginx、Traefik、Envoy、Gloo、kong及HAProxy等

在这些附件中,CoreDNS、监控系统、日志系统和Ingress控制器基础支撑类服务是可由集群管理的基础设施,而Dashboard则是提高用户效率和体验的可视化工具,类似的项目还有polaris和octant等

开放接口

CRI(Container Runtime Interface):容器运行时接口,提供计算资源

概述

每个容器运行时都有特点,因此不少用户希望Kubernetes能够支持更多的容器运行时。

Kubernetes从1.5版本开始引入了CRI接口规范,通过插件接口模式,Kubernetes无须重新编译就可以使用更多的容器运行时。

CRI包含Protocol Buffers、gRPC API、运行库支持及开发中的标准规范和工具。

Docker的CRI实现在Kubernetes 1.6中被更新为Beta版本,并在kubelet启动时默认启动。 可替代的容器运行时支持是Kubernetes中的新概念。

在Kubernetes 1.3发布时,rktnetes项目同时发布,让rkt容器引擎成为除Docker外的又一选择。

然而,不管是Docker还是rkt,都用到了kubelet的内部接口,同kubelet源码纠缠不清。这种程度的集成需要对kubelet的内部机制有非常深入的了解,还会给社区带来管理压力,这就给新生代容器运行时造成了难以跨越的集成壁垒。

CRI接口规范尝试用定义清晰的抽象层清除这一壁垒,让开发者能够专注于容器运行时本身。

CRI的主要组件

kubelet使用gRPC框架通过UNIX Socket与容器运行时(或CRI代理)进行通信。

kubelet是客户端,CRI代理(shim)是服务端

Protocol Buffers API包含两个gRPC服务:ImageService和RuntimeService。

◎ ImageService提供了从仓库中拉取镜像、查看和移除镜像的功能。

◎ RuntimeService负责Pod和容器的生命周期管理,以及与容器的交互(exec/attach/port-forward)。

rkt和Docker这样的容器运行时可以使用一个Socket同时提供两个服务,在kubelet中可以用--container-runtime-endpoint和--image-service-endpoint参数设置这个Socket。

Pod和容器的生命周期管理

Pod由一组应用容器组成,其中包含共有的环境和资源约束。在CRI里,这个环境被称为PodSandbox。

Kubernetes有意为容器运行时留下一些发挥空间,它们可以根据自己的内部实现来解释PodSandbox。对

于Hypervisor类的运行时,PodSandbox会具体化为一个虚拟机。其他例如Docker,会是一个Linux命名空间。

在v1alpha1 API中,kubelet会创建Pod级别的cgroup传递给容器运行时,并以此运行所有进程来满足PodSandbox对Pod的资源保障。 在启动Pod之前,kubelet调用RuntimeService.RunPodSandbox来创建环境。这一过程包括为Pod设置网络资源(分配IP等操作)。PodSandbox被激活之后,就可以独立地创建、启动、停止和删除不同的容器了。kubelet会在停止和删除PodSandbox之前首先停止和删除其中的容器。 kubelet的职责在于通过RPC管理容器的生命周期,实现容器生命周期的钩子、存活和健康监测,以及执行Pod的重启策略等。

RuntimeService服务包括对Sandbox和Container操作的方法,下面的伪代码展示了主要的RPC方法:

2.6.4 面向容器级别的设计思路

众所周知,Kubernetes的最小调度单元是Pod,它曾经可能采用的一个CRI设计就是复用Pod对象,使得容器运行时可以自行实现控制逻辑和状态转换,这样一来,就能极大地简化API,让CRI能够更广泛地适用于多种容器运行时。但是经过深入讨论之后,Kubernetes放弃了这一想法。 首先,kubelet有很多Pod级别的功能和机制(例如crash-loop backoff机制),如果交给容器运行时去实现,则会造成很重的负担;然后,Pod标准还在快速演进。很多新功能(如初始化容器)都是由kubelet完成管理的,无须交给容器运行时实现。 CRI选择了在容器级别进行实现,使得容器运行时能够共享这些通用特性,以获得更快的开发速度。这并不意味着设计哲学的改变—kubelet要负责、保证容器应用的实际状态和声明状态的一致性。 Kubernetes为用户提供了与Pod及其中的容器进行交互的功能(kubectl exec/attach/port-forward)。

kubelet目前提供了两种方式来支持这些功能:①调用容器的本地方法;②使用Node上的工具(例如nsenter及socat)。 因为多数工具都假设Pod用Linux namespace做了隔离,因此使用Node上的工具并不是一种容易移植的方案。在CRI中显式定义了这些调用方法,让容器运行时进行具体实现。下面的伪代码显示了Exec、Attach、PortForward这几个调用需要实现的RuntimeService方法: 目前还有一个潜在的问题是,kubelet处理所有的请求连接,使其有成为Node通信瓶颈的可能。在设计CRI时,要让容器运行时能够跳过中间过程。容器运行时可以启动一个单独的流式服务来处理请求(还能对Pod的资源使用情况进行记录),并将服务地址返回给kubelet。这样kubelet就能反馈信息给API Server,使之可以直接连接到容器运行时提供的服务,并连接到客户端。

CNI(Container Network Interface):容器网络接口,提供网络资源

添加网络、删除网络、添加网络列表、删除网络列表

CNI设计的时候考虑了以下问题

容器运行时必须在调用任何插件之前为容器创建一个新的网络命名空间。

然后,运行时必须确定这个容器应属于哪个网络,并为每个网络确定哪些插件必须被执行。

网络配置采用JSON格式,可以很容易地存储在文件中。网络配置包括必填字段,如name和type以及插件(类型)。网络配置允许字段在调用之间改变值。为此,有一个可选的字段args,必须包含不同的信息。

容器运行时必须按顺序为每个网络执行相应的插件,将容器添加到每个网络中

在完成容器生命周期后,运行时必须以相反的顺序执行插件(相对于执行添加容器的顺序)以将容器与网络断开连接。

容器运行时不能为同一容器调用并行操作,但可以为不同的容器调用并行操作

容器运行时必须为容器订阅ADD和DEL操作,这样ADD后面总是跟着相应的DEL

DEL可能跟着额外的DEL,但是,插件应该允许处理多个DEL(即插件DEL应该是幂等的)

容器必须由ContainerID唯一标识。存储状态的插件应该使用(网络名称,容器ID)的主键来完成。

运行时不能调用同一个网络名称或容器ID执行两次ADD(没有相应的DEL)。换句话说,给定的容器ID必须只能添加到特定的网络一次。

常用插件

CSI(Container Storage Interface):容器存储接口,提供存储资源

资源对象

通用设计:

TypeMeta

G(roup)

K(ind)

V(ersion)

Metadata

Namespace

Name

Labels & Annotation

Finalizers

ResourceVersion

SelftLink

描述文件定义

一个资源对象需要用5个字段来描述它,分别是Group/Version、Kind、MetaData、Spec、Status。这些字段定义在YAML或JSON文件中。

Kubernetes系统中的所有的资源对象都可以采用YAML或JSON格式的描述文件来定义,下面是某个Pod文件的资源对象描述文件。

YAML Manifest File Example代码示例如下:

资源对象描述文件说明如下。

apiVersion:指定创建资源对象的资源组和资源版本,其表现形式为<group>/<version>,若是core资源组(即核心资源组)下的资源对象,其表现形式为<version>。

kind:指定创建资源对象的种类。

metadata:描述创建资源对象的元数据信息,例如名称、命名空间等。

spec:包含有关Deployment资源对象的核心信息,告诉Kubernetes期望的资源状态、副本数量、环境变量、卷等信息。

status:包含有关正在运行的Deployment资源对象的信息。

每一个Kubernetes资源对象都包含两个嵌套字段,即spec字段和status字段。其中spec字段是必需的,它描述了资源对象的“期望状态”(Desired State),而status字段用于描述资源对象的“实际状态”(Actual State),它是由Kubernetes系统提供和更新的。在任何时刻,Kubernetes控制器一直努力地管理着对象的实际状态以与期望状态相匹配。

核心对象

对象分组

RESTful风格的API

以层级结构组织在一起,每个API群组表现为一个以/apis为根路径的RESTful路径,例如/apis/apps/v1,不过名称为core的核心群组有一个专用的简化路径:/api/v1。目前,常用的API群组可归为如下两类。

1)核心群组:RESTful路径为/api/v1,在资源的配置信息apiVersion字段中引用时可以不指定路径,而仅给出版本,例如apiVersion: v1,如上面的命令kubectl api-versions结果中最后一个群组所示。 2)命名的群组:RESTful路径为/apis/groupname/VERSION,例如/apis/apps/v1,在apiVersion字段中引用它时需要移除/apis前缀,例如apiVersion: apps/v1等。 名称空间级别的每一个资源类型在API的URL路径表示都可简单抽象为形如/apis/<group>/<version>/namespaces/<namespace>/<kind-plural>的路径。例如default名称空间中,Deployment类型的路径为/apis/apps/v1/namespaces/default/deployments,通过此路径可获取到default名称空间中所有Deployment对象的列表。

API Server接收和返回的所有JSON对象都遵循同一个模式,即它们都具有kind和apiVersion字段,分别用于标识对象所属的资源类型、API群组及相关的版本,可合称为类型元数据(TypeMeta)。同时,大多数的对象或列表类型的资源还会有metadata、spec和status这3个嵌套型的字段。其中metadata字段为资源提供元数据信息,例如名称、隶属的名称空间和标签等,因而也称为对象元数据(ObjectMeta);spec字段则是由用户负责声明对象期望状态的字段,不同资源类型的期望状态描述方式各不相同,因此其嵌套支持的字段也不尽相同;而status字段则记录活动对象的当前状态信息,也称为观察状态,它由Kubernetes系统自行维护,对用户来说为只读字段,不需要在配置清单中提供,而是在查询集群中的对象时由API Server在响应中返回。 每个资源类型代表一种特定格式的数据结构,它接收并返回该格式的对象数据,同时,一个对象也可嵌套多个独立的“小”对象,并支持每个小对象的单独管理操作。例如对Pod类型的资源来说,用户可创建、更新或删除Pod对象,而每个Pod对象的metadata、spec和status字段的值又是各自独立的对象型数据,所以它们可被单独操作。需要注意的是,status对象由Kubernetes系统单独进行自动更新,且不支持用户手动操作。

图

图2

API Groups(API组) 为了更容易扩展、升级和演进API,Kubernetes将API分组为多个逻辑集合,称之为API Groups,它们支持单独启用或禁用,在不同的API Groups中使用不同的版本,允许各组以不同的速度演进,例如apps/v1、apps/v1beta2、apps/v1beta1等。API Groups以REST URL中的路径进行定义并区别彼此,每个API Group群组都表现为一个以/apis为根路径的rest路径,不过核心群组Core有个专用的简化路径/api/v1,当前支持以下两类API Groups。 (1)Core Groups(核心组),也可以称之为Legacy Groups。其作为Kubernetes核心的API,在资源对象的定义中被表示为“apiVersion:v1”,我们常用的资源对象大部分都在这个组里,例如Container、Pod、ReplicationController、Endpoint、Service、ConfigMap、Secret、Volume等。 (2)具有分组信息的API,以/apis/$GROUP_NAME/$VERSION URL路径进行标识,例如apiVersion:batch/v1、apiVersion:extensions:v1beta1、apiVersion:apps/v1beta1等。比如/apis/apps/v1在apiversion字段中的格式为“$GROUP_NAME/$VERSION”。下面是常见的一些分组说明。 ◎ apps/v1:是Kubernetes中最常见的API组,其中包含许多核心对象,主要与用户应用的发布、部署有关,例如Deployments,RollingUpdates和ReplicaSets。 ◎ extensions/VERSION:扩展API组,例如DaemonSets、ReplicaSet和Ingresses都在此版本中有重大更改。 ◎ batch/VERSION:包含与批处理和类似作业的任务相关的对象,例如Job,包括v1与v1beta1两个版本。 ◎ autoscaling/VERSION:包含与HPA相关的资源对象,目前有稳定的v1版本。 ◎ certificates.k8s.io/VERSION:包含集群证书操作相关的资源对象。 ◎ rbac.authorization.k8s.io/v1:包含RBAC权限相关的资源对象。 ◎ policy/VERSION:包含Pod安全性相关的资源对象。 如果需要实现自定义的资源对象及相应的API,则使用CRD进行扩展是最方便的。 例如,Pod的API说明如图9.5所示,由于Pod属于核心资源对象,所以不存在某个扩展API Group,页面显示为Core,在Pod的定义中为“apiVersion:v1”。 StatefulSet则属于名为apps的API组,版本号为v1,在StatefulSet的定义中为“apiVersion:apps/v1”,如图9.6所示

对象关系

关系图

对象介绍

资源分类

工作负载型资源

用于确保Pod资源对象更好地运行容器化应用。

具有同一种负载的各Pod对象需要以负载均衡的方式服务于各请求,而各种容器化应用需要彼此发现以完成工作协同。Pod资源具有生命周期,

存储型资源能够为重构的Pod对象提供持久化数据存储机制,

配置型资源能够让共享同一配置的Pod资源从中统一获取配置改动信息。这些资源作为“配置中心”为管理容器化应用的配置文件提供了极为便捷的管理机制。

集群型资源为管理集群本身的工作特性提供了配置接口,

元数据型资源用于配置集群内部其他资源的行为。

集群型资源

Kubernetes还存在一些用于定义集群自身配置信息的资源类型,它们不属于任何名称空间且仅应该由集群管理员操作。常用的集群型资源有如下几种。

Namespace:名称空间,为资源对象的名称提供了限定条件或作用范围,它为使用同一集群的多个团队或项目提供了逻辑上的隔离机制,降低或消除了资源对象名称冲突的可能性。

Kubernetes集群会内置如下4个名称空间,其中第4个名称空间是为kubelet引入租约机制后才新增的。

·default:创建名称空间级别的资源对象,但未指定从属的名称空间时将默认使用defaut名称空间。

·kube-public:用于为集群上的所有用户(包括匿名用户)提供一个公共可用的名称空间,保留给集群使用,以防某些资源在整个集群中公开可见;该名称空间的公共属性仅是约定,并非强制要求。

·kube-system:用于部署与Kubernetes系统自身相关的组件,例如kube-proxy、CNI网络插件,甚至是kube-apiserver、kube-controller-manager和kube-scheduler等控制平面组件的静态Pod等;不建议在该名称空间中运行与系统无关的工作负载。

·kube-node-lease:目前是专用于放置kubelet lease对象的名称空间,这些对象对于Kubernetes系统自身健康运行至关重要;因而同样不建议在该名称空间中运行与系统无关的工作负载。

Node:Kubernetes并不能直接管理其工作节点,但它会把由管理员添加进来的任何形式(物理机或虚拟机等)的工作节点映射为一个Node资源对象,因而节点名称(标识符)在集群中必须唯一。

Role:角色,隶属于名称空间,代表名称空间级别由规则组成的权限集合,可被RoleBinding引用。

ClusterRole:集群角色,隶属于集群而非名称空间,代表集群级别的、由规则组成的权限集合,可被RoleBinding和ClusterRoleBinding引用。

RoleBinding:用于将Role中的许可权限绑定在一个或一组用户之上,从而完成用户授权,它隶属于且仅能作用于名称空间级别。

ClusterRoleBinding:将ClusterRole中定义的许可权限绑定在一个或一组用户之上,通过引用全局名称空间中的ClusterRole将集群级别的权限授予指定用户。

工作负载型资源

Pod用于承载容器化应用,代表着Kubernetes之上工作负载的表现形式。它负责运行容器,并为容器解决环境性的依赖,例如向容器注入临时或持久化的存储空间、配置信息或密钥数据等。而诸如滚动更新、扩容和缩容一类的编排任务则由“控制器”对象负责,专用于Pod编排任务的控制器也可统称为Pod控制器。

应用程序分为无状态和有状态两种类型,无状态应用中的每个Pod实例均可被其他同类实例所取代,但有状态应用的每个Pod实例均有其独特性,必须单独标识和管理,因而它们分别由两种不同类型的Pod控制器进行管理。例如,ReplicationController、ReplicaSet和Deployment负责管理无状态应用,StatefulSet则用于管控有状态类应用。还有些应用较为独特,有些需要在集群中的每个节点上运行单个Pod资源,负责收集日志或运行系统服务等任务,该类编排操作由DaemonSet控制器对象进行,而需要在正常完成后退出故无须始终处于运行状态任务的编排工作则隶属Job控制器对象。CronJob控制器对象还能为Job型的任务提供定期执行机制。

ReplicationController:用于确保每个Pod副本在任一时刻均能满足目标数量,即它用于保证每个容器或容器组总是运行并可访问;它是上一代的无状态Pod应用控制器,建议读者使用新型控制器Deployment和ReplicaSet来取代它。

ReplicaSet:新一代ReplicationController,它与ReplicationController唯一不同之处在于支持的标签选择器不同,ReplicationController只支持“等值选择器”,而ReplicaSet还支持基于集合的选择器。

Deployment:用于管理无状态的持久化应用,例如HTTP服务等;它用于为Pod和ReplicaSet提供声明式更新,是构建在ReplicaSet之上的、更为高级的控制器。

StatefulSet:用于管理有状态的持久化应用,例如数据库服务程序;与Deployment的不同之处在于,StatefulSet会为每个Pod创建一个独有的持久性标识符,并会确保各Pod间的顺序性。

DaemonSet:用于确保每个节点都运行了某Pod的一个副本,包括后来新增的节点;而节点移除将导致Pod回收;DaemonSet常用于运行各类系统级守护进程,例如kube-proxy和Flannel网络插件,以及日志收集和临近系统的Agent应用,例如fluentd、Logstash、Prometheus的Node Exporter等。

Job:用于管理运行完成后即可终止的应用,例如批处理作业任务;Job创建一个或多个Pod,并确保其符合目标数量,直到应用完成而终止。

Service

应用服务的抽象

通过 labels 为应用提供负载均衡和服务发现

匹配 labels的 Pod IP和端口列表组成 endpoints

由 Kube-proxy 负责将服务 IP 负载均衡到这些 endpoints 上

每个默认类型 Service 都会自动分配一个 cluster IP(仅在集群内部可访问的虚拟地址)和 DNS名

其他容器可以通过该地址或 DNS 来访问服务,而不需要了解后端容器的运行

RC、RS 和 Deployment 只是保证了支撑服务的微服务 Pod 的数量,但是没有解决如何访问这些服务的问题。一个 Pod 只是一个运行服务的实例,随时可能在一个节点上停止,在另一个节点以一个新的 IP 启动一个新的Pod,因此不能以确定的 IP 和端口号提供服务。

要稳定地提供服务需要服务发现和负载均衡能力

服务发现完成的工作,是针对客户端访问的服务,找到对应的的后端服务实例

在 Kubernetes 集群中,客户端需要访问的服务就是 Service对象

每个 Service 会对应一个集群内部有效的虚拟 IP,集群内部通过虚拟 IP 访问一个服务

在 Kubernetes 集群中微服务的负载均衡是由 Kube-proxy 实现的

Kube-proxy 是 Kubernetes 集群内部的负载均衡器。它是一个分布式代理服务器,在 Kubernetes 的每个节点上都有一个;这一设计体现了它的伸缩性优势,需要访问服务的节点越多,提供负载均衡能力的 Kube-proxy 就越多,高可用节点也随之增多。与之相比,我们平时在服务器端使用反向代理作负载均衡,还要进一步解决反向代理的高可用问题。

Deployment

部署表示用户对 Kubernetes 集群的一次更新操作。

部署是一个比 RS 应用模式更广的 API 对象,可以是创建一个新的应用,更新一个已存在的应用,也可以是滚动升级一个应用。

滚动升级一个服务,实际是创建一个新的 RS,然后逐渐将新 RS 中副本数增加到理想状态,将旧 RS 中的副本数减小到 0 的复合操作;这样一个复合操作用一个 RS 是不太好描述的,所以用一个更通用的 Deployment 来描述。以 Kubernetes 的发展方向,未来对所有长期伺服型的的业务的管理,都会通过 Deployment 来管理。

DaemonSet

用于确保每个节点都运行了某Pod的一个副本,包括后来新增的节点;

而节点移除将导致Pod回收;

DaemonSet常用于运行各类系统级守护进程,例如kube-proxy和Flannel网络插件,以及日志收集和临近系统的Agent应用,例如fluentd、Logstash、Prometheus的Node Exporter等。

StatefulSet

用于管理有状态的持久化应用,例如数据库服务程序;与Deployment的不同之处在于,StatefulSet会为每个Pod创建一个独有的持久性标识符,并会确保各Pod间的顺序性。

CustomResourceDefinition

CustomResourceDefinition 是指自定义资源定义,简称CRD,

是Kubernetes 1.7 中引入的一项强大功能,它允许用户将自己的自定义对象添加到Kubernetes 集群中。

当创建新CRD 的定义时,API Server 将为指定的每个版本创建一个新的RESTful 资源路径

当集群中成功地创建了CRD,就可以像Kubernetes 原生的资源一样使用它,利用Kubernetes 的所有功能,例如其CLI、安全性、API 服务、RBAC 等。

CRD 的定义是在集群范围内的,CRD 的资源对象的作用域可以是命名空间(Namespaced)或者集群范围(Cluster-wide)。

与现有的内置对象一样,删除Namespace 也会删除该Namespace中所有自定义的对象,但不会删除CRD 的定义。

Kubernetes 还提供一系列Codegen 工具(deepcopy-gen、client-gen、lister-gen、informer-gen 等),能够自动生成该CRD 资源的Golang 版本的Clientset、Lister 及Informer,这为该资源编写控制器提供了很大便利。

CRD 就像数据库的开放式表结构,允许用户自定义Schema。有了这种开放式设计,用户可以基于CRD 定义一切需要的模型,满足不同业务的需求。社区鼓励基于CRD 的业务抽象,众多主流的扩展应用都是基于CRD 构建的,比如Istio、Knative。甚至基于CRD推出了Operator Mode 和Operator SDK,可以以极低的开发成本定义新对象,并构建新对象的控制器。

对象类资源配置规范

Kubernetes内置资源

资源组 资源种类 说 明

apps

ControllerRevision 记录资源对象所有的历史版本的资源类型

DaemonSet 在Pod资源对象的基础上提供守护进程的 资源类型

Deployment 在Pod资源对象的基础上提供支持无状态 服务的资源类型

RcplicaSet 在Pod资源对象的基倨上提供Pod副本的资源类型

StatefulSet 在Pod资源对象的基册上提供支持有状态服务的资源类型

auditregistration.k8s.io

AuditSink 审计资源类型

authentication.k8s.io

TokcnRcvicw 认证资源类型

authorization.k8s.io

LocalSubjectAccessReview 授权检査用户是否珥以在指定的命名空间 中执行操作

SelfSubjcctAccessRcvicw 授权检查用户是否可以执行操作(若不指 定spec.namespace,则在所冇的命名空间中 执行操作)

SelfSubjectRulesReview 授权枚挙用户叫以在指定的命名空间屮执 行一组操作

SubjcctAcccssRcvicw 授权检查用户是否可以执行操作

autoscaling

HorizontalPodAutoscalcr 在Pod资源对象的基础上提供水平自动伸 缩资源类型

batch

Job 提供一次性任务的资源类型

CronJob 提供定时任务的资源类型

ccrtificatcs.k8s.io

CcrtificateSigningRcqucst 提供讯书管理的资源类型

coordination.k8s.io

Leases 提供领导者选举机制的资源类型

core

node.k8s.io

RuntimeClass 提供容器运行时功能的资源类型

policy

Evictions 在Pod资源对象的基础上提供駅逐策略的 资源类型

PodDisruptionBudget 提供限制同时中断Pod的数量.以保证集 群的高可用性

PodSecurityPolicy 提供控制Pod资源安全相关策略的资源类 型

rbac.authorization.k8s.io

ClusterRole 提供RBAC集群角色的资源类型

ClustcrRoleBinding 提供RBAC集群布色绑定的资源类型

Role 提供RBAC角色的资源类型

RoleBinding 提供RBAC角色绑定的资源类型

scheduling.k8s.io PriorityClass 提供Pod资源对象优先级管理的资源类型

scttings.k8s.io PodPrcsct 在创建Pod资源对象时,可以将特定信息 注入Pod资源对象申

core

Componentstatus 该资源类型已被弃用,其用于提供获取 Kubemeles组件运行状况的资源类型

ConfigMap 提供容器内应用程序配置管理的资源类型

Endpoints 提供将外部服务器映射为内部服务的资源

Event 提供Kubemetes集群事件管理的资源类型

LimitRange 为命名空间中的每种资源对象设置资源 (硬件资源)使用限制

Namespace 提供资源对象所在的命名空间的资源类型

Node 提供Kubemetes集詳中管理T.作节点的资 源类型。每个节点都有一个唯一标识符

PersistentVolume 提供PV存储的资源类型

Persistent VolutncClaiin 提供PVC存储的资源类型

Pod 提供容器集合管理的资源类環

PodTemplate 提供用于描述预定义Pod资源对象副本数 模板的资源类型

Replicationcontroller 在Pod资源对象的基础上提供副本数保持 不变的资源类型

RcsourccQuota 提供每个命名空间配额限制的资源类型

Secret 提供有储密码、Token、密钥等敏感数据的 资源类型

Service 提供负载均衡器为Pod资源对象的代理服 务的资源类型

ServiceAccount 提供ServiceAccount认证的资源类型

events.k8s.io

Event 提供Kubemetes集群事件管理的资源类型

networking.k8s.io

RuntimcClass 提供容崙込行时功能的资源类型

Ingress 提供从Kubemetes集群外部访问集群内部 服务管理的资源类型

4

参考

【掌阅】Kubernetes源码剖析

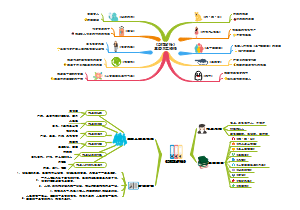

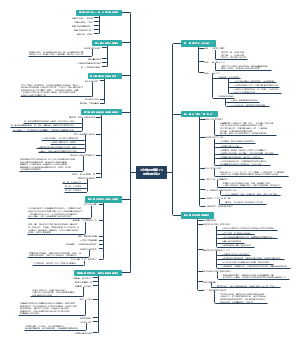

HOW

资源管理

计算资源管理

调度器

图

样例

两个控制循环

1、第一个控制循环称为 Informer Path,

主要工作是启动一系列 Informer,用来监听(Watch)集群中 Pod、Node、Service 等与调度相关的 API 对象的变化。比如,当一个待调度 Pod 被创建出来之后,调度器就会通过 Pod Informer 的 Handler,将这个待调度 Pod 添加进调度队列;

同时,调度器还要负责对调度器缓存 Scheduler Cache 进行更新,并以这个 cache 为参考信息,来提高整个调度流程的性能。

2、第二个控制循环即为对 pod 进行调度的主循环,称为 Scheduling Path。

这一循环的工作流程是不断地从调度队列中取出待调度的 pod,运行两个步骤的算法,来选出最优 node

在集群的所有节点中选出所有“可以”运行该 pod 的节点,这一步被称为 Predicates;

在上一步选出的节点中,根据一系列优选算法对节点打分,选出“最优”即得分最高的节点,这一步被称为 Priorities。

调度完成之后,调度器就会为 pod 的 spec.NodeName 赋值这个节点,这一步称为 Bind。

而为了不在主流程路径中访问 Api Server 影响性能,调度器只会更新 Scheduler Cache 中的相关 pod 和 node 信息:这种基于乐观假设的 API 对象更新方式,在 K8s 中称为 Assume。

之后才会创建一个 goroutine 来异步地向 API Server 发起更新 Bind 操作,这一步就算失败了也没有关系,Scheduler Cache 更新后就会一切正常。

NodeAffinity:Node亲和性调度

是用于替换NodeSelector的全新调度策略。有两种节点亲和性表达。

◎ RequiredDuringSchedulingIgnoredDuringExecution:必须满足指定的规则才可以调度Pod到Node上(功能与nodeSelector很像,但是使用的是不同的语法),相当于硬限制。

◎ PreferredDuringSchedulingIgnoredDuringExecution:强调优先满足指定规则,调度器会尝试调度Pod到Node上,但并不强求,相当于软限制。多个优先级规则还可以设置权重(weight)值,以定义执行的先后顺

PodAffinity:Pod亲和与互斥调度策略

在实际的生产环境中有一类特殊的Pod调度需求:

存在某些相互依赖、频繁调用的Pod,它们需要被尽可能地部署在同一个Node节点、机架、机房、网段或者区域(Zone)内,这就是Pod之间的亲和性;

反之,出于避免竞争或者容错的需求,我们也可能使某些Pod尽可能地远离某些特定的Pod,这就是Pod之间的反亲和性或者互斥性。

Pod间的亲和性与反亲和性调度策略从Kubernetes 1.4版本开始引入。简单地说,就是相关联的两种或多种Pod是否可以在同一个拓扑域中共存或者互斥,前者被称为Pod Affinity,后者被称为Pod Anti Affinity。

那么,什么是拓扑域,

一个拓扑域由一些Node节点组成,这些Node节点通常有相同的地理空间坐标,比如在同一个机架、机房或地区,我们一般用region表示机架、机房等的拓扑区域,用Zone表示地区这样跨度更大的拓扑区域。在极端情况下,我们也可以认为一个Node就是一个拓扑区域。

为此,Kubernetes内置了如下一些常用的默认拓扑域: ◎ kubernetes.io/hostname; ◎ topology.kubernetes.io/region; ◎ topology.kubernetes.io/zone。 需要注意的是,以上拓扑域是由Kubernetes自己维护的,在Node节点初始化时,controller-manager会为Node打上许多标签,比如kubernetes.io/hostname这个标签的值就会被设置为Node节点的hostname。另外,公有云厂商提供的Kubernetes服务或者使用cloud-controller-manager创建的集群,还会给Node打上topology.kubernetes.io/region和topology.kubernetes.io/zone标签,以确定各个节点所属的拓扑域。

Taints和Tolerations(污点和容忍)

前面介绍的NodeAffinity节点亲和性,是在Pod上定义的一种属性,使得Pod能够被调度到某些Node上运行(优先选择或强制要求)。Taint则正好相反,它让Node拒绝Pod的运行。

简单地说,被标记为Taint的节点就是存在问题的节点,比如磁盘要满、资源不足、存在安全隐患要进行升级维护,希望新的Pod不会被调度过来,但被标记为Taint的节点并非故障节点,仍是有效的工作节点,所以仍需将某些Pod调度到这些节点上时,可以通过使用Toleration属性来实现。 在默认情况下,在Node上设置一个或多个Taint之后,除非Pod明确声明能够容忍这些污点,否则无法在这些Node上运行。可以用kubectl taint命令为Node设置Taint信息: 这个设置为node1加上了一个Taint。该Taint的键为key,值为value,Taint的效果是NoSchedule。这意味着除非Pod明确声明可以容忍这个Taint,否则不会被调度到node1上。 然后,需要在Pod上声明Toleration。

下面的两个Toleration都被设置为可以容忍(Tolerate)具有该Taint的Node,使得Pod能够被调度到node1上: 或 Pod的Toleration声明中的key和effect需要与Taint的设置保持一致,并且满足以下条件之一。

◎ operator的值是Exists(无须指定value)。

◎ operator的值是Equal并且value相等。 如果不指定operator,则默认值为Equal。 另外,有如下两个特例。

◎ 空的key配合Exists操作符能够匹配所有键和值。

◎ 空的effect匹配所有effect。 在上面的例子中,effect的取值为NoSchedule,还可以取值为PreferNoSchedule,这个值的意思是优先,也可以算作NoSchedule的软限制版本—一个Pod如果没有声明容忍这个Taint,则系统会尽量避免把这个Pod调度到这一节点上,但不是强制的。后面还会介绍另一个effect“NoExecute”。 系统允许在同一个Node上设置多个Taint,也可以在Pod上设置多个Toleration。Kubernetes调度器处理多个Taint和Toleration的逻辑顺序为:首先列出节点中所有的Taint,然后忽略Pod的Toleration能够匹配的部分,剩下的没被忽略的Taint就是对Pod的效果了。下面是几种特殊情况。

◎ 如果在剩余的Taint中存在effect=NoSchedule,则调度器不会把该Pod调度到这一节点上。

定义Pod驱逐行为,以应对节点故障 前面提到的NoExecute这个Taint效果对节点上正在运行的Pod有以下影响。

◎ 没有设置Toleration的Pod会被立刻驱逐。

◎ 配置了对应Toleration的Pod,如果没有为tolerationSeconds赋值,则会一直留在这一节点中。

◎ 配置了对应Toleration的Pod且指定了tolerationSeconds值,则会在指定的时间后驱逐。注意,在节点发生故障的情况下,系统将会以限速(rate-limiting)模式逐步给Node设置Taint,这样就能避免在一些特定情况下(比如Master暂时失联)有大量的Pod被驱逐。

Kubernetes会自动给Pod添加下面几种Toleration:

◎ key为node.kubernetes.io/not-ready,并配置tolerationSeconds=300;

◎ key为node.kubernetes.io/unreachable,并配置tolerationSeconds=300。

以上添加的这种自动机制保证了在某些节点发生一些临时性问题时,Pod默认能够继续停留在当前节点运行5min等待节点恢复,而不是立即被驱逐,从而避免系统的异常波动。 另外,Kubernetes从1.6版本开始引入两个与Taint相关的新特性:TaintNodesByCondition及TaintBasedEvictions,用来改善异常情况下的Pod调度与驱逐问题,比如在节点内存吃紧、节点磁盘空间已满、节点失联等情况下,是否自动驱逐某些Pod或者暂时保留这些Pod等待节点恢复正常。这个过程的完整逻辑基本如下。 (1)不断地检查所有Node状态,设置对应的Condition。

(2)不断地根据Node Condition设置对应的Taint。 (

3)不断地根据Taint驱逐Node上的Pod。

资料

https://mp.weixin.qq.com/s/ntF3yyFcmvHVraTNbKvANg

控制器

图

控制器是支撑Kubernetes声明式API的关键组件

持续监视对API Server上的API对象的添加、更新和删除等更改操作,并在发生此类事件时执行目标对象相应的业务逻辑,从而将客户端的管理指令转为对象管理所需要的真正的操作过程。

简单来说,一个具体的控制器对象是一个控制循环程序,它在单个API对象上创建一个控制循环以确保该对象的状态符合预期。

不同类型的Pod控制器在不同维度完成符合应用需求的管理模式,

例如Deployment控制器资源可基于“Pod模板”创建Pod实例,并确保实例数目精确反映期望的数量;

另外,控制器还支持应用规模中Pod实例的自动扩容、缩容、滚动更新和回滚,以及创建工作节点故障时的重建等运维管理操作。

StatefulSet控制器专用于管理有状态应用的Pod实例,其他常用的Pod控制器还有ReplicaSet、DaemonSet、Job和CronJob等,分别用于不同控制模型的工作负载

资源管理

1.计算资源管理(Compute Resources)

计算资源的配置项分为两种:

一种是资源请求(Resource Requests,简称Requests),

表示容器希望被分配到的、可完全保证的资源量,

Requests 的值会提供给 Kubernetes 调度器(Kubernetes Scheduler)以便于优化基于资源请求的容器调度;

另外一种是资源限制(Resource Limits,简称 Limits),

Limits 是容器最多能使用到的资源量的上限,这个上限值会影响节点上发生资源竞争时的解决策略。

Pod中的每个容器都可以配置以下4个参数。

spec.container[].resources.requests.cpu.

spec.container[].resources.limits.cpu.

spec.container[].resources.requests.memory.

spec.container[].resources.limits.memory.

◎ Requests和Limits都是可选的。在某些集群中如果在Pod创建或者更新时,没设置资源限制或者资源请求值,那么可能会使用系统提供一个默认值,这个默认值取决于集群的配置。

◎ 如果Request没有配置,那么默认会被设置为等于Limits。

◎ 而任何情况下Limits都应该设置为大于或者等于Requests。

基于Requests和Limits的Pod调度机制

当一个Pod创建成功时,Kubernetes调度器(Scheduler)为该Pod选择一个节点(Node)来执行。对于每种计算资源(CPU和内存)而言,每个节点都有一个能用于运行Pod的最大容量值。

调度器在调度时,首先要确保调度后该节点上所有Pod的CPU和内存的Requests总和不能超过该节点能提供给Pod使用的CPU和内存的最大容量值。

Kubernetes提供了LimitRange机制对Pod和容器的Requests和Limits配置进一步做出限制。

1)创建一个namespace

2)为namespace设置LimitRange

Kubernetes中Pod的Requests和Limits资源配置有如下特点:

如果Pod配置的Requests值等于Limits值,那么该Pod可以获得的资源是完全可靠的;

而如果Pod的Requests值小于Limits值,那么该Pod获得的资源可分成两部分:一部分是完全可靠的资源,资源量大小等于Requests值;

另外一部分是不可靠的资源,这部分资源最大等于Limits与Requests的差额值,这份不可靠的资源能够申请到多少,则取决于当时主机上容器可用资源的余量。 通过这种机制,Kubernetes可以实现节点资源的超售(Over Subscription),

比如在CPU完全充足的情况下,某机器共有32GiB内存可提供给容器使用,容器配置为Requests值1GiB,Limits值为2GiB,那么该机器上最多可以同时运行32个容器,每个容器最多可使用2GiB内存,如果这些容器的内存使用峰值错开,那么所有容器也可以一直正常运行。 超售机制能有效地提高资源的利用率,同时不会影响容器申请的完全可靠资源的可靠性。

4.资源的配额管理(Resource Quotas)

5.ResourceQuota和LimitRange实践指南

6.资源管理总结

Kubernetes中的资源管理的基础是容器和Pod的资源配置(Requests和Limits)。容器的资源配置(Requests和Limits)指定了容器请求的资源和容器能使用的资源上限,而Pod的资源配置则是Pod中所有容器的资源配置总和的上限。

通过资源配额(Resource Quota)机制,我们可以对命名空间下所有Pod使用资源的总量进行限制,

如果我们需要对用户的Pod或容器的资源配置做更多的限制,则我们可以使用资源配置范围(LimitRange)来达到这个目的。LimitRange可以有效地限制Pod和容器的资源配置的最大、最小范围,也可以限制Pod和容器的Limits与Requests的最大比例上限,此外LimitRange还可以为Pod中的容器提供默认的资源配置。

Kubernetes基于Pod的资源配置(Requests和Limits)实现了资源服务质量(QoS)。不同QoS级别的Pod在系统中拥有不同的优先级:高优先级的Pod具有更高的可靠性,可以用于运行可靠性要求较高的服务;而低优先级的Pod可以实现集群资源的超售,能有效地提高集群资源利用率。

网络资源管理

Kubernetes网络的基本概念和框架。

1.IP地址分配 Kubernetes使用各种IP范围为节点、Pod和服务分配IP地址。 ·系统会从集群的VPC网络为每个节点分配一个IP地址。该节点IP用于提供从控制组件(如Kube-proxy和Kubelet)到Kubernetes Master的连接; ·系统会为每个Pod分配一个地址块内的IP地址。用户可以选择在创建集群时通过--pod-cidr指定此范围; ·系统会从集群的VPC网络为每项服务分配一个IP地址(称为ClusterIP)。大部分情况下,该VPC与节点IP地址不在同一个网段,而且用户可以选择在创建集群时自定义VPC网络。

2.Pod出站流量 Kubernetes处理Pod的出站流量的方式主要分为以下三种:

Pod到Pod

在Kubernetes集群中,每个Pod都有自己的IP地址,运行在Pod内的应用都可以使用标准的端口号,不用重新映射到不同的随机端口号。所有的Pod之间都可以保持三层网络的连通性,比如可以相互ping对方,相互发送TCP/UDP/SCTP数据包。CNI就是用来实现这些网络功能的标准接口

。 Pod到Service

Pod的生命周期很短暂,但客户需要的是可靠的服务,因此Kubernetes引入了新的资源对象Service,其实它就是Pod前面的4层负载均衡器。Service总共有4种类型,其中最常用的类型是ClusterIP,这种类型的Service会自动分配一个仅集群内部可以访问的虚拟IP。 Kubernetes通过Kube-proxy组件实现这些功能,每台计算节点上都运行一个Kubeproxy进程,通过复杂的iptables/IPVS规则在Pod和Service之间进行各种过滤和NAT。

Pod到集群外

从Pod内部到集群外部的流量,Kubernetes会通过SNAT来处理。SNAT做的工作就是将数据包的源从Pod内部的IP:Port替换为宿主机的IP:Port。当数据包返回时,再将目的地址从宿主机的IP:Port替换为Pod内部的IP:Port,然后发送给Pod。当然,中间的整个过程对Pod来说是完全透明的,它们对地址转换不会有任何感知。 以上涉及的概念我们在后面的章节会进行详细讲解,本节只是抛砖引玉,不做深入分析。

跨主机容器网络方案

what

“三种IP”

◎ Node IP:Node节点的IP地址。

Node IP是Kubernetes集群中每个节点的物理网卡的IP地址,这是一个真实存在的物理网络,所有属于这个网络的服务器之间都能通过这个网络直接通信,不管它们中是否有部分节点不属于这个Kubernetes集群。这也表明了Kubernetes集群之外的节点访问Kubernetes集群之内的某个节点或者TCP/IP服务时,必须要通过Node IP进行通信。

◎ Pod IP:Pod的IP地址。

其次,Pod IP是每个Pod的IP地址,它是Docker Engine根据docker0网桥的IP地址段进行分配的,通常是一个虚拟的二层网络,前面我们说过,Kubernetes 要求位于不同 Node 上的Pod能够彼此直接通信,所以Kubernetes里一个Pod里的容器访问另外一个Pod里的容器,就是通过Pod IP所在的虚拟二层网络进行通信的,而真实的TCP/IP流量则是通过Node IP所在的物理网卡流出的。

◎ Cluster IP:Service的IP地址。

最后,我们说说Service的Cluster IP,它也是一个虚拟的IP,但更像是一个“伪造”的IP网络,原因有以下几点。

◎ Cluster IP仅仅作用于Kubernetes Service这个对象,并由Kubernetes管理和分配IP地址(来源于Cluster IP地址池)。

◎ Cluster IP无法被Ping,因为没有一个“实体网络对象”来响应。

◎ Cluster IP只能结合Service Port组成一个具体的通信端口,单独的Cluster IP不具备TCP/IP通信的基础,并且它们属于Kubernetes集群这样一个封闭的空间,集群之外的节点如果要访问这个通信端口,则需要做一些额外的工作。

◎ 在Kubernetes集群之内,Node IP网、Pod IP网与Cluster IP网之间的通信,采用的是Kubernetes自己设计的一种编程方式的特殊的路由规则,与我们所熟知的IP路由有很大的不同。

分层

图

本地通信

本地通信是Pod内部不同容器之间的通信。因为Pod内网容器共享同一个网络协议栈,所以它们之间的通信可以通过Loopback设备完成。

同节点Pod通信

同节点Pod之间的通信,是Cni0虚拟网桥内部的通信,相当于一个二层局域网内部设备通信。

跨节点Pod通信

步骤

图

网络包通过网络接口 eth1 离开 Pod 1,通过虚拟网络接口 veth1 到达 root netns。

网络包离开 veth1,到达 cni0,查找 Pod 6 的地址。

网络包离开 cni0,重定向到 eth0。

网络包从 Master 1 离开 eth0,到达网关。

网络包离开网关,通过工作节点 1 的网络接口 eth0 到达 root netns。

网络包离开 eth0,到达 cni0,并查找 Pod 6 的地址。

网络包离开 cni0,重定向到虚拟网络接口 veth6。

网络包通过虚拟地址接口 veth6 离开 root netns。

跨主通信”的三种主流实现方法

容器“跨主通信”的三种主流实现方法:UDP、host-gw、VXLAN。

UDP和VXLAN,它们都属于隧道模式,需要封装和解封装。

纯三层网络方案,host-gw模式和Calico项目。

Host-gw模式通过在宿主机上添加一个路由规则:

<目的容器IP地址段> via <网关的IP地址> dev eth0

IP包在封装成帧发出去的时候,会使用路由表里的“下一跳”来设置目的MAC地址。这样,它就会通过二层网络到达目的宿主机。

这个三层网络方案得以正常工作的核心,是为每个容器的IP地址,找到它所对应的,“下一跳”的网关。所以说,Flannel host-gw模式必须要求集群宿主机之间是二层连通的,如果宿主机分布在了不同的VLAN里(三层连通),由于需要经过的中间的路由器不一定有相关的路由配置(出于安全考虑,公有云环境下,宿主机之间的网关,肯定不会允许用户进行干预和设置),部分节点就无法找到容器IP的“下一条”网关了,host-gw就无法工作了。

Calico项目提供的网络解决方案,与Flannel的host-gw模式几乎一样,也会在宿主机上添加一个路由规则:

<目的容器IP地址段> via <网关的IP地址> dev eth0

其中,网关的IP地址,正是目的容器所在宿主机的IP地址,而正如前面所述,这个三层网络方案得以正常工作的核心,是为每个容器的IP地址,找到它所对应的,“下一跳”的网关。区别是如何维护路由信息:

Host-gw : Flannel通过Etcd和宿主机上的flanneld来维护路由信息

Calico: 通过BGP(边界网关协议)来实现路由自治,所谓BGP,就是在大规模网络中实现节点路由信息共享的一种协议。

隧道技术(需要封装包和解包,因为需要伪装成宿主机的IP包,需要三层链通):Flannel UDP / VXLAN / Calico IPIP

三层网络(不需要封包和解封包,需要二层链通):Flannel host-gw / Calico 普通模式

Pod和Pod之外网络实体的通信。

Pod与非Pod网络的实体通信,需要经过节点上的iptables规则做源地址转换,

而此规则就是Flanneld依据命令行--ip-masq选项做的配置。

Kubelet、Container Runtime 和 CNI 插件交互

当在节点上调度 Pod 时,一启动 Pod 就会发生很多事情。这里我们仅关注与 Pod 配置网络有关的动态。一旦在节点上调度了 Pod,将配置网络并启动应用程序容器。

参考:容器式 cri 插件架构Container Runtime 与 CNI 插件的交互每个 network provider 都有一个 CNI 插件,container runtime 会调用该插件,在 Pod 启动时配置网络。使用容器化作为 container runtime,容器化 CRI 插件将调用 CNI 插件。每个 network provider 都在每个 Kubernetes 节点上安装了一个代理,以配置 Pod 网络。安装 network provider agent 后,它会随 CNI 一起配置或者在节点上创建,CRI 插件会使用它来确定要调用哪个 CNI 插件。CNI 配置文件的位置是可配置的,默认值为 /etc/cni/net.d/<config-file>。集群管理员需要在每个节点上交付 CNI 插件。CNI 插件的位置也是可配置的,默认值为 /opt/cni/bin。如果使用 containerd 作为 container runtime,则可以在 containerd config 部分下 [plugins."io.containerd.grpc.v1.cri".cni] 指定 CNI 配置和 CNI 插件的路径。本文中我们将 Flannel 作为 network provider,这里简单介绍一下 Flannel 的设置。Flanneld 是 Flannel 守护程序,通常 install-cni 作为带有初始化容器的守护程序安装在 Kubernetes 集群上。install-cni 容器创建 CNI 配置文件在每个节点上 /etc/cni/net.d/10-flannel.conflist。Flanneld 创建一个 vxlan 设备,从 apiserver 获取网络元数据,并监控 Pod 上的更新。创建 Pod 时,它将在整个集群中为所有 Pod 分配路由,这些路由允许 Pod 通过 IP 地址相互连接。Containerd CRI 插件和 CNI 插件之间的交互可以如下所示:

如上所述,kubelet 调用 Containered CRI 插件创建容器,再调用 CNI 插件为容器配置网络。Network provider CNI 插件调用其他基本 CNI 插件来配置网络。CNI 插件之间的交互如下所述。

CNI 插件之间的交互有多种 CNI 插件可帮助配置主机上容器之间的网络,本文主要讨论以下 3 个插件。

Flannel CNI 插件当使用 Flannel 作为network provider时,Containered CRI 插件使用 CNI 配置文件,调用 Flannel CNI 插件:/etc/cni/net.d/10-flannel.conflist。

pod初始化网络过程

图

创建了一个Pod后,CRI和CNI协同创建Pod所属容器,并为它们初始化网络协议栈的全过程如下:

(1)当用户在Kubernetes的Master里创建了一个Pod后,Kubelet观察到新Pod的创建,首先调用CRI(后面的runtime实现,比如dockershim、containerd等)创建Pod内的若干个容器。

(2)在这些容器里,第一个被创建的pause容器 具体逻辑是一启动就把自己永远阻塞在那里。

每个Pod内的第一个系统容器pause的作用就是占用一个Linux的network namespace。

(3)Pod内其他用户容器通过加入这个network namespace的方式共享同一个network namespace。

用户容器和pause容器之间的关系有点类似于寄居蟹和海螺。因此,Container runtime创建Pod内的用户容器时,调用的都是同一个命令:docker run--net=none。意思是只创建一个network namespace,不初始化网络协议栈。如果这个时候通过nsenter方式进入容器,会看到里面只有一个本地回环设备lo。

(4)容器的eth0是怎么创建出来的呢?答案是CNI。

CNI主要负责容器的网络设备初始化工作。Kubelet目前支持两个网络驱动,分别是Kubenet和CNI。Kubenet是一个历史产物,即将废弃,CNI有多个实现,官方自带的插件就有p2p、bridge等,这些插件负责初始化pause容器的网络设备,也就是给pause容器内的eth0分配IP等,到时候,Pod内其他容器就使用这个IP与其他容器或节点进行通信。Kubernetes主机内容器的默认组网方案是bridge。

flannel、Calico这些第三方插件解决容器之间的跨机通信问题,典型的跨机通信解决方案有bridge和overlay等。

Kubernetes网络架构综述

谈到Kubernetes的网络模型,就不能不提它著名的“单Pod单IP”模型,即每个Pod都有一个独立的IP,Pod内所有容器共享network namespace(同一个网络协议栈和IP)。 “单Pod单IP”网络模型为我们勾勒了一个Kubernetes扁平网络的蓝图,在这个网络世界里:容器是一等公民,容器之间直接通信,不需要额外的NAT,因此不存在源地址被伪装的情况;Node与容器网络直连,同样不需要额外的NAT。扁平化网络的优点在于:没有NAT带来的性能损耗,而且可追溯源地址,为后面的网络策略做铺垫,降低网络排错的难度等。 总体而言,集群内访问Pod,会经过Service;集群外访问Pod,经过的是Ingress。Service和Ingress是Kubernetes专门为服务发现而抽象出来的相关概念,后面会做详细讨论。 与CRI之于Kubernetes的runtime类似,Kubernetes使用CNI作为Pod网络配置的标准接口。需要注意的是,CNI并不支持Docker网络,也就是说,docker0网桥会被大部分CNI插件“视而不见”。 当然也有例外,Weave就是一个会处理docker0的CNI插件,具体分析请看后面章节的内容。

网络CNI

what

CNI是Kubernetes与底层网络插件之间的一个抽象层,为Kubernetes屏蔽了底层网络实现的复杂度,同时解耦了Kubernetes的具体网络插件实现。

CNI主要有两类接口:

分别是在创建容器时调用的配置网络接口:

和删除容器时调用的清理网络接口: 不论是配置网络接口还是清理网络接口,

都有两个入参,分别是网络配置和runtime配置。网络配置很好理解,runtime配置则主要是容器运行时传入的网络namespace信息。

Kubelet和CNI给出了两个默认的文件系统路径

/etc/cni/net.d用来存储CNI配置文件

/opt/cni/bin目录用来存放CNI插件的二进制文件

图

Flannel

what

flannel 是一种配置第三层网络结构的简单易用方式,该层网络专门针对 Kubernetes 设计。

flannel 在每个主机上以称为 flanneld 的单个微小二进制程序运行代理,

并负责从更大的预配置地址空间中对每个主机分配租用子网。

Flannel 直接使用 Kubernetes API 或 etcd 存储网络配置。配置包括所分配的子网及所有的辅助数据,例如主机的公共 IP 等。

flannel 支持使用多种后端机制转发数据包,例如 VXLAN、各种云集成机制等。

原文链接: https://www.infoq.cn/article/ntg12fh31hq2vkxkt48i

Flannel是CoreOS公司为Kubernetes集群设计的一个Overlay网络方案,通过实现以下两种功能,使各Node上的容器之间能够实现网络互通。

(1)为每个Node上的docker0网桥配置一个互不冲突的IP地址池。

(2)为各Node的docker0虚拟网络建立一个覆盖网络(Overlay Network),通过这个覆盖网络,将数据包原封不动地传递到目标容器中。

Flannel在每台Node上创建了一个名为flannel0的网桥,这个网桥的一端连接docker0网桥,另一端连接flanneld服务进程。

Flannel使用Kubernetes API或etcd存储网络配置数据、子网分配和其他辅助信息。对于跨主机容器之间网络数据包的转发,Flannel支持以下几种模式。

◎VxLAN:使用Linux Kernel的VxLAN功能完成VxLAN的创建和管理。

◎UDP:使用UDP完成封包和解包的操作。

◎host-gw:将主机当作网关使用,要求所有主机都在同一个局域网内,保证二层网络联通。

why

1.使集群中的不同Node主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

2.建立一个覆盖网络(overlay network),通过这个覆盖网络,将数据包原封不动的传递到目标容器。

覆盖网络是建立在另一个网络之上并由其基础设施支持的虚拟网络。

覆盖网络通过将一个分组封装在另一个分组内来将网络服务与底层基础设施分离。

在将封装的数据包转发到端点后,将其解封装。

3.创建一个新的虚拟网卡flannel0接收docker网桥的数据,通过维护路由表,对接收到的数据进行封包和转发(vxlan)。

4.etcd保证了所有node上flanned所看到的配置是一致的。同时每个node上的flanned监听etcd上的数据变化,实时感知集群中node的变化。

how

跨主通信基本原理

1

各组件功能

1.Cni0:网桥设备,每创建一个pod都会创建一对 veth pair。其中一端是pod中的eth0,另一端是Cni0网桥中的端口(网卡)。Pod中从网卡eth0发出的流量都会发送到Cni0网桥设备的端口(网卡)上。Cni0 设备获得的ip地址是该节点分配到的网段的第一个地址。

2.Flannel.1: overlay网络的设备,用来进行 vxlan 报文的处理(封包和解包)。不同node之间的pod数据流量都从overlay设备以隧道的形式发送到对端。

3.Flanneld:flannel在每个主机中运行flanneld作为agent,它会为所在主机从集群的网络地址空间中,获取一个小的网段subnet,本主机内所有容器的IP地址都将从中分配。同时Flanneld监听K8s集群数据库,为flannel.1设备提供封装数据时必要的mac,ip等网络数据信息。

calico

概念

Calico 创建和管理一个扁平的三层网络(不需要overlay),每个容器会分配一个可路由的ip。

由于通信时不需要解包和封包,网络性能损耗小,易于排查,且易于水平扩展。

Calico架构

图

tu

Etcd:负责存储网络信息

BGP client:负责将Felix配置的路由信息分发到其他节点

Felix:Calico Agent,每个节点都需要运行,主要负责配置路由、配置ACLs、报告状态

BGP Route Reflector:大规模部署时需要用到,作为BGP client的中心连接点,可以避免每个节点互联

组件

图

calico包括如下重要组件:Felix,etcd,BGP Client,BGP Route Reflector。下面分别说明一下这些组件。

Felix:主要负责路由配置以及ACLS规则的配置以及下发,它存在在每个node节点上。

etcd:分布式键值存储,主要负责网络元数据一致性,确保Calico网络状态的准确性,可以与kubernetes共用;

BGPClient(BIRD), 主要负责把 Felix写入 kernel的路由信息分发到当前 Calico网络,确保 workload间的通信的有效性;

BGPRoute Reflector(BIRD), 大规模部署时使用,摒弃所有节点互联的mesh模式,通过一个或者多个 BGPRoute Reflector 来完成集中式的路由分发;

原文链接:https://blog.csdn.net/virtualization_/article/details/108465355

跨主机通信

图

集群边界路由器Ingress的管理

集群DNS域名服务管理

网络策略

Kubernetes底层网络是“全连通”的,即在同一集群内运行的所有Pod都可以自由通信。但是也支持用户根据实际需求以不同方式限制集群内Pod的连接。 例如,我们需要实现图3-22中的需求,即只允许访问default namespace的Label是app=web的Pod,default namespace的其他Pod都不允许外部访问。这个隔离需求在多租户的场景下十分普遍。Kubernetes的解决方案是Network Policy,即网络策略。

Kubernetes网络策略的知识点。

Egress表示出站流量,即Pod作为客户端访问外部服务,Pod地址作为源地址。策略可以定义目的地址和目的端口,可以根据ports和to定义规则。ports字段用来指定目的端口和协议。to(目的地址)分为IP地址段、Pod selector和Kubernetes namespace selector;

Ingress表示入站流量,Pod地址和服务作为服务端(目的地址),提供外部访问。与Egress类似,策略可以定义源地址和端口,可以根据ports和from定义规则。ports字段同样用来指定目的端口和协议。from(源地址)分为IP地址段、Pod selector和Kubernetes namespace selector;

podSelector用于指定网络策略在哪些Pod上生效,用户可以配置单个Pod或者一组Pod。可以定义单方向。空podSelector选择命名空间中的Pod。podSelector定义Network Policy的限制范围,就是规则应用到哪个Pod上。如上所示,podSelector:{}留空就是定义对Kubernetes当前namespace下的所有Pod生效。没有定义白名单的话,默认就是Deny ALL(拒绝所有);

policyTypes:指定策略类型,包括Ingress和Egress,不指定默认就是Ingress。默认情况下,一个policyTypes的值一定会包含Ingress。 说到匹配规则,namespaceSelector和podSelector是彼此独立的两个单独的匹配规则。你可以使用ipBlock字段允许来自或者到达特定IP地址段范围的Ingress或Egress流量。 最后,介绍Kubernetes网络策略与一些安全组(例如Neutron的安全组)的区别。一般来说,安全组的规则记录在上层网关,而不是每一个节点上。而Kubernetes网络是应用到每个节点上的,实现Network Policy的agent需要在每个节点上都List/Watch Kubernetes的Network Policy、namespace、Pod等资源对象,因此在实现上可能会有较大的性能影响。Network Policy agent一般通过Kubernetes DaemonSet实现每个节点上都有一个部署。

集群网络安全

集群的安全性保证

(1)保证容器与容器之间、容器与主机之间隔离,限制容器对其他容器和主机的消极影响。

(2)保证组件、用户及容器应用程序都是最小权限,限制它们的权限范围。

(3)保证集群的敏感数据的传输和存储安全。

安全机制

其中包括细粒度控制Pod 安全上下文(Pod Security Context)、

API Server 的认证、授权、审计和准入控制、数据的加密机制等。数据传输和存储的安全。

数据加密传输

Kubernetes 及其支持组件都应使用基于SSL/TLS 的HTTPS 协议来确保传输的安全性,

特别是客户与API Server、API Server 与etcd、API Server 与kubelet、etcd 成员之间这种跨节点的数据通信。

如果使用HTTPS 协议,那么在组建Kubernetes 集群时,必不可少地会涉及各个组件的数字证书的制作或签发,以及证书的参数配置。

ssl握手

图

API Server 支持在远端的etcd 上针对不同资源对象进行加密。参数“--encryption-provider-config” 用于配置不同资源对象在etcd 加密数据。加密配置示例代码如下:

集群的安全通信

图

在Kubernetes 体系中,有两套分别是etcd CA 和Kubernetes CA 颁发的证书。

etcd CA

其中etcd 客户端证书(简称为EC)、etcd 服务端证书(简称为ES)和etcd 对等证书(简称为P)都是由etcd CA 颁发和验证的,

分别用于API Server 和etcd 之间、etcd成员之间的加密通信。

在API Server 和etcd 所有实例处都应有一份etcd CA,也就是etcd 根证书,用于验证对方证书的有效性。

至于API Server 和etcd 之间的通信,都是由API Server 发起的,因此,API Server 处配置了etcd 客户端证书,etcd 处配置了etcd 服务端证书。

Kubernetes CA

用于kubelet 与API Server 之间双向主动通信。

客户端证书(即API Server 客户端证书,简称为AC)

kubelet 客户端证书(简称为KC)

服务端证书(即API Server 服务端证书,简称为AS)

kubelet 服务端证书(简称为KS)

当kubelet 主动连接API Server 时,API Server 作为服务端,应使用服务端证书AS,kubelet 作为客户端,应使用客户端证书AC;

当API Server 主动连接kubelet 时,kubelet作为服务端,应使用服务端证书KS,API Servr 作为客户端,应使用客户端证书KC。

同样,为了验证双方证书的有效性,在所有kubelet 和API Server 实例处都有一份Kubernetes CA,也就是Kubernetes 的根证书。

为什么这里至少需要两套CA(即两个根证书)来颁发证书呢

这是为了防止kubelet直接与etcd 通信,而绕过API Server 内置的所有授权机制

如果使用同一套CA,那么kubelet客户端证书能直接在etcd 服务端验证过

这里分别针对API Server 连接etcd、etcd 成员连接etcd 成员、kubelet 连接API Server和API Server 连接kubelet 这四个连接请求,

下面来看一下API Server、etcd、kubelet 三者与证书相关的配置参数。

1.API Server 连接etcd

即API Server 为客户端,etcd 为服务端。API Server 相关的配置参数如下:

2.etcd 成员连接etcd 成员 即etcd 既作为客户端又作为服务端。

因此在生成Peer 证书时,应写明此证书需有Client Auth 和Server Auth 两种用途

3.kubelet 连接API Server

kubelet 使用Kubeconfig 内的信息与API Server 建立连接,而Kubeconfig 中包含了关于证书的配置信息。事实上集群中的其他组件(例如Scheduler 和Controller Manager)也都是通过这种方式和API Server 建立连接的。

4.API Server 连接kubelet 即API Server 作为客户端,kubelet 作为服务端

数据加密存储,

相关资料

【掌阅】Kubernetes 网络权威指南

图解 Kubernetes Pod 如何获取 IP 地址

https://xie.infoq.cn/article/9179d85921467d5deca05b35b

https://www.infoq.cn/article/tiZgVs6BRkiCtBsVl0Ir

https://www.infoq.cn/article/6mdfWWGHzAdihiq9lDST

详解 Kubernetes 容器网络技能

玩转Kubernetes网络

https://www.bookstack.cn/read/sdn-handbook/container-index.md

网络基础

IPVS【掌阅】Kubernetes 网络权威指南

既然Kube-proxy已经有了iptables模式,为什么Kubernetes还选择IPVS呢?随着Kubernetes集群规模的增长,其资源的可扩展性变得越来越重要,特别是对那些运行大型工作负载的企业,其服务的可扩展性尤其重要。要知道,iptables难以扩展到支持成千上万的服务,它纯粹是为防火墙而设计的,并且底层路由表的实现是链表,对路由规则的增删改查操作都涉及遍历一次链表。 尽管Kubernetes在1.6版本中已经支持5000个节点,但使用iptables模式的Kube-proxy实际上是将集群扩展到5000个节点的最大瓶颈。一个例子是,如果我们有1000个服务并且每个服务有10个后端Pod,将在每个工作节点上至少产生10000×N(N≥4)个iptable记录,这可能使内核非常繁忙地处理每次iptables规则的刷新。 另外,使用IPVS做集群内服务的负载均衡可以解决iptables带来的性能问题。IPVS专门用于负载均衡,并使用更高效的数据结构(散列表),允许几乎无限的规模扩张。 1.IPVS的工作原理 IPVS是Linux内核实现的四层负载均衡,是LVS负载均衡模块的实现。上文也提到,IPVS基于netfilter的散列表,相对于同样基于netfilter框架的iptables有更好的性能表现和可扩展性,具体见下文的实测对比数据。 IPVS支持TCP、UDP、SCTP、IPv4、IPv6等协议,也支持多种负载均衡策略,例如rr、wrr、lc、wlc、sh、dh、lblc等。IPVS通过persistent connection调度算法原生支持会话保持功能。

网络地址转换(NAT,Network Address Translation)

是一种在IP数据包通过路由器或防火墙时重写来源IP地址或目的IP地址的技术。这种技术被普遍使用在有多台主机通过一个公有IP地址访问外部网络的私有网络中,NAT也可以被称作IP伪装(IP Masquerading),可以分为目的地址转换(DNAT)和源地址转换(SNAT)两类。

Linux中的NAT功能一般通过iptables实现。

iptables是基于Linux内核的功能强大的防火墙。

iptables/netfilter在2001年加入到2.4内核中,netfilter作为iptables内核底层的实现框架而存在, netfilter提供了一整套对hook函数管理的机制,可以在数据包流经的5处关键地方(Hook点),分别是PREROUTING(路由前)、INPUT(数据包入口)、OUTPUT(数据包出口)、FORWARD(数据包转发)、POSTROUTING(路由后),写入一定的规则对经过的数据包进行处理,规则一般的定义为“如果数据包头符合这样的条件,就这样处理数据包”。

iptables/netfilter是按照规则来工作的,这些规则分别指定了源地址、目的地址、传输协议(如TCP、UDP、CMP)和服务类型(如HTP、FP和SMTP)等。数据包与规则匹配时,iptables 就根据规则定义的方法处理这些数据包,比如放行、拒绝和丢弃等。配置防火墙的主要工作就是添加、修改和删除这些规则。 在每个关键点上,有很多已经按照优先级预先注册了的回调函数进行埋伏,设置的这些规则,就形成了一条链。INPUT规则链匹配目的地址是本机IP地址的数据报文,OUTPUT规则链匹配由本地进程发出的数据报文,FORWARD规则链匹配流经本机的数据报文,PREROUTING 规则链用来实现目的地址转换 DNAT,POSTROUTING 规则链可以用来实现源地址转换 SNAT。它们的工作流程如图2-11所示。 图2-11 iptables/netfilter的工作流程 防火墙为了达到“防火”的目的,就需要在内核中设置关卡,所有进出的报文都要通过这些关卡。经过检查后,符合放行条件的才能放行,符合阻拦条件的则需要被阻止。而这些关卡就是所谓的规则链。 每个“链”上都放置了一串规则,但是这些规则有些很相似,例如 A 类规则都是对IP地址或者端囗的过滤,B类规则是修改报文。此时能把实现相同功能的规则放在一起组成“表”。如此一来,不同功能的规则,可以放置在不同的表中进行管理。 如图2-12所示,iptables主要包含了FILTER、NAT和MANGLE三张常用表,分别负责数据包的过滤、网络地址转换及数据包内容的修改。

network namespace

它在Linux内核2.6版本引入,

作用是隔离Linux系统的设备,以及IP地址、端口、路由表、防火墙规则等网络资源。

因此,每个网络namespace里都有自己的网络设备(如IP地址、路由表、端口范围、/proc/net目录等)

从网络的角度看,network namespace使得容器非常有用,

一个直观的例子就是:由于每个容器都有自己的(虚拟)网络设备,并且容器里的进程可以放心地绑定在端口上而不必担心冲突,这就使得在一个主机上同时运行多个监听80端口的Web服务器变为可能,

每个新的Network Namespace都默认有一个本地回环LO接口,此外,所有的其他网络设备,包括物理/虚拟网络接口、网桥等,只能属于一个Network Namespace,每个Socket也只能属于一个Network Namespace。当新的network namespace被创建时,LO接口默认是关闭的,需要自己手动启动。 创建 Network Namespace 也非常简单,使用 ip netns add 后面跟着要创建的Namespace 名称,如果相同名字的 Namespace 已经存在,会产生“Cannot create namespace”的错误。 ip netns命令创建的Network Namespace会出现在/var/run/netns/目录下,如果需要管理其他不是ip netns创建的Network Namespace,只要在这个目录下创建一个指向对应 Network Namespace 文件的链接就可以。

有了不同的Network Namespace后,也就有了网络的隔离,但如果它们之间没有办法通信,也没有实际用处。要把两个网络连接起来,Linux提供了VETH pair。如前所述,可以把VETH pair当作双向的管道,从一端发送的网络数据,可以直接被另外一端接收到,也可以想象成两个 Namespace 直接通过一个特殊的虚拟网卡连接起来,可以直接通信。 可以使用ip link add type veth 创建一对VETH pair,系统自动生成VETH0和VETH1两个网络接口,如果需要指定它们的名字,则可以使用ip link add vethfoo type veth peer name vethbar,此时创建出来的两个名字就是vethfoo和vethbar。需要记住的是VETH pair无法单独存在,删除其中一个,另一个也会自动消失。 然后,可以把这对VETH pair分别放到创建的两个Namespace里,可以使用ip link set DEV netns NAME来实现。 如图2-8所示,创建两个Network Namespace,分别命名为net0与net1,同时创建了 VETH pair 对 veth0与 veth1,将它们分别加入 net0与 net1,将两个 Network Namespace连接起来。 图2-8 使用VETH pair连接两个Network Namespace 虽然 VETH pair 可以实现两个 Network Namespace 之间的通信,但是当多个Namespace需要通信的时候,就无能为力了。涉及多个网络设备之间的通信,首先想到的是交换机和路由器。因为这里要考虑的只是同一个网络,所以只用到交换机的功能,也就是前面所述的网

出自 :Linux开源网络全栈详解

Linux bridge

就是Linux系统中的网桥,但是Linux bridge的行为更像是一台虚拟的网络交换机,任意的真实物理设备(例如eth0)和虚拟设备(例如,前面讲到的veth pair和后面即将介绍的tap设备)都可以连接到Linux bridge上。需要注意的是,Linux bridge不能跨机连接网络设备。 Linux bridge与Linux上其他网络设备的区别在于,普通的网络设备只有两端,从一端进来的数据会从另一端出去。例如,物理网卡从外面网络中收到的数据会转发给内核协议栈,而从协议栈过来的数据会转发到外面的物理网络中。Linux bridge则有多个端口,数据可以从任何端口进来,进来之后从哪个口出去取决于目的MAC地址,原理和物理交换机差不多。

iptables的底层实现是netfilter

作为一个通用的、抽象的框架,提供一整套hook函数的管理机制,使得数据包过滤、包处理(设置标志位、修改TTL等)、地址伪装、网络地址转换、透明代理、访问控制、基于协议类型的连接跟踪,甚至带宽限速等功能成为可能。

netfilter的架构就是在整个网络流程的若干位置放置一些钩子,并在每个钩子上挂载一些处理函数进行处理。

IP层的5个钩子点的位置,对应iptables就是5条内置链,分别是PREROUTING、POSTROUTING、INPUT、OUTPUT和FORWARD。

当网卡上收到一个包送达协议栈时,最先经过的netfilter钩子是PREROUTING,如果确实有用户埋了这个钩子函数,那么内核将在这里对数据包进行目的地址转换(DNAT)。不管在PREROUTING有没有做过DNAT,内核都会通过查本地路由表决定这个数据包是发送给本地进程还是发送给其他机器。如果是发送给其他机器(或其他network namespace),就相当于把本地当作路由器,就会经过netfilter的FORWARD钩子,用户可以在此处设置包过滤钩子函数,例如iptables的reject函数。

所有马上要发到协议栈外的包都会经过POSTROUTING钩子,用户可以在这里埋下源地址转换(SNAT)或源地址伪装(Masquerade,简称Masq)的钩子函数。如果经过上面的路由决策,内核决定把包发给本地进程,就会经过INPUT钩子。本地进程收到数据包后,回程报文会先经过OUTPUT钩子,然后经过一次路由决策(例如,决定从机器的哪块网卡出去,下一跳地址是多少等),最后出协议栈的网络包同样会经过POSTROUTING钩子。

netfilter是Linux内核网络模块的一个经典框架,毫不夸张地说,整个Linux系统的网络安全大厦都构建在netfilter之上,构建在netfilter钩子之上的网络安全策略和连接跟踪的用户态程序就有ebtables、arptables、(IPv6版本的)ip6tables、iptables、iptables-nftables(iptables的改进版本)、conntrack(连接跟踪)等。Kubernetes网络之间用到的工具就有ebtables、iptables/ip6tables和conntrack,其中iptables是核心。

我们常说的iptables 5X5,、即5张表(table)和5条链(chain)。

5条链即iptables的5条内置链,对应上文介绍的netfilter的5个钩子。

这5条链分别是:

·INPUT链:一般用于处理输入本地进程的数据包;

·OUTPUT链:一般用于处理本地进程的输出数据包;

·FORWARD链:一般用于处理转发到其他机器/network namespace的数据包;

·PREROUTING链:可以在此处进行DNAT;

·POSTROUTING链:可以在此处进行SNAT。

除了系统预定义的5条iptables链,用户还可以在表中定义自己的链,我们将通过例子详细说明。 5张表如下所示。

·filter表:用于控制到达某条链上的数据包是继续放行、直接丢弃(drop)或拒绝(reject);

·nat表:用于修改数据包的源和目的地址;

·mangle表:用于修改数据包的IP头信息;

·raw表:iptables是有状态的,即iptables对数据包有连接追踪(connection tracking)机制,而raw是用来去除这种追踪机制的;

·security表:最不常用的表(通常,我们说iptables只有4张表,security表是新加入的特性),用于在数据包上应用SELinux。 这5张表的优先级从高到低是:raw、mangle、nat、filter、security。需要注意的是,iptables不支持用户自定义表。 不是每个链上都能挂表,iptables表与链的对应关系如表1-1所示。 表1-1 iptables表与链的对应关系 所以,如果我们扩充图1-13,给它加上iptables的5张表,那么一个网络包经过iptables的处理路径如图1-16所示。 图1-16 一个网络包经过iptables的处理路径 可能有读者会问,iptables的链(chain)的概念还比较好理解,就是对应netfilter的5处钩子,而iptables的表(table)的具体作用是什么呢?而且上文说的“不是每个链上都能挂表”这句话的表述似乎也很奇怪

iptables

在Docker和Kubernetes网络中应用甚广。例如,Docker容器和宿主机的端口映射、Kubernetes Service的默认模式、CNI的portmap插件、Kubernetes网络策略等都是通过iptables实现的

iptables的表是来分类管理iptables规则(rule)的,系统所有的iptables规则都被划分到不同的表集合中。上文也提到了,

filter表中会有过滤数据包的规则,nat表中会有做地址转换的规则。因此,iptables的规则就是挂在netfilter钩子上的函数,用来修改数据包的内容或过滤数据包,iptables的表就是所有规则的5个逻辑集合

iptables的规则是用户真正要书写的规则。一般情况下,一条iptables规则包含两部分信息:匹配条件和动作。匹配条件很好理解,即匹配数据包被这条iptables规则“捕获”的条件,例如协议类型、源IP、目的IP、源端口、目的端口、连接状态等。每条iptables规则允许多个匹配条件任意组合,从而实现多条件的匹配,多条件之间是逻辑与(&&)关系。

数据包匹配后该怎么办,常见的动作有下面几个:

·DROP:直接将数据包丢弃,不再进行后续的处理。应用场景是不让某个数据源意识到你的系统的存在,可以用来模拟宕机;

·REJECT:给客户端返回一个connection refused或destination unreachable报文。应用场景是不让某个数据源访问你的系统,善意地告诉他:我这里没有你要的服务内容;

·QUEUE:将数据包放入用户空间的队列,供用户空间的程序处理;

·RETURN:跳出当前链,该链里后续的规则不再执行;

·ACCEPT:同意数据包通过,继续执行后续的规则;

·JUMP:跳转到其他用户自定义的链继续执行。

值得一提的是,用户自定义链中的规则和系统预定义的5条链里的规则没有区别。由于自定义的链没有与netfilter里的钩子进行绑定,所以它不会自动触发,只能从其他链的规则中跳转过来,这也是JUMP动作存在的意义。 在初步认识了iptables的表、链和规则三个最重要的概念后,

接下来将以iptables在Kubernetes网络中的使用为背景,简单介绍iptables的常见用法

1.查看所有iptables规则 Kubernetes一个节点上的iptables规则输出如下。

严格地说,输出是iptables的filter表的所有规则。使用iptables命令,必须指定针对哪个表进行操作,默认是filter表。因此,如果想输出系统中nat表的所有iptables规则,可以使用如下命令: 使用-n选项将以数字形式列出信息,即将域名解析成IP地址。想输出更详细的信息,例如,经过某条rule处理的数据包字节、进出网口等信息,可以使用-v选项。 从上面的输出结果可以看出,filter表上挂了5条链,分别是INPUT、FORWARD和OUTPUT这三条系统内置链,以及KUBE-FIREWALL和KUBE-FORWARD这两条用户自定义链。iptables的内置链都有默认规则,例如在我们的例子中,INPUT、FORWARD和OUTPUT的默认规则是ACCEPT,即全部放行。用户自己定义的链后面都有一个引用计数,在我们的例子中KUBE-FIREWALL和KUBE-FORWARD都有一个引用,它们分别在INPUT和FORWARD中被引用

iptables的每条链下面的规则处理顺序是从上到下逐条遍历的,除非中途碰到DROP,REJECT,RETURN这些内置动作。如果iptables规则前面是自定义链,则意味着这条规则的动作是JUMP,即跳到这条自定义链遍历其下的所有规则,然后跳回来遍历原来那条链后面的规则。以上过程如图1-17所示。

图1-17 iptables遍历规则 在我们的例子中,iptables规则的遍历顺序应该是rule 1,1→rule 1,2→rule 2,1→rule 2,2→rule 2,3→rule 1,3。

3.配置防火墙规则策略 防火墙策略一般分为通和不通两种。如果默认策略是“全通”,例如上文的policy ACCEPT,就要定义一些策略来封堵;反之,如果默认策略是“全不通”,例如上文的policy DROP,就要定义一些策略来解封。如果是做访问控制列表(ACL),即俗称的白名单,则用解封策略更常用。

我们将用几个实际的例子来说明。

1)配置允许SSH连接

简单分析这条命令,-A的意思是以追加(Append)的方式增加这条规则。-A INPUT表示这条规则挂在INPUT链上。-s 10.20.30.40/24表示允许源(source)地址是10.20.30.40/24这个网段的连接。-p tcp表示允许TCP(protocol)包通过。--dport 22的意思是允许访问的目的端口(destination port)为22,即SSH端口。-j ACCEPT表示接受这样的连接。综上所述,这条iptables规则的意思是允许源地址是10.20.30.40/24这个网段的包发到本地TCP 22端口。除了按追加的方式添加规则,还可以使用iptables-I[chain][number]将规则插入(Insert)链的指定位置。如果不指定number,则插到链的第一条处。

2)阻止来自某个IP/网段的所有连接

如果要阻止10.10.10.10上所有的包,则可以使用以下命令:

也可以使用-j REJECT,这样就会发一个连接拒绝的回程报文,客户端收到后立刻结束。不像-j DROP那样不返回任何响应,客户端只能一直等待直到请求超时。如果要屏蔽一个网段,例如10.10.10.0/24,则可以使用-s 10.10.10.0/24或10.10.10.0/255.255.255.0。如果要“闭关锁国”,即屏蔽所有的外来包,则可以使用-s 0.0.0.0/0。

3)封锁端口

要阻止从本地1234端口建立对外连接,可以使用以下命令:

注意,我们要在OUTPUT链上挂规则是因为我们的需求是屏蔽本地进程对外的连接。如果我们要阻止外部连接访问本地1234端口,就需要在INPUT链上挂规则,命令如下: 感到困惑的读者可以复习关于netfilter的内容。

4)端口转发 有时,我们要把服务器的某个端口流量转发给另一个端口。

例如,我们对外声称Web服务在80端口上运行,但由于种种原因80端口被人占了,实际的Web服务监听在8080端口上。为了让外部客户端能无感知地依旧访问80端口,可以使用以下命令实现端口转发:

以上命令中-p tcp--dport 80-j REDIRECT--to-port 8080的意思是发到TCP 80端口的流量转发(REDIRECT)给8080端口,iptables并不会修改任何IP地址或者协议。需要注意的是,我们修改了目的端口,因此该规则应该发生在nat表上的PREROUTING链上。至于-i eth0则表示匹配eth0网卡上接收到的包。

5)禁用PING 大部分的公有云默认都是屏蔽ICMP的,即禁止ping报文。

以上命令的-p icmp-j DROP即表示匹配ICMP报文,然后丢弃。

6)删除规则 最暴力地清除当前所有的规则命令(请慎用): 要清空特定的表可以使用-t参数进行指定,例如清除nat表所有的规则如下: 删除规则的最直接的需求是解封某条防火墙策略。因此,笔者建议使用iptables的-D参数: -D表示从链中删除一条或多条指定的规则,后面跟的就是要删除的规则。 当某条链上的规则被全部清除变成空链后,可以使用-X参数删除: 以上命令删除FOO这条用户自定义的空链,但需要注意的是系统内置链无法删除。 7)自定义链 说了这么多自定义链,具体该怎么创建它呢?请看以下命令: 如上所示,我们在filter表(因为未指定表,所以可以使用-t参数指定)创建了一条用户自定义的链BAR。

4.DNAT DNAT根据指定条件修改数据包的目标IP地址和目标端口。DNAT的原理和我们上文讨论的端口转发原理差不多,差别是端口转发不修改IP地址。使用iptables做目的地址转换的一个典型例子如下: -j DNAT表示目的地址转换,-d 1.2.3.4-p tcp--dport 80表示匹配的包条件是访问目的地址和端口为1.2.3.4:80的TCP包,--to-destination表示将该包的目的地址和端口修改成10.20.30.40:8080。同样,DNAT不修改协议。如果要匹配网卡,可以用-i eth0指定收到包的网卡(i是input的缩写)。需要注意的是,DNAT只发生在nat表的PREROUTING链,这也是我们要指定收到包的网卡而不是发出包的网卡的原因。 需要注意的是,当涉及转发的目的IP地址是外机时,需要确保启用ip forward功能,即把Linux当交换机用,命令如下: 5.SNAT/网络地址欺骗 神秘的网络地址欺骗其实是SNAT的一种。SNAT根据指定条件修改数据包的源IP地址,即DNAT的逆操作。与DNAT的限制类似,SNAT策略只能发生在nat表的POSTROUTING链。具体命令如下: -j SNAT表示源地址转换,-s 192.168.1.12表示匹配的包源地址是192.168.1.12,--to-source表示将该包的源地址修改成10.172.16.1。与DNAT类似,我们也可以匹配发包的网卡,例如-o eth0(o是output的缩写)。 至于网络地址伪装,其实就是一种特殊的源地址转换,报文从哪个网卡出就用该网卡上的IP地址替换该报文的源地址,具体用哪个IP地址由内核决定。下面这条规则的意思是:源地址是10.8.0.0/16的报文都做一次Masq。 与SNAT类似,如果要控制被替换的源地址,则可以指定匹配从哪块网卡发出报文。例如:-o eth0选项指定报文从eth0出去并使用eth0的IP地址做源地址伪装。 6.保存与恢复 上述方法对iptables规则做出的改变是临时的,重启机器后就会丢失。如果想永久保存这些更改,则需要运行以下命令: iptables-save在保存系统所有iptables规则的同时,也会在标准输出打印这些规则,如有需要可以重定向到一个文件,例如: 后续,我们可以使用iptables-restore命令还原iptables-save命令备份的iptables配置,原理就是逐条执行文件里的iptables规则,如下所示:

conntrack

所有由netfilter框架实现的连接跟踪模块称作conntrack(connection tracking)。在DNAT的过程中,conntrack使用状态机启动并跟踪连接状态。为什么需要记录连接的状态呢?因为iptables/IPVS做了DNAT后需要记住数据包的目的地址被改成了什么,并且在返回数据包时将目的地址改回来。除此之外,iptables还可以依靠conntrack的状态(cstate)决定数据包的命运。其中最主要的4个conntrack状态如下: (1)NEW:匹配连接的第一个包,这表示conntrack对该数据包的信息一无所知。通常发生在收到SYN数据包时。 (2)ESTABLISHED:匹配连接的响应包及后续的包,conntrack知道该数据包属于一个已建立的连接。通常发生在TCP握手完成之后。 (3)RELATED:RELATED状态有点复杂,当一个连接与另一个ESTABLISHED状态的连接有关时,这个连接就被认为是RELATED。这意味着,一个连接要想成为RELATED,必须先有一条已经是ESTABLISHED状态的连接存在。这个ESTABLISHED状态连接再产生一个主连接之外的新连接,这个新连接就是RELATED状态。 (4)INVALID:匹配那些无法识别或没有任何状态的数据包,conntrack不知道如何处理它。该状态在分析Kubernetes故障的过程中起着重要的作用。

VXLAN的报文就是MAC in UDP

,即在三层网络的基础上构建一个虚拟的二层网络。为什么这么说呢?VXLAN的封包格式显示原来的二层以太网帧(包含MAC头部、IP头部和传输层头部的报文),被放在VXLAN包头里进行封装,再套到标准的UDP头部(UDP头部、IP头部和MAC头部),用来在底层网络上传输报文。 可以看出,VXLAN报文比原始报文多出了50个字节,包括8个字节的VXLAN协议相关的部分,8个字节的UDP头部,20个字节的IP头部和14个字节的MAC头部。这降低了网络链路传输有效数据的比例,特别是对小包。 需要注意的是,UDP目的端口是接收方VTEP设备使用的端口,IANA(Internet Assigned Numbers Authority,互联网号码分配局)分配了4789作为VXLAN的目的UDP端口。 VXLAN的配置管理使用iproute2包,这个工具是和VXLAN一起合入内核的,我们常用的ip命令就是iproute2的客户端工具。VXLAN要求Linux内核版本在3.7以上,最好为3.9以上,所以在一些旧版本的Linux上无法使用基于VXLAN的封包技术。 1.7.3 VXLAN组网必要信息 总的来说,VXLAN报文的转发过程就是:原始报文经过VTEP,被Linux内核添加上VXLAN包头及外层的UDP头部,再发送出去,对端VTEP接收到VXLAN报文后拆除外层UDP头部,并根据VXLAN头部的VNI把原始报文发送到目的服务器。 以上过程看似并不复杂,但前提是通信双方已经知道所有通信信息。第一次通信之前有以下问题待解决: ·哪些VTEP需要加到一个相同的VNI组? ·发送方如何知道对方的MAC地址? ·如何知道目的服务器在哪个节点上? 第一个问题最好回答,VTEP通常由网络管理员进行配置。另外两个问题可以归结为同一个问题:VXLAN网络的通信双方如何感知彼此并选择正确的路径传输报文?要回答这两个问题,还得回到VXLAN协议报文上,看看一个完整的VXLAN报文需要哪些信息。 ·内层报文:通信双方的IP地址已经明确,需要VXLAN填充的是对方的MAC地址,VXLAN需要一个机制来实现ARP的功能; ·VXLAN头部:只需要知道VNI。它一般是直接配置在VTEP上的,即要么是提前规划的,要么是根据内部报文自动生成的; ·UDP头部:最重要的是源地址和目的地址的端口,源地址端口是由系统生成并管理的,目的端口一般固定为IANA分配的4789端口; ·IP头部:IP头部关心的是对端VTEP的IP地址,源地址可以用很简单的方式确定,目的地址是虚拟机所在地址宿主机VTEP的IP地址,需要由某种方式来确定; ·MAC头部:确定了VTEP的IP地址,MAC地址可以通过经典的ARP方式获取,毕竟VTEP在同一个三层网络内。 总结一下,一个VXLAN报文需要确定两个地址信息:内层报文(对应目的虚拟机/容器)的MAC地址和外层报文(对应目的虚拟机/容器所在宿主机上的VTEP)IP地址。如果VNI也是动态感知的,那么VXLAN一共需要知道三个信息:内部MAC、VTEP IP和VNI。 一般有两种方式获得以上VXLAN网络的必要信息:多播和控制中心。多播的概念是同一个VXLAN网络的VTEP加入同一个多播网络。如果需要知道以上信息,就在组内发送多播来查询。控制中心的概念是在某个集中式的地方保存所有虚拟机的上述信息,自动告知VTEP它需要的信息即可。

存储资源管理

Volume类型

(1)临时目录(随着Pod的销毁而销毁)

◎emptyDir

emptyDir 设计的初衷主要是给应用充当缓存空间,或者存储中间数据,用于快速恢复。

因为emptyDir 的空间位于系统根盘,被所有容器共享,所以在磁盘的使用率较高时会触发Pod 的eviction 操作,从而影响业务的稳定。

“卷” 最初是空的。当Pod 从节点上删除时,emptyDir 卷中的数据也会被永久删除。

但当Pod 的容器因为某些原因退出再重启时,emptyDir 卷内的数据并不会丢失。

默认情况下,emptyDir 卷存储在支持该节点所使用的存储介质上,可以是本地磁盘或网络存储。

emptyDir 也可以通过将 emptyDir.medium 字段设置为 “Memory” 来通知Kubernetes 为容器安装tmpfs,此时数据被存储在内存中,速度相对于本地存储和网络存储快很多。但是在节点重启的时候,内存数据会被清除;

使用tmpfs 的内存也会计入容器的使用内存总量中,受系统的CGroup限制。

(2)配置类(将配置以Volume的形式挂载到Pod内)

◎ConfigMap:将保存在ConfigMap资源对象中的配置文件信息挂载到容器内的某个目录下。

◎Secret:将保存在Secret资源对象中的密码密钥等信息挂载到容器内的某个文件中。

◎downwardAPI:将downward API的数据以环境变量或文件的形式注入容器中。

◎gitRepo:将某Git代码库挂载到容器内的某个目录下。

(3)本地存储类

◎hostPath:将宿主机的目录或文件挂载到容器内进行使用。

常见的半持久化存储主要是hostPath 卷。hostPath 卷能将主机节点文件系统上的文件或目录挂载到指定的Pod 中。对普通用户而言一般不需要这样的卷,但是对很多需要获取节点系统信息的Pod 而言,却是非常必要的。

hostPath 的用法举例如下:

某个Pod 需要获取节点上所有Pod 的log,可以通过hostPath 访问所有Pod 的stdout输出存储目录,例如/var/log/pods 路径。

某个Pod 需要统计系统相关的信息,可以通过hostPath 访问系统的/proc 目录。 使用hostPath 的时候,除设置必需的path 属性外,用户还可以有选择性地为 hostPath 卷指定类型,支持类型包含目录、字符设备、块设备等。

另外,使用hostPath 卷需要注意如下几点:

使用同一个目录的Pod 可能会由于调度到不同的节点,导致目录中的内容有所不同。

Kubernetes 在调度时无法顾及由 hostPath 使用的资源。

Pod 被删除后,如果没有特别处理,那么hostPath 上写的数据会遗留到节点上,占用磁盘空间。

◎local:Kubernetes从v1.9版本引入,将本地存储以PV的形式提供给容器使用,并能够实现存储空间的管理。

(4)共享存储类

◎PV(Persistent Volume):将共享存储定义为一种“持久存储卷”,可以被多个容器应用共享使用。

◎PVC(Persistent Volume Claim):用户对存储资源的一次“申请”,PVC申请的对象是PV,一旦申请成功,应用就能够像使用本地目录一样使用共享存储了。

共享存储主要用于多个应用都能够使用的存储资源

例如 NFS 存储、光纤存储、GlusterFS共享文件系统等

在Kubernetes系统中通过PV/StorageClass和PVC来完成定义,并通过volumeMount挂载到容器的目录或文件进行使用。

PV可以被看作可用的存储资源,PVC则是对存储资源的需求,PV和PVC的相互关系遵循如图2-25所示的生命周期管理。 图2-25

Kubernetes的共享存储供应模式包括静态模式(Static)和动态模式(Dynamic),资源供应的结果就是创建好的PV。

◎ 静态模式:集群管理员手工创建许多PV,在定义PV时需要设置后端存储的特性。

◎ 动态模式:集群管理员无须手工创建PV,而是通过对StorageClass的设置对后端存储进行描述,标记为某种“类型(Class)”。

此时要求PVC对存储的类型进行声明,系统将自动完成PV的创建及与PVC的绑定。PVC可以声明Class为"",说明该PVC禁止使用动态模式。 图2-26描述了在静态资源供应模式下通过PV和PVC完成绑定并供Pod使用的存储管理机制。 图2-26 例如,对于NFS共享存储,可以先创建一个PV对象,对NFS存储进行引用: 然后创建一个PVC对象,通过storageClassName和Label Selector选择之前创建的PV: 之后,Pod就能够将PVC“myclaim”挂载到容器的某个目录进行使用了。 图2-27描述了在动态资源供应模式下,通过StorageClass和PVC完成资源动态绑定(系统自动生成PV)并供Pod使用的存储管理机制。

Persistent Volume Claim和Persistent Volume的生命周期

类似于Pod和Node,Pod消费Node的资源,Persistent Volume Claim则是消费Persistent Volume的资源。

Persistent Volume和Persistent Volume Claim相互关联,有着完整的生命周期管理。

准备 系统管理员规划并创建一系列的Persistent Volume,Persistent Volume在创建成功后处于可用状态。

绑定 用户创建Persistent Volume Claim来声明存储请求,包括存储大小和访问模式。

Persistent Volume Claim创建成功后进入等待状态,当Kubernetes发现有新的Persistent Volume Claim创建的时候,就会根据条件查找Persistent Volume。当有Persistent Volume匹配的时候,就会将Persistent Volume Claim和Persistent Volume进行绑定,Persistent Volume和Persistent Volume Claim都进入绑定状态。 Kubernetes只会选择可用状态的Persistent Volume,并且采取最小满足策略,而当没有Persistent Volume满足需求的时候,Persistent Volume Claim将处于等待阶段。比如现在有两个Persistent Volume可用,一个Persistent Volume的容量是50Gi,一个Persistent Volume的容量是60Gi。那么请求40Gi的Persistent Volume Claim会被绑定到50Gi的Persistent Volume,而请求100Gi的Persistent Volume Claim则处于等待状态,直到有大于100Gi的Persistent Volume出现(Persistent Volume有可能被新建或者被回收)。

使用 创建Pod的时候使用Persistent Volume Claim,Kubernetes便会查询其绑定的Persistent Volume,去调用真正的存储实现,然后将数据卷挂载到Pod中。

释放 当用户删除Persistent Volume所绑定的Persistent Volume Claim时,Persistent Volume则进入释放状态。此时Persistent Volume中可能残留着之前Persistent Volume Claim使用的数据,所以Persistent Volume并不可用,需要对Persistent Volume进行回收操作。

回收 释放的Persistent Volume需要回收才能再次使用,回收的策略可以是人工处理,或者由Kubernetes自动进行清理,如清理失败,Persistent Volume会进入失败状态。

Persistent Volume的状态包括如下。

Available:Persistent Volume创建成功后进入可用状态,等待Persistent Volume Claim消费。

Bound:Persistent Volume被分配到Persistent Volume Claim进行绑定,Persistent Volume进入绑定状态。

Released:Persistent Volume绑定的Persistent Volume Claim被删除,Persistent Volume进入释放状态,等待回收处理。

Failed:Persistent Volume执行自动清理回收策略失败后,Persistent Volume会进入失败状态。

Persistent Volume Claim的状态包括如下几项。

Pending:Persistent Volume Claim创建成功后进入等待状态,等待绑定Persistent Volume。

Bound:分配Persistent Volume给Persistent Volume Claim进行绑定,Persistent Volume Claim进入绑定状态。

存储方案选择

(1)将存储放置于容器内部

优点:配置简单,便于容器实例的水平扩展;存储性能也与直接在物理机上启动应用相当,几乎没有磁盘I/O的额外损耗。

缺点:在容器被销毁或删除之后,容器内部的存储也会一并被销毁,数据持久化保存比较困难;同时,在业务逻辑上要求每个容器实例存储的文件相互没有关联。

Volume类型的选择。

◎ 使用emptyDir类型的Volume,可供一个Pod内的多个容器共享。

◎ 也可以不使用任何Volume类型,由容器引擎(如Docker)管理应用的文件存储。

适用场景:

适合无状态容器应用,在系统运行过程中产生的临时文件可以被保存在容器的存储空间中。

如有需要保存的日志记录,则可以使用Pod内的临时存储,供另一个Sidecar容器进行文件处理。

注意事项:

需要考虑存储空间的限制。

不论是Docker为容器设置的存储目录,还是在Pod内设置的临时目录,都会耗费宿主机的磁盘空间。这就要求应用系统对存储空间的使用进行限制,不应无限使用,以至于将宿主机磁盘空间耗尽。

(2)将存储挂载在外部宿主机上

优点:数据不会因为容器销毁而丢失,可永久保存;存储性能与直接在物理机上使用相当,没有磁盘I/O的额外损耗。

缺点:容器实例使用宿主机存储目录,多实例的应用在同一台宿主机上的目录配置变得复杂,要求各实例对存储的使用互不干扰;另外,如果历史数据在后续的业务处理过程中仍然需要使用,则容器应用将对Node宿主机形成绑定关系,不利于容器应用在故障恢复时选择其他可用的Node重建。

◎ 使用hostPath类型的Volume,将宿主机目录挂载到容器内。

◎ 使用local类型的PV。

适用场景:适合有状态(Stateful)类型的容器应用,以及对磁盘I/O性能要求非常高的应用,例如数据库类的应用,包括MySQL、MongoDB、Cassandra等;

同时,这类应用应该不能随意水平扩展;还需要通过其他机制实现存储的高可用保障,例如可以使用数据远程备份机制保存数据。

注意事项:同样需要考虑存储空间的限制,不应无限使用,以至于将宿主机磁盘空间耗尽,在必要时可以考虑数据的定时清理工作。

(3)使用外部共享存储

优点:配置简单,数据的持久化、备份都由共享存储提供了解决方案,也便于容器实例的水平扩展。

缺点:由于共享存储多是网络存储的,所以在进行文件读写时都要经过网络传输,存储性能比直接在物理机上使用差很多。 Volume类型选择:使用PV或StorageClass类型的Volume。

◎ 静态PV可以选择NFS、FC、iSCSI等Volume类型。

◎ 动态PV可以选择GlusterFS、Ceph等Volume类型。

适用场景:适合有状态类型的容器应用,以及对磁盘I/O性能要求不是很高的应用,例如小型数据库类的应用。这类应用如果有水平扩展的需求,则可以考虑使用Kubernetes 的StatefulSet来部署应用和存储。 注意事项:应该考虑存储设备的成本和性能指标。

Kubernetes的卷是通过Pod实现持久化的,数据卷一般可以贯穿Pod(而不是Pod中的容器)的整个生命周期,因此,存储卷的存在时间会比Pod中的任何容器都长,并且在容器重新启动时会保留数据。

当Pod被平台删除时,不同的数据卷实现可能会有所不同,数据或被保留或被移除,如果数据被保留的话,其他Pod可以重新把该卷的数据进行加载使用。

数据卷可以分为共享和非共享两种类型,

共享型的数据卷可以被不同节点上的多个Pod同时使用,因此能够很方便地支持容器在集群各节点之间的迁移。

Kubernetes可以支持多种类型的数据卷,Pod可以同时使用多种类型和任意数量的存储卷。

在Pod中通过指定下面的字段来使用数据卷。

· spec.volumes:通过此字段提供指定的数据卷。

· spec.containers.volumeMounts:通过此字段将数据卷挂接到容器中。

· emptyDir:空目录。在Pod分配到Node上时被创建,属于Node上的本地存储,生命周期和Pod一样,没有持久性,当Pod从Node上被移除时,emptyDir中的数据会被永久删除。

· hostPath:映射Node文件系统中的文件或目录到Pod中。

· local:允许用户通过标准PVC接口访问Node节点的本地存储。物理卷的定义中需要包含描述节点亲和性的信息,Kubernetes基于该信息将容器调度到正确的Node节点上。

· rbd:Ceph块存储。

· cinder:OpenStack块存储。

· nfs:用于将现有的网络文件系统挂载到Pod中。在Pod被移除时,网络文件系统数据卷被卸载,但是其中的内容并不会被删除。这意味着在网络文件系统数据卷中可以预先填充数据,并且可以在Pod之间共享。网络文件系统可以被同时挂载到多个Pod中,并能同时进行写入。但是使用的前提是:网络文件系统服务器必须已经被部署运行,并已经设置了共享目录。

· iscsi:允许将现有的iSCSI卷挂载到容器中。Pod被移除时,iSCSI卷被卸载,但是其中的内容将被保留。这意味着iSCSI卷可以预先填充数据,并且这些数据可以在Pod之间共享。

· persistentVolumeClaim:用于将PersistentVolume挂载到Pod中,使用此类型的数据卷时,用户并不知道数据卷的详细信息。

emptyDir和hostPath都是Node节点的本地存储方式,使用emptyDir时,可以在创建时定义emptyDir.medium字段的值为“Memory”,进而选择把数据保存到tmpfs类型的本地虚拟文件系统中。此外,emptyDir是临时存储,而hostPath的数据是持久化在Node节点的文件系统中的。

物理卷和PVC是卷之外的另外两个重要的概念。Kubernetes可以把外部预创建的数据卷接入到Pod中,Pod无法对数据卷的一些参数(如卷大小、IOps等)进行配置,因为这些参数是由数据卷的提供者预先设定的,这类似于传统存储里预先划分一定的数据卷给应用挂载使用。为了更细粒度地管理数据卷,Kubernetes增加了持久化卷PV(Persistent Volume)的功能,把外置存储作为存储资源池,由平台统一管理并提供给整个集群使用。当Pod需要时,可以向平台请求所需要的存储资源,该请求就被称作PVC。PVC的内容包括访问模式、容量大小等信息。平台根据请求的内容匹配合适的资源,并把得到的PV挂载到Pod所在的主机中供Pod使用。 与普通的卷不同,PV是Kubernetes中的一个资源对象,有独立于Pod的生命周期(PV/PVC的生命周期由PV Controller来实现),创建一个PV相当于创建了一个存储资源对象。Pod通过提交PVC请求来使用PV,整个PV/PVC的使用过程可以分为以下5个阶段。

· 配置:即PV的创建,可以采用静态方式直接创建PV,也可以使用StorageClass动态创建。

· 绑定:将PV分配给PVC。

· 使用:Pod通过PVC使用该卷。

· 释放:Pod释放卷并删除PVC。

· 回收:回收PV,可以保留PV以便下次使用,也可以直接删除。 配置阶段的工作是为集群提供可用的存储卷,可以采用静态或动态两种方式进行创建,工作流程分别如图9-13和图9-14所示。 图9-13 静态配置

管理节点内所有占用磁盘空间的行为确保集群的可用性

1.日志管理 日志管理包括对系统服务日志的管理,也包括对容器日志的管理。 节点上需要通过运行logrotate 的定时任务对系统服务日志进行rotate 清理,以防止系统服务日志占用大量的磁盘空间。Logrotate 的执行周期不能过长,以防日志短时间内大量增长。同时配置日志的rotate 条件,在日志不占用太多空间的情况下,保证有足够的日志可供查看。 容器的日志管理方式因运行时的不同而有所区别:

● 如果选择Docker 作为运行时,那么除了基于系统logrotate 管理日志,还可以依赖Docker 自带的日志管理功能来设置容器日志的数量和每个日志文件的大小。Docker 写入数据之前会对日志大小进行检查和rotate 操作,确保日志文件不会超过配置的数量和大小。

● 如果选择Containerd 作为运行时,那么日志的管理是通过kubelet 定期(默认为10s)执行du 命令,来检查容器日志的数量和文件的大小的。每个容器日志的大小和可以保留的文件个数, 可以通过 kubelet 的配置参数 container-log-max-size 和container-log-max-files 进行调整。

2.hostPath 卷管理 Kubernetes 允许用户通过hostPath 卷将计算节点的文件目录挂载给容器,但目录挂载完成后,系统无法限制用户往该卷写入的数据的大小。这就导致删除容器时,如果不主动进行数据清理,数据就会遗留在节点上,占用磁盘空间。因此,用户能使用的节点路径需要被限制,即Kubernetes 可基于PodSecurityPolicy 限制hostPath 可以映射的主机文件路径。当某一文件路径开放给用户后,用户如何使用hostPath 卷就不受系统管理员的管控了。 因此,是否开放节点路径是一个需要慎重考虑的问题。

3.emptyDir 卷管理 emptyDir 卷可以理解为与Pod 生命周期绑定的、可以限制用量的主机磁盘挂载方式。1.15 版本之前,kubelet 定期执行du 命令获取容器emptyDir 卷的使用量,但是这种方式的实时性不够,且耗时过长,导致磁盘可能在计算过程中就被写满,进而影响系统服务。1.15版本之后,kubelet 使用文件系统自带的Quota 特性设置,并监控emptyDir 卷的大小,kubelet目前只支持XFS 和ext4 的文件系统。emptyDir 卷的使用情况可以实时反馈给kubelet,以防出现磁盘写满的情况。基于文件系统的Quota 特性监控emptyDir 卷的使用情况,相比du 更精准。du 无法监测文件打开后尚未关闭就被删除的情况,但是Quota 能够跟踪到已被删除而文件描述符尚未关闭的文件。

4.容器的可写层管理 容器的用户行为无法预知,如用户可能会将大量数据写入容器的可写层(比如/tmp 目录)。容器的可写层与容器的生命周期一致,数据会随着容器的重启而丢失。如果节点因为磁盘分区管理等原因,发生未开启临时存储管理限制而容器可写层却已达到上限的情况,就只能退而求其次,利用运行时的存储驱动进行限制:DeviceMapper 天然支持对每个容器的可写层限制,而overlayfs2 则需要依赖xfs_quota 特性的支持。

5.Docker 卷管理 在构建容器镜像时,可以在Dockerfile 中通过VOLUME 指令声明一个存储卷。运行时创建该容器时,会在主机上的运行时目录下创建一个子目录,并将其挂载至用户容器指定的目录。容器进程写入目标目录的数据,本质上是被写到主机的根盘或者给运行时分配的磁盘上,而不属于容器的可写层,目前Kubernetes 尚未将其纳入管控范围。当前有众多的开源容器镜像采用此方式定义存储空间,但当这样的镜像被部署到集群中时,会给系统带来潜在的隐患。如果确实需要使用该镜像,又希望存储空间能够被Kubernetes 管理,那么可以在Pod Spec 中定义一个卷,使其在容器内的路径与Dockerfile 中的路径一致。这样容器使用的存储就是定义的卷,而不是系统创建的默认卷。

容器会共享节点的根分区和运行时分区。如果容器进程在可写层或emptyDir 卷进行大量读写操作,就会导致磁盘I/O 过高,从而影响其他容器进程甚至系统进程。另外,对于网络存储卷和本地存储卷也有诸多并发问题需要解决:减少不同容器对同一个磁盘设备的I/O 竞争,以提升性能;降低并发读写,以减少后端的存储压力;减少大量传输数据对网络带宽的影响,等等。为满足这些需求,我们要对容器进程在共享分区的操作进行I/O限速。 Docker 和Containerd 运行时都基于CGroup v1。对于块

持久化存储

半持久化存储(如hostPath)

持久化存储(包含网络存储和本地存储)

引入了 StorageClass、Volume、PVC(Persistent Volume Claim)、PV(Persitent Volume) 的概念,将存储独立于Pod 的生命周期来进行管理。

StorageClass 用于指示存储的类型,不同的存储类型可以通过不同的StorageClass 来为用户提供服务。StorageClass 主要包含存储插件provisioner、卷的创建和mount 参数等字段。

PVC 由用户创建,代表用户对存储需求的声明,主要包含需要的存储大小、存储卷的访问模式、stroageclass 等类型,其中存储卷的访问模式必须与存储的类型一致,包含的三种类型如表2-17 所示。

pV 由集群管理员提前创建,或者根据PVC 的申请需求动态地创建,它代表系统后端的真实的存储空间,可以称之为卷空间。 用户通过创建PVC 来申请存储。控制器通过PVC 的StorageClass 和请求的大小声明来存储后端创建卷,进而创建PV,Pod 通过指定PVC 来引用存储。Pod、PVC、PV、StorageClass 等卷之间的相互关系如图2-23 所示。

图

支持以三种插件的形式来实现对不同存储的支持和扩展

in-tree 插件 在Kubernetes 早期版本中,接口抽象仍不完备,所有存储支持均通过in-tree 插件来实现。

in-tree 插件是指插件代码编译在Kubernetes 控制器和kubelet 中,归属于Kubernetes的核心代码库。

Kubernetes 支持的存储插件不断增加,in-tree 插件与其之间的强依赖关系导致系统维护成本过高,且插件代码与Kubernetes 的核心代码共享同一进程,因此当插件代码异常崩溃时,会导致Kubernetes 核心模块不可用。

FlexVolume 是指Kubernetes 通过调用计算节点的本地可执行文件与存储插件进行交互。

不同的存储驱动对应不同的可执行文件,该可执行文件可以实现FlexVolume 存储插件需要的attach/detach、mount/umount 等操作。

部署与Kubernetes 核心组件分离的可执行文件,使得存储驱动有独立的升级和部署周期,解决了in-tree 存储插件的强耦合问题。但是in-tree 存储插件对Kubernetes 核心组件的强依赖问题依然存在:

FlexVolume 插件需要宿主机用root 权限来安装插件驱动。

FlexVolume 存储驱动需要宿主机安装attach、mount 等工具,也需要具有root 访问权限。

CSI out-of-tree 存储插件 Kubernetes 社区引入了一个in-tree 的CSI 存储插件,用于用户和外挂的CSI 存储驱动的交互。

对于FlexVolume 基于可执行文件的方式,CSI 通过RPC 的方式与存储驱动进行交互。在设计CSI 的时候,Kubernetes 对CSI 存储驱动的打包和部署要求很少,主要定义 了 Kubernetes 的两 个相关 模块: kube-controller-manager 和 kubelet 。kube-controller-manager 模块用于感知CSI 驱动存在,kubelet 模块用于与CSI 驱动进行交互

资料

https://www.163.com/dy/article/H18M1S2M0511CUMI.html

镜像资源管理

应用管理

单个服务应用的创建和模板定义

1)负载分发模式

负载分发模式可分为轮询模式和会话保持模式。

通常可以为服务设置轮询的负载分发模式。

在客户端需要保持会话的应用场景中,应设置负载分发模式为“会话保持”。

2)主机网络模式(hostNetwork)

是否使用主机网络模式,默认值为“否”。

如果选择“是”,则表示容器使用宿主机网络,不再使用容器的Overlay网络,容器IP即宿主机IP,容器端口直接占用宿主机上的端口。在这种模式下,一个Pod将无法在同一台宿主机上启动第2个副本。 那么,

什么场景下需要使用hostNetwork模式呢?在服务需要使用固定的IP地址和端口号,以及需要提高I/O效率的时候,可以使用hostNetwork模式。需要注意的是,当容器出现故障或者容器所在的宿主机出现故障,而无法通过简单地在另一台宿主机上重建一个容器继续提供服务时,为了保证服务的高可用性,通常应该在部署这类服务的时候就引入额外的负载均衡器或其他工具来避免单点故障。

3)服务的端口号设置(Container Port、Node Port) 应用模板可能需要定义Container Port和Node Port,

Container Port为容器内的应用程序监听的端口号,

Node Port为Kubernetes集群内部的微服务需要映射到宿主机的端口号。

上例中的web-service应用设置了Node Port为30001,说明这是一个对集群外部提供服务的应用。 在Kubernetes集群内部,各个微服务通常都无须将端口号映射到宿主机上,仅需要对集群外部提供服务的应用进行设置,同时需要对端口号进行完整的管理。

4)应用配置 应用的配置主要是指应用所需的配置文件,可以通过Kubernetes的ConfigMap进行管理。

在应用能够挂载应用配置之前,运维人员需要在容器云平台上先创建ConfigMap,并发布到指定的集群中,然后在应用创建时对应用配置进行引用。例如,web-service应用在容器启动时将配置文件tomcat-conf挂载(mount)到容器内部的/config-center目录下。

5)环境变量的设置

我们可以将环境变量看作另一种应用程序所需的配置,在容器启动时进行注入,供应用程序读取。

对于应用程序所需的比较简单的可变参数,通常可以通过环境变量的形式进行设置。如果内容非常多,则应考虑使用配置文件,通过ConfigMap的方式挂载到容器内部。

6)存储卷的设置 容器一旦被销毁,容器内部的数据便会全部丢失。为了让容器内部的有用数据能持久化保存,我们可以将容器内部有用的数据通过存储卷保存到宿主机或者网络共享存储中。关于如何选择不同的存储类型,详见2.3节的说明。

7)预终止命令 Kubernetes在停止某个Pod之前,会先执行容器中的preStop Command命令(/tomcat/bin/shutdown.sh),在执行完毕后(或达到最大时间)才会停止Pod。这对于还有部分客户端请求没有完全处理的Pod来说非常重要,在停止Pod之前,应尽量让容器内部的应用程序将请求处理完成并自行退出,避免被强行Kill掉。

8)应用的健康检查 对应用的健康检查可以通过Kubernetes的LivenessProbe探针来探测,判断容器是否正常存活。如果探测到容器不健康,Kubelet则将杀掉该容器,并根据容器的重启策略对容器进行重启。健康检查可以设置的方法有httpGet、tcpSocket和exec,对一个容器仅需设置一种健康检查方法。对应用设置健康检查机制,能够实现应用的高可用。

9)应用的服务可用性检查 容器应用在发布后的运行过程中,需要确保每个应用Pod实例都能持续地提供服务,可以通过Kubernetes的ReadinessProbe探针来探测。如果对某个Pod的服务可用性探测没有得到正常的返回结果,则说明该Pod目前无法提供服务(例如,发生了排队的请求太多、内存不够等情况,则在一段时间后可以恢复正常),Kubernetes将会从Service级别隔离该Pod实例,以减少失败的服务请求响应,避免影响到业务的处理。

多服务组合的应用模板helm

Helm主要涉及Chart、Release和Repository这几个概念。

◎Chart:为一个Helm包,其中包含了运行一个应用所需的工具和资源定义,还可能包含Kubernetes集群中的服务定义,类似于Homebrew中的formula、APT中的dpkg或者Yum中的RPM文件。

图例

图

◎Release:为在Kubernetes集群上运行的一个Chart实例。在同一个集群上,一个Chart可以安装多次。例如有一个MySQL Chart,如果想在服务器上运行两个MySQL数据库,就可以基于这个Chart安装两次。每次安装都会生成新的Release,会有独立的Release名称。

◎Repository:为用于存放和共享Chart的仓库。

应用配置管理

镜像构建注意事项

在打包镜像时,需要注意以下几个关键问题。

(1)需要注意基础镜像的选择问题。选择基础镜像的两个原则:标准化与精简化。尽可能选择Docker官方发布的基础镜像,这些基础镜像通常符合标准化与精简化这两个目标。比如,它们都有Dockerfile源文件,我们可以获知此镜像是如何制作的,并可以在此基础上实现诸如软件版本、性能优化、日志及安全等方面的特殊定制,然后打包为公司级别的内部标准镜像,供各个项目使用。

(2)需要注意业务进程的启动方式。与在物理机上将自己的程序放到后台运行的方式不同,在容器化时,我们需要将自己的业务进程放到前台运行。这样一来,当业务进程由于某种原因而停止时,容器也随之销毁,我们就能及时观察到这种严重故障,并做出相应的行动来恢复系统。目前有一些系统在容器化的过程中采用了supervisord这样的工具,将业务的主进程和辅助进程放到后台启动,并交给supervisord监管,这种做法虽然在一定程度上也能实现自动重启故障进程的目标,但它将问题隐藏得更深,即使业务进程由于特殊故障始终无法重启成功,运维人员也发现不了问题,因此不建议采用这种方式启动业务进程。

(3)需要注意程序的日志输出问题。在物理机上运行业务进程时,我们通常会把程序日志输出到指定的文件中,以便更好地排查故障。但在容器化以后,我们需要改变这种做法,将程序的日志直接输出在容器的屏幕上(或者说控制台Console上),此时Docker会将这些输出日志存放到容器之外的特定文件中,第三方的日志收集工具(例如Elasticsearch)就可以方便采集这些日志并实现集中化的日志搜索和分析功能。此外,Docker也提供了统一的log命令来查看容器的日志,这推进了系统运维的标准化。Java中常用的Log4j及Slf4j日志框架都支持把日志输出到控制台的配置方式,在打包应用时,需要对日志的配置文件做出相应的修改。

(4)需要注意文件操作的问题。当业务进程运行在物理机上时,它看到的文件系统就是物理机的文件系统;但当业务进程运行在容器中时,它所访问的文件系统就是一种特殊的、被隔离的、分层模式的虚拟文件系统,在这种情况下,频繁进行I/O操作的性能比较低。为了解决这个问题,容器可以使用Volume将频繁进行操作的目录映射到容器外部(通常是物理机上);同时,Volume也是容器与外部交换文件的重要工具,因此在制作镜像和运行容器时,需要考虑Volume映射的问题,对于在程序运行过程中产生的大量临时文件和被频繁读写的文件,或者在需要跟外界交换文件时,可以选择挂载Volume。

微服务验证和授权

身份验证和授权也与安全相关,通过限制受信任用户可访问有限的Kubernetes资源来保障。

基于角色的访问控制(Role-based Access Control,RBAC)

RBAC是最佳实践,它有两个概念:角色和绑定。角色定义了一组特定权限的规则。

角色有两种:Role适用于单个命名空间,ClusterRole适用于集群中的所有命名空间。 下面是默认命名空间中的一个角色,该角色允许获取、监控和列出所有Pod。

每个角色都有三部分——API组、资源和动作: 集群角色也有类似的配置,除了没有命名空间字段,因为它适用于所有命名空间。

绑定会将一系列主题(用户、用户组或服务账户)与角色相关联。绑定有两种类型,RoleBinding和ClusterRoleBinding,它们分别对应于Role和ClusterRole。 有趣的是,你可以将ClusterRole绑定到单个命名空间中的主题。这对于定义需要应用到多个命名空间的角色很方便,一旦创建了集群角色,你可以将它们绑定到特定命名空间中的特定主题。 集群角色绑定也是类似的配置,但是注意它必须绑定一个集群角色,并且始终应用于整个集群。 注意,RBAC用于授予对Kubernetes资源的访问权限。它可以管理对服务端点的访问,但是你可能仍需要微服务中的细粒度授权

使用Kubernetes配置微服务

ConfigMap是由Kubernetes每个命名空间管理的资源,并且可以被任何Pod或容器引用。

下面是link-manager服务的ConfigMap: link-manager部署资源通过使用envFrom将其导入到Pod中:

这样做的效果是,当link-manager服务运行时,ConfigMap的data部分中的键值对被映射为环境变量: 让我们看看Argo CD如何形象地显示link-manager服务的ConfigMap。注意图5-1中顶部名为link-service-config的框体。 单击ConfigMap框可以从Argo CD界面下钻到具体的ConfigMap,如图5-2所示。 图5-1 查看link-manager服务的ConfigMap 图5-2 查看具体的ConfigMap 注意,

由于ConfigMap被用作环境变量,因此这属于静态配置。如果要更改其中任何一项内容,则需要重新启动服务。

在Kubernetes中,这可以通过以下两种方式完成:

·终止Pod(部署的副本集将创建新的Pod)。

·删除并重新创建部署(具有相同的效果,但是你无须显式地终止Pod)。

·应用其他更改并重新部署。 让我们看看在代码中是如何使用它的,代码在svc/link_manager/service/link_manager_service.go文件中: os.Getenv()标准库函数从环境变量中获取PORT和MAX_LINKS_PER_USER的值,这一点非常棒,它允许我们测试Kubernetes集群之外的服务而不影响正常的配置。

1.创建和管理ConfigMap Kubernetes提供了多种创建ConfigMap的方法:

·通过命令行中的值。

·来自一个或多个文件。

·从整个目录。

·通过直接创建ConfigMap YAML清单。

无论哪种方式,最后所有ConfigMap都是一组键值对,键和值是什么取决于创建ConfigMap的方法。在使用ConfigMap时--dry-run标志很有用,通过它可以在实际创建之前查看将要创建的ConfigMap。让我们看一些例子,下面是从命令行参数创建ConfigMap的方法: 这是测试ConfigMap最常用的方式,但是,你必须使用烦琐的--from-literal参数分别指定每个配置项。 从文件创建ConfigMap是一种更可行的方法。它与GitOps概念配合得很好,你可以在其中保留用于创建ConfigMap的源配置文件的历史记录。我们可以创建一个非常简单的名为comics.yaml的YAML文件: 接下来,使用以下命令从该文件创建ConfigMap(只是--dry-run试运行)

应用上容器云的准入条件和最佳实践

整体而言,应用上容器云的准入条件包含如下几个方面(包含但不限于)。

已建立了清晰的可自动化的编译及构建流程:应用使用如Maven、Gradle、Make或Shell等工具实现了构建编译步骤的自动化,以便在容器平台上实现自动化的编译及构建流程。

已实现应用配置参数外部化:应用已将配置参数外部化于配置文件或环境变量中,以便应用容器能适配不同的运行环境。包含特定环境的配置的容器镜像不能在整个环境(Dev、QA、Prod)中升级。为了实现可靠的发布过程,应将在较低环境中测试过的相同镜像部署到生产中。将特定环境的配置保留在容器镜像之外,例如,使用ConfigMap和Secret存储应用程序配置。

已提供合理可靠的健康检查接口:容器平台将通过健康检查接口判断容器状态,对应用服务进行状态保持。

已实现状态外部化,以及应用实例无状态化:应用状态信息存储于数据库或缓存等外部系统,应用实例本身实现无状态化。

不涉及底层的操作系统依赖及复杂的网络通信机制:应用以处理业务为主,不强依赖于底层操作系统及组播等网络通信机制,提高可移植性。

部署交付件及运行平台的大小在2GB以内:轻量级的应用便于在大规模集群中快速传输分发,更符合容器敏捷的理念。

启动时间在5分钟以内:过长的启动时间将不能发挥容器敏捷的特性。

如果应用明显不符合上述条件,则其暂时不适合运行在容器上。

在应用上容器云时,除了需要遵循以上准入条件,还需要尽量符合以下最佳实践。

在Pod定义中指定资源请求和资源限制。如果请求资源的配置不正确的话,那么应用程序可能会耗尽内存或导致CPU资源不足。指定请求的内存和CPU资源可以使集群做出适当的调度决策,以确保应用程序具有足够的可用资源。 使用Pod中断预算保护应用程序。在某些情况下,需要将应用程序容器从集群节点中逐出。例如,在管理员可以执行节点维护之前或在缩减规模时集群自动缩放器可以从集群中删除节点之前,需要驱逐Pod。为确保驱逐Pod时应用程序仍然可用,你必须定义各自的PodDistruptionBudget对象。PodDisruptionBudget是一个API对象,用于指定保证应用可用的最小副本数或最小百分比。 每个容器运行一个进程。避免在单个容器中运行多个进程。每个容器中运行一个进程可以更好地隔离进程,避免信号路由出现问题。 应用程序监视和警报。应用程序监视和警报对保持应用程序在生产中良好运行并满足业务目的至关重要。可以使用Prometheus和Grafana等监视工具来监视你的应用程序。 配置应用程序以将其日志写入stdout或stderr。容器云将收集这些日志并将其发送到集中位置(ELK、Splunk)。在分析生产问题时,应用程序日志是宝贵的资源。基于应用程序日志内容的警报有助于确保应用程序按预期运行。 考虑实施弹性措施:断路器、超时、重试、速率限制。弹性措施可以使你的应用程序在出现故障时表现更好。它们可保护你的应用程序免于过载(速率限制、断路器),并在遇到连接问题(超时、重试)时提高性能。考虑利用OpenShift Service Mesh来实现这些措施,需在应用程序中更改代码。 使用受信任的基础镜像(base image)。尽可能使用容器厂商提供的企业级容器镜像。容器厂商提供的镜像已通过测试、安全加固并有相应的技术支持。如果使用社区提供的镜像,请尽量使用你信任的社区提供的镜像。不要使用公共注册表(例如Docker Hub)中有未知来源的镜像。 使用最新版本的基础镜像。通常,仅最新版本的容器镜像包含所有可用的安全修复程序。设置CI管道,以便在构建应用程序镜像时始终提取最新版本的基础镜像,同时在更新的基础镜像可用时重建应用程序。 使用单独的构建镜像和运行时镜像。创建具有最小依赖的、单独的运行时镜像可减少攻击面,并产生较小的运行时镜像。构建镜像包含构建依赖关系,构建依赖关系对于构建应用程序是必需的,对于运行应用程序则不是必需的。 尽可能遵守受限制的安全上下文约束(SCC)。修改你的容器镜像以允许在受限制的SCC下运行。应用程序容易受到攻击,强制使用OpenShift受限制的SCC可提供最高级别的安全性,以防止在应用程序被破坏的情况下损害集群节点。 使用TLS保护应用程序组件之间的通信。应用程序组件可能会传达应受到保护的敏感数据。除非你认为基础OpenShift网络是安全的,否则你可能希望利用TLS保护应用程序组件之间的通信。考虑利用OpenShift Service Mesh从应用程序中卸载TLS管理。

平台运维管理

日志 监控 告警管理

安全管理

云平台上的安全机制至少应该从以下几方面进行设计和管理:

各级用户角色的权限管理、

租户之间资源和应用的隔离、

网络层面的安全、

与应用相关的敏感信息的管理(如密码、密钥类数据)、镜像库的安全管理,等等。

用户角色权限管理

在容器云平台上,用户的权限至少应该包括平台管理员和租户两个级别,通常还应为租户设置租户级别的管理员和普通用户这两个级别。图5-19描述了容器云平台上的用户角色权限管理。

◎ 平台管理员:负责整个平台范围内的租户管理,并为租户分配其需要的系统资源。包括租户的创建、系统资源分区的设置、资源分区与租户进行绑定等管理工作。

◎ 租户管理员:为一个租户范围内的管理员,如果系统比较复杂,则可以通过创建用户组和用户,进一步细分资源分区,将细分的资源分区与用户进行绑定等操作,完成租户范围内的安全管理。如果系统不很复杂,则租户管理员也可以作为普通用户,在其可用的资源分区上部署应用。

◎ 普通用户:主要负责应用的管理,包括应用的部署、更新、监控、查错等应用全生命周期管理。普通用户应该无须关心平台级别的资源设置,只需在可用的资源分区上管理业务应用。

可以使用Kubernetes提供的授权机制对用户设置应用的访问权限,实现应用级别的安全管理。

Kubernetes Master为用户对应用的请求进行授权,通过“授权策略”决定其访问请求能否被允许。简而言之,授权就是将不同的资源访问权限授予不同的用户。Kubernetes目前支持以下几种授权策略。 ◎AlwaysDeny:表示拒绝所有请求,仅用于测试。 ◎AlwaysAllow:表示允许接收所有请求,不启用授权机制。 ◎ABAC(Attribute-Based Access Control):基于属性的访问控制,使用用户配置的授权规则对用户的请求进行匹配和控制。 ◎Webhook:通过调用外部RESTful服务对用户的请求进行授权。 ◎RBAC:全称为Role Based Access Control,指基于角色的访问控制。 其中,Webhook方式是由外部系统完成授权的工作,本章不做说明。ABAC模式的实现基于授权策略文件,如有修改,则需要重启API Server才能生效,不够灵活和方便。

RBAC授权模式引入了4种新的资源对象:Role、ClusterRole、RoleBinding和ClusterRoleBinding。其中Role和ClusterRole都是“角色”的概念,RoleBinding和ClusterRoleBinding都是“角色绑定”的概念。角色是对一系列资源的权限集合,例如一个角色可以拥有读取Pod的权限和删除Pod的权限,是Namespace级别的;而ClusterRole是集群级别的权限集合。角色绑定则将角色与用户进行绑定,使得这些用户拥有在“角色”中定义的权限,ClusterRoleBinding则使用户拥有在“ClusterRole”中定义的集群级权限。 图5-20展示了对Pod的get/watch/list操作进行授权的Role、RoleBinding、用户及资源对象之间的授权关系。 目前,RBAC机制已与Kubernetes深度集成,建议应用系统的各资源对不同的用户进行RBAC授权设置,以实现对资源访问的安全控制。下面对RBAC的设置和应用进行说明。

图

应用系统需要配置诸如密码或密钥之类的敏感信息,使用明文的方式保存在配置文件中显然很不安全。在Kubernetes系统中,可以使用Secret资源对象来管理敏感信息,目前Secret有以下3种类型。

◎Opaque:字符串类型的加密信息。

◎kubernetes.io/dockerconfigjson:用于在拉取镜像(pull)操作时访问Docker镜像库的凭据信息。

◎kubernetes.io/service-account-token:用于ServiceAccount使用的密钥信息。

数据备份管理

功能实现

全景图

全景

服务发現

Service定义了一个服务的访问入口地址,

前端的应用(Pod)通过这个入口地址访问其背后的一组由Pod副本组成的集群实例,

Service与其后端Pod副本集群之间则是通过Label Selector来实现“无缝对接”的。

而RC的作用实际上是保证Service的服务能力和服务质量始终处于预期的标准。

流程

1.在服务Pod实例发布时(可以对应K8s发布中的Kind: Deployment),Kubelet会负责启动Pod实例,启动完成后,Kubelet会把服务的PodIP列表汇报注册到Master节点。

2.通过服务Service的发布(对应K8s发布中的Kind: Service),K8s会为服务分配ClusterIP,相关信息也记录在Master上

3.在服务发现阶段,Kube-Proxy会监听Master并发现服务ClusterIP和PodIP列表映射关系,并且修改本地的linux iptables转发规则,指示iptables在接收到目标为某个ClusterIP请求时,进行负载均衡并转发到对应的PodIP上。

4.运行时,当有消费者Pod需要访问某个目标服务实例的时候,它通过ClusterIP发起调用,这个ClusterIP会被本地iptables机制截获,然后通过负载均衡,转发到目标服务Pod实例上。

service 详解

Cluster IP和主机名

Kubernetes会从集群的可用服务IP池中为每个新创建的服务分配一个稳定的集群内访问IP地址,称为Cluster IP。

Kubernetes还会通过添加DNS条目为Cluster IP分配主机名。

Cluster IP和主机名在集群内是独一无二的,并且在服务的整个生命周期内不会更改。只有将服务从集群中删除,Kubernetes才会释放Cluster IP和主机名。

用户可以使用服务的Cluster IP或主机名访问正常运行的Pod。

用户不用担心服务出现单点故障问题,

Kubernetes会尽可能均匀地将流量分布到在多个节点上运行的Pod,

因此一个或若干个(但不是所有)节点的服务中断情况不会影响服务的整体可用性。

Kubernetes使用Kube-proxy组件管理各服务与之后端Pod的连接,该组件在每个节点上运行。

Kube-proxy是一个基于出站流量的负载平衡控制器,

它监控Kubernetes API Service并持续将服务IP(包括Cluster IP等)映射到运行状况良好的Pod,落实到主机上就是iptables/IPVS等路由规则。

访问服务的IP会被这些路由规则直接DNAT到Pod IP,然后走底层容器