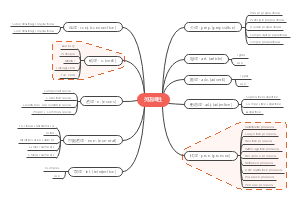

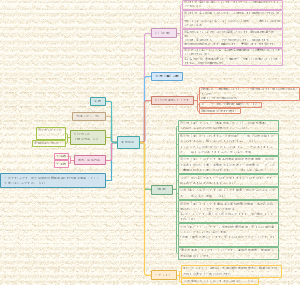

导图社区 统计学基础知识 第五章 相关分析与回归分析

- 694

- 33

- 4

- 举报

统计学基础知识 第五章 相关分析与回归分析

统计学基础知识-相关分析、一元线性回归分析。

编辑于2020-05-18 16:32:13- 回归分析

- 相似推荐

- 大纲

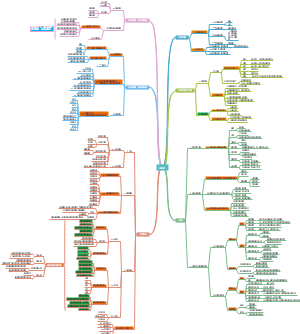

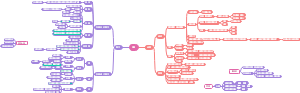

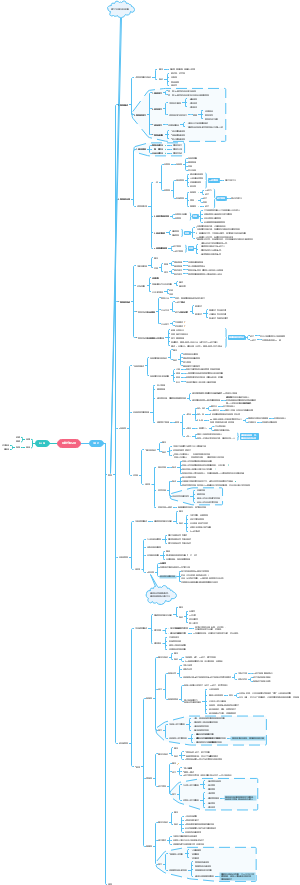

相关分析与回归分析

相关分析

相关关系

定义

存在着密切的联系但又不是严格的、确定的关系

内容

确定现象之间有无关系,相关分析的起点,只有存在相关依存关系,才有必要进行进一步的分析--定性分析是判断现象是否具有相关关系最基本的方法

确定相关分析的表现形式,采用散点图来直观判断现象之间相关关系的类型

测定相关关系的密切程度--通过相关系数来测定现象之间相关关系的密切程度

描述-散点图

相关的形态

散点图近似地表现为一条直线或直线带,称为线性相关

散点图近似地表现为一条曲线,称为非线性相关或曲线相关

相关的方向

正相关-两个变量的变动方向总体上相同,一个变量增加,另一个变量也相应地增加,一个变量减少,另一个变量也相应地减少,两关系为正相关。5-2a

负相关-若两个变量变动的方向总体上相反,一个变量增加的同时,另一个变量随之减少时,两个变量之间的关系属于负相关 5-2b

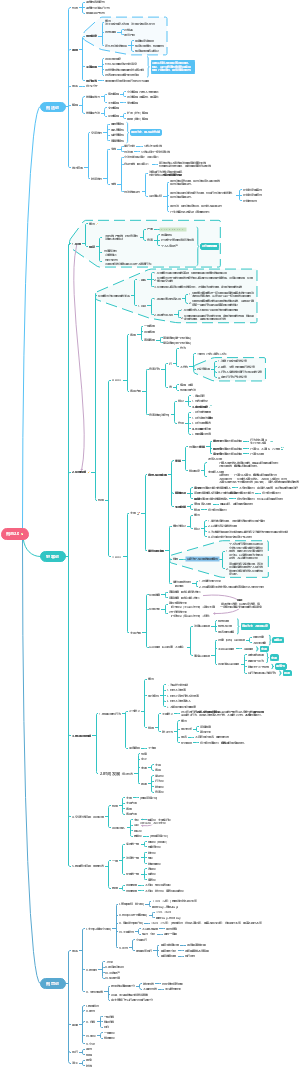

相关程度的测定

相关系数的计算

是测定变量之间关系密切程度的量,它能够以数字准确地描述变量之间的相关程度

Pearson相关系数是用来度量两个定量变量x与y之间的线性相关程度

计算公式

计算相关系数时,假定两个变量之间是线性关系,而且两个变量都是随机变量,样本数据中不应有极端值,否则会对相关系数的值有较大影响

性质

r的取值范围[-1,1],即-1£r£1

r>0,表明x与y之间有正线性相关关系

r<0,表明x与y之间有负正线性相关关系

r值越接近1就越正相关

r值越接近-1就越负相关

r值越接近0,越不相关

r=-1,r=1,表明x与y之间是完全相关关系(函数关系)

r具有对称性

x与y之间的相关系数r 和y 与x之间的相关系数r 相等,即

r数值大小与x和y的数据原点及计量尺度无关,改变x和y的数据原点或计量尺度,并不改变r数值大小

r仅仅是x和y之间线性关系的一个度量,它不能用于描述非线性关系 如r=0,只表示两个变量之间不存在线性相关关系,并不表明变量之间没有任何关系,比如它们可能存在非线性相关关系

r虽然是两个变量之间线性关系的一个度量,却不一定意味着x与y一定有因果关系

r取值

当½r½³0.8时,可视为高度相关

当0.5£½ ½<0.8时,可视为中度相关

当0.5£½r½<0.5时,可视为低度相关

当|r|<0.3时,说明两个变量之间的相关程度极弱

以上解释必须建立在对相关系数显著性检验的基础上

相关系数的检验

相关系数的检验用Fisher提出的t分布检验,该检验可用小样本,也可用大样本

首先确定原假设

H :两变量之间不存在线性相关

H :两变量之间存在线性相关

其次,计算统计量t值

最后,利用对应的概率值进行判断,如果概率值小于或等于指定的显著性水平(一般a=0.05)则可以拒绝原假设,接受备择假设,即两变量之间存在线性相关关系,否则不能拒绝原假设,可以认为两变量之间不存在显著的线性相关关系

多元线性回归分析

回归分析的其他问题

非线性回归

抛物线函数

双曲线函数

幂函数

指数函数

对数函数

S型曲线函数

违背回归模型统计 假设的后果和补救

异方差

回归模型随机误差项u的方差为常数的假定不成立

帕克检验法、斯皮尔曼等相关检验法、戈德弗尔德-匡特检验法、格里瑟检验法、怀特检验法、布鲁奇-帕根检验法

序列相关

不是最优线性无偏估计量,使得回归系数的置信区间和显著性检验也不再可信

德宾-沃森、拉格朗日乘数(Lm)法

多重共线性

完全的多重共线性会导致普通最小二乘估计无法应用,通常统计/计量软件给出出错信息,运算过程中止

VIF指标超过5,意味着严重多重共线性的存在

降低自变量之间多重共线性的常见方法:增加样本容量、对模型施加某些约束条件、删除一个或几个共线性解释变量或者将模型适当变形

采用岭回归、lasso回归、偏最小二乘回归等其他估计方法估计模型参数

一元线性回归分析

回归分析是考察若干自变量x与因变量y之间的数量变化规律的他哦那估计方法和技术

一元线性回归模型

理论回归模型

线性理论回归模型

一部分是由于x的变化引起的y的变化的部分,即

另一部分是由除去x外的其他一切被忽略的、没有考虑到的因素引起变化及数据的测量误差等即 ,为随机误差

估计的回归方程

估计的线性经验回归方程

模型参数估计

b0b1不是唯一确定的,为了由样本数据的到回归方程中b b 的理想估计值,即得到这些参数的最小无偏估计量,采用普通最小二乘法

最小二乘法

要寻找b0b1的估计值b0b1,使Q达到最小

回归系数的含义

y=b0+b1x中的b0是直线的截距,表示当解释变量为零时y的平均值

回归系数b1是直线的斜率,表示解释变量x每增加一个单位,被解释变量将相应地平均变化b1个单位

子主题

回归直线及估计量的有关性质

回归直线性质

直线通过均点(X,Y)

直线上方各点到直线的纵向距离之和=直线下方各点到直线的纵向距离之和

各点到该回归线纵向距离平方和较到其它任何直线者为小

回归估计量性质

线性性:是否是另一随机变量的线性函数

无偏性:它的均值或期望值是否等于总体的真实值

有效性:是否在所有线性无偏估计量中具有最小方差

在给定经典线性回归的假定下,最小二乘估计量是具有最小方差的线性无偏估计量

回归方程的评价的检验

理由

1.在利用样本数据估计回归模型时,首先是假设变量y与x之间存在着线性关系,但这种假设是否存在需要进行检验

2.估计的回归方程是否真正描述了变量y与x之间的统计规律性,y的变化能否通过模型中的解释变量去解释需要进行检验等

经济意义检验

利用相关的经济学原理及我们所积累的丰富经验,对所估计回归方程的回归系数进行分析与判断,看其是否能得到合理的解释

当模型明显有不合理的经济解释,与经济理论不相符,如果无合理的原因进行解释,那么该模型则无法应用

拟合程度分析

判定系数R:可决/决定系数,该指标建立在对总离差平方和进行分解的基础上的,用来说明回归方程对观测数据拟合程度的一个度量值

各观测点越是紧密围绕直线,说明直线对观测数据的拟合程度越好,判定系数越高,反之则越差,判定系数越小

因变量y的取值是不同的,y 取值的这种波动称为变差

总变差平方和SST:n次观测值的总变差可以由这些变差的平方和来表示

可解释的变差平方或回归平方和SSR: 是回归值y与均值y 的离差平方和,它可以看作是y的总变差中由于x与y的线性关系引起的y的变化的那部分,可用回归直线来解释

不可解释的变差或剩余平方和SSE: 是各实际观测值与回归值的残差平方和,它是除了x对y的线性影响之外的其他因素对y的变差作用,是不能用回归直线来解释的 SST=SSR+SSE

SSR越大,SSR占SST的比例越大,通过这一比例来反映直线对观测值的拟合程度,称为判定系数R

R的取值范围为[0,1],R=1时,拟合是完全的,所有观测值都在直线上,若x与y无关,x完全无助于解释y的变差,此时y=y,则R=0.

R越接近于1,表明回归平方和占总变差平方和的比重越大,回归直线与各观测点越接近,回归直线的拟合程度越好,R越接近于0,回归直线的拟合程度越差

估计标准误差是残差平方和的均方根用S 表示

S越小,根据回归方程进行预测也就越准确

若各观测点全部落在直线上,则S=0,此时用自变量来预测因变量是没有误差的

统计检验

F检验

线性回归方程的显著性检验

F检验是根据平方和分解式,直接从回归效果检验回归方程的显著性

根据伴随概率进行判断,如果伴随概率sig值或P值小于我们事前确定的显著性水平a时,拒绝原假设,认为b是不为零的,回归方程的线性关系是存在的

否则不能拒绝原假设,即回归方程不存在线性关系

t检验

回归系数的显著性检验

如果H0成立,则因变量y对解释变量x之间没有真正的线性关系,即x的变化对y并没有显著的线性影响

如果伴随概率sig值小于我们事前确定的显著性水平a时,拒绝原假设,认为b=0,即解释变量x对y的线性效果不显著

用回归方程进行预测

点估计

利用估计的回归方程,对于自变量的一个特定值,求出因变量Y的一个估计值

平均值的点估计

个别值的点估计

对于同一个自变量的给定值,平均值的点估计和个别值的点估计的结果是一样的,在区间估计中有所不同

区间估计

平均值的置信区间

对于一个给定的x值x,y的均值E 的置信区间

特定值的预测区间

对于一个给定的x值x,y的一个特定值的估计区间