导图社区 隐私保护增强技术

- 67

- 0

- 0

- 举报

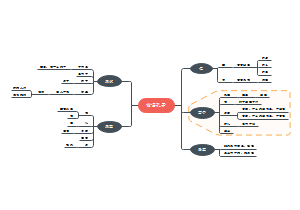

隐私保护增强技术

这是一篇关于隐私保护增强技术的思维导图,主要内容包括:概述,差分隐私,去标识化。涉及用户隐私,一般是不能直接提供给其他组织的,甚至连企业内部的不同业务团队也不能直接提供。

编辑于2024-10-05 16:15:17- 隐私保护

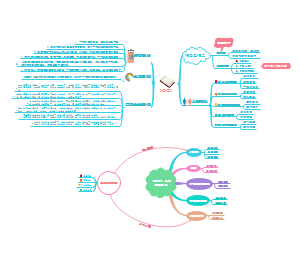

- DPIA流程和模板

这是一篇关于DPIA流程和模板的思维导图,主要内容包括:DPIA模版,DPIA概述和范围,如何执行DPIA,可接受的DPIA标准,DPIA解决什么问题,DPIA执行标准。

- GDPR全文和解析

本文翻译了GDPR并且添加了解析,深入剖析GDPR的各个方面,可以更好地理解这一法规的重要性,并为企业和个人在数据保护方面提供有益的指导和建议。非常有价值。

- 信息安全技术 、数据安全能力成熟度模型DSMM详解

这是一篇关于信息安全技术 、数据安全能力成熟度模型Informatio的思维导图,主要内容包括:附 录 C (资料性附录) 能力成熟度等级评估流程和模型使用方法,附 录 B (资料性附录) 能力成熟度等级评估参考方法,DSMM架构,附 录 A(资料性附录) 能力成熟度等级描述与 GP,DSMM-数据安全过程维度,DSMM-安全能力维度。

隐私保护增强技术

社区模板帮助中心,点此进入>>

- DPIA流程和模板

这是一篇关于DPIA流程和模板的思维导图,主要内容包括:DPIA模版,DPIA概述和范围,如何执行DPIA,可接受的DPIA标准,DPIA解决什么问题,DPIA执行标准。

- GDPR全文和解析

本文翻译了GDPR并且添加了解析,深入剖析GDPR的各个方面,可以更好地理解这一法规的重要性,并为企业和个人在数据保护方面提供有益的指导和建议。非常有价值。

- 信息安全技术 、数据安全能力成熟度模型DSMM详解

这是一篇关于信息安全技术 、数据安全能力成熟度模型Informatio的思维导图,主要内容包括:附 录 C (资料性附录) 能力成熟度等级评估流程和模型使用方法,附 录 B (资料性附录) 能力成熟度等级评估参考方法,DSMM架构,附 录 A(资料性附录) 能力成熟度等级描述与 GP,DSMM-数据安全过程维度,DSMM-安全能力维度。

- 相似推荐

- 大纲

隐私保护增强技术

概述

涉及用户隐私,一般是不能直接提供给其他组织的,甚至连企业内部的不同业务团队,也不能直接提供。

输入法的文字输入、表情的使用记录等,用于候选文字推荐、候选表情推荐等;当输入专业词汇,或新的流行语出现时,它就能很快出现在候选词列表,以提高用户输入效率及体验;但用户的输入却是个人隐私。

接下来,我们将主要介绍:

■ 数据集对外发布的隐私保护技术:主要包括匿名化(含K -匿名)、假名化(使用假名替换真名)等去标识化手段,将数据集清洗后提供给第三方,目的是让第三方无法从发布的数据集定位到真实的自然人,保护自然人的隐私。

■ 针对统计聚合数据添加噪声的差分隐私技术,主要用于对外开放的交互式统计查询接口、用户侧数据统计等场景。

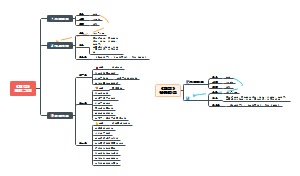

去标识化

去标识化就是通过使用匿名、假名等方法,让攻击者无法从处理后的数据记录定位到自然人的过程。

匿名化

所谓匿名化,就是通过一定的算法,不可逆地去除数据集中的身份标识信息,使得无法从中定位到任何自然人。

根据这个定义,匿名化是一个目标,匿名化之后,无法定位到任何自然人,也就不会泄露个人数据了,可以不再看成是个人数据。

但是也要意识到,在实践中,往往很难做到真正的匿名化并同时保持数据的可用性,而需要在数据的可用性与隐私保护之间进行权衡。也就是说,匿名化是一个非常难以达成的目标。

我们假设原始记录包含如表所示的原始数据(数据为虚构)。

其中的姓名、身份证号和家庭住址,很容易直接关联到该患者本人,且这几个字段对于学术研究用处不大,应首先排除。这样,数据集就简化成表。

是不是这样就可以保证患者隐私不泄露了呢?其实不然。在2000年,来自卡内基梅隆大学的Latanya Sweeney教授(现为哈佛大学教授)发表了一篇报告“Simple Demographics often Identify People Uniquely”(简单的人口统计往往能识别出人的独特性)报告,报告指出:少数特征的组合结合在一起即可唯一地识别部分自然人。他基于美国选举人公共注册信息,统计出:

■ 87%的美国人基于(邮编、性别、出生日期)可被唯一确定。

■ 53%的美国人通过(地址、性别、出生日期)可被唯一确定。

■ 18%的美国人通过(县、性别、出生日期)可被唯一确定。

也就是说,上述简化后的数据集,有大概87%的记录可唯一定位到个人。

可见这样简化后的数据也是不能发布的,简单地删除敏感字段或假名化(姓名替换为假名),并不足以保护个人隐私。

2006年8月,为了学术研究,美国在线(AOL)公开了匿名的搜索记录。纽约时报通过这些搜索纪录,找到了ID匿名为4417749的用户在真实世界中对应的个人。因为隐私泄露事件,AOL遭到了起诉(诉讼请求包括赔偿受影响用户每人5000美元)。

假名化

假名化,就是对可标识的用户身份信息用假名替换。但是需要了解的是,假名化的数据,仍是有很大概率找出对应的自然人,难以达到去标识化的目的,所以假名化的数据仍将被视为个人数据,需要跟明文数据一样加以保护。

K -匿名

上面提到的删除姓名或使用假名,虽然无法直接标识用户,但攻击者还是有可能通过多个属性值,结合其他已知的背景知识,识别出真实的个人,从而导致自然人的隐私数据泄露。

K -匿名(k-anonymity)是由Pierangela Samarati和Latanya Sweeney提出的隐私保护模型,它通过引入等价类的概念,保障每条隐私数据都能找到相似的数据,从而降低了单条数据的识别度。K -匿名的使用场景主要是数据集发布或数据集提供给第三方研究机构。

K -匿名要求发布的数据中k条记录为一组,其中的每一条记录都要与其他至少k-1条记录不可区分(这k条记录相似,称为一个等价类)。

这里,参数k为一个整数,表示隐私保护的强度:

■ k值越大,隐私保护的强度越强(任何一条疑似某人的记录,都可以再找到k-1条相似的记录)。

■ k值越大,丢失的信息更多,数据的可用性就越低(一些比较罕见的样本如果无法凑成一个等价类就不能用了)。

怎么理解呢?我们来看一个最简单的k=2的场景,处理后的数据如表所示。

当研究者拿到K -匿名处理后的数据时,将至少得到k个不同人的记录,进而无法做出准确的判断;也就是说,任何一条记录,都可以再找到k-1条相似的记录。

但这仍然是存在缺陷的,如果一个等价类中的多个样本都是同一种疾病(比如乙型肝炎),则所涉及的几位自然人的隐私就泄露了,可能会被周围认识的人高度怀疑其患了该病,称之为一致性攻击,如表所示。

为了防止一致性攻击,L-Diversity(L -多样性)隐私保护模型在K -匿名的基础上,要求保证任意一个等价类中的敏感属性都至少有L个不同的值。

上面的数据样本,如果在一个等价类中,疾病种类小于L,则这个等价类中的记录就不能使用了。因为,只有一个人患该病的话,也会造成该患者的隐私泄露,至少需要在一个等价类中为其找到L-1个病友(行记录),才能降低其中每一患者隐私泄露的风险。

不过,就算满足L-Diversity,仍有可能导致隐私泄露,假如有一个敏感字段为HIV筛查结果(阳性、阴性),可以达成2-Diversity,但这个多样性其实没有意义,无论结果是阴性还是阳性,记录出现在这个数据集本身就造成部分隐私信息泄露。

此外,L-Diversity还存在没有考虑敏感字段的总体分布、语义等方面的缺陷。

为解决L-Diversity模型的缺陷,引入T-Closeness模型,保证在一个等价类中,敏感信息的分布情况与整个数据集的敏感信息分布情况接近(close),不超过阈值t。不过,这也并不能防止隐私信息泄露。结合背景知识和数据集披露的信息,攻击者仍可能获取更多的信息。由于在实践中使用较少,这里仅做概念介绍,不再展开。

K -匿名在实践中,总是不断地被发现存在缺陷以及不断地改进;基于当前知识判断不会造成隐私泄露,也不能排除将来有攻击者从中找出真实的自然人的隐私,因此直接提供数据集的方式所面临的风险还是非常高的

麻省理工学院学者Yves-Alexandre de Montjoye的一份研究中表明,仅仅需要4个跟用户相关的外部信息,比如运动轨迹或定位、点评或评分、消费记录等,攻击者就有超过90%的概率识别出特定的用户。因此,尽量不要直接对外提供数据集。

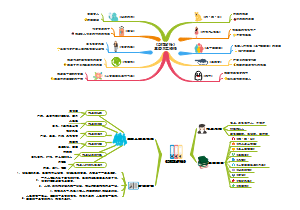

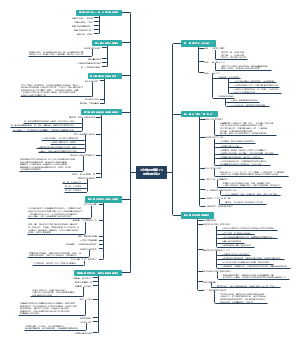

差分隐私

差分隐私(Differential privacy, DP)就是为了解决差分攻击而引入的解决方案,是微软研究院的Dwork在2006年提出的一种隐私保护模型,可以有效防止研究人员从查询接口中找出自然人的个人隐私数据。其原理是在原始的查询结果(数值或离散型数值)中添加干扰数据(即噪声)后,再返回给第三方研究机构;加入干扰后,可以在不影响统计分析的前提下,无法定位到自然人,从而防止个人隐私数据泄露。

差分隐私主要适用于统计聚合数据(连续的数值,或离散的数值),如交互式统计查询接口、API接口、用户侧数据统计等。

差分隐私原理

为了防止攻击者利用减法思维获取到个人隐私,差分隐私提出了一个重要的思路:在一次统计查询的数据集中增加或减少一条记录,可获得几乎相同的输出。

也就是说任何一条记录,它在不在数据集中,对结果的影响可忽略不计,从而无法从结果中还原出任何一条原始的记录。

假设原始数据集为D(可以理解为一张表),在其基础上增加或减少一条记录构成D',这时D和D’为临近数据集;假设某个差分隐私算法为A(),对数据集D运算并添加噪声的结果为A(D) = V;对数据集D’运算并添加噪声的结果为A(D') = V'; V和V’就是统计运算的结果,差分隐私要求对临近数据集的运算结果基本一致,即V= V'。

选用不同的输入(D),输出(V)也会不同,我们用P()表示A(D) = V的概率,则对于所有的输出V,要求:

在数学上,当ε比较小时, eε≈1 + ε 如: e0.1≈1.105 e0.2≈1.221 e0.3≈1.350

差分隐私从数学上证明了,即使攻击者已掌握除某一条指定记录之外的所有记录信息(即最大背景知识假设),它也无法确定这条记录所包含的隐私数据。差分隐私同时也对隐私保护水平给出了严谨的定义和量化评估方法。差分隐私的这些优势,使其一出现便成为隐私保护研究的热点。

差分隐私噪声添加机制

通常使用如下机制来实现差分隐私保护:

■ 拉普拉斯(Laplace)机制,在查询结果里加入符合拉普拉斯分布的噪声(也可以在输入或中间值加噪声),用于保护数值型敏感结果;假设某公司有5000名研究生学历的职员,在查询结果中加入噪声之后,每次查询得到的结果都不一样,有很高的概率得到4990~5010之间的数值,而出现4975以下或5025以上数字的概率很小。

■ 指数(Exponential)机制,用于保护离散型敏感结果(如疾病种类)。

数值型差分隐私

针对数值型查询结果,差分隐私从数学上证明,如下在结果上添加噪声的公式,满足ε-差分隐私要求:

其中:

DP(D)表示基于数据集D添加了噪声的结果输出;

f(D)表示未添加噪声的基于数据集D的原始查询的结果,结果可以是多维的,如二维(sum_a, sum_b);

(Y1, Y2…Yn)(记为Y),表示每个维度的噪声,服从参数μ= 0, b= GSf/ε的拉普拉斯分布;

GSf= max||f( D) - f( D')||表示f( x)的全局敏感度(Global Sensitivity, GS),为函数f( D)作用在所有临近数据集的曼哈顿距离的最大值;由于临近数据集有很多对,需要取最大值才能避免隐私泄露。

如果固定数据集D(是原始数据集中的一个子集),计算与其所有临近数据集的曼哈顿距离的最大值,则为局部敏感度(Local Sensitivity, LS)。所有局部敏感度的最大值,即为全局敏感度。

Lap( μ, b)表示拉普拉斯分布函数,如图18-5所示,其中μ为位置常数,默认取0, b为尺度参数,取值GSf/ε,其概率密度函数p(x)如下:

数值型差分隐私的局限性

差分隐私的全局敏感度对于单个返回值的场景表现较好,但不太适合复杂的具有多个返回值的复杂查询场景,特别是多个返回值不在同一量级时;如果使用局部敏感度,可能会造成隐私泄露;这时可能需要引入新的敏感度或算法。