导图社区 预测分类,聚类模型

- 251

- 8

- 2

- 举报

预测分类,聚类模型

数学建模思维导图,包括了预测分类模型,聚类算法、分类模型、预测模型、聚类特征选择,用于备战美赛。

编辑于2022-02-03 19:08:30- 数学建模

- 相似推荐

- 大纲

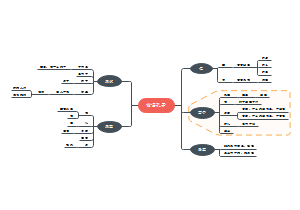

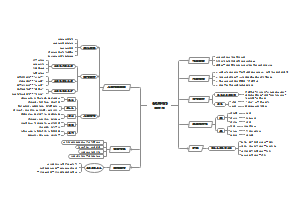

预测、分类、聚类模型

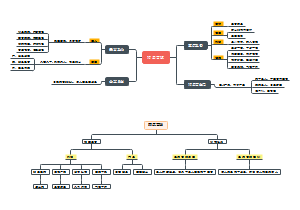

分类模型

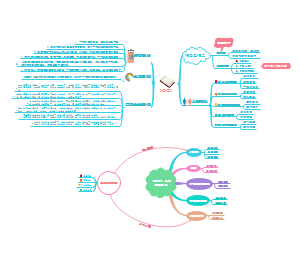

线性可分模型

逻辑斯特回归(分类)

线性回归架构

真正的回归(拟合曲线)

步骤

画散点图,大体判断曲线类型

确定回归模型的类型

逻辑斯蒂

对数函数

对比两种回归模型哪个适合

Logistic原理

一种广义的线性回归模型

是一种线性的二分类算法

逻辑斯特架构

相比线性回归,多了一个sigmoid函数,从而实现分类

损失函数

训练过程

采用最大似然估计才得到最优的参数w,b

最大似然估计

模型使用前提

不必在意特征间相关性

样本线性可分

可以用一个线性函数把两类样本分开,比如二维空间中的直线、三维空间中的平面以及高维空间中的线性函数

参考文献

如何(高效)判断数据是否线性可分

https://blog.csdn.net/u013300875/article/details/44081067

模型评价

优点

实现非常容易,训练非常高效

缺点

容易欠拟合,分类精度不高

解决欠拟合的方法

增加数据量(万能办法)

减少特征

正则化

特征有缺失或特征空间很大则效果很不好

参考文献

https://www.cda.cn/view/200690.html

https://zhuanlan.zhihu.com/p/54197906

感知机模型

模型介绍

二分类的线性分类模型

感知机模型:f(x)=sign(wx+b)

模型训练

(1) 选择初始值w0,b0

(2) 在训练集中选取数据(xi,yi)

(3) 如果yi(w*xi+b)<=0

(4) 求偏导,更新参数

(5) 重复(2)直到训练集中没有误分类点

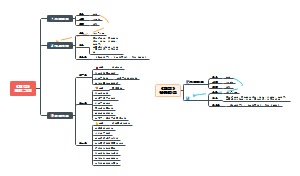

决策树

构造决策树

特征选择

根据信息增益准则进行特征选择的方法是:对训练数据集D,计算其每个特征的信息增益,并比它们的大小

决策树生成

ID3算法

选择信息增益最大的特征作为结点,不断递归进行构建决策树

讲的是这种方法

C4.5算法

使用信息增益比来进行特征选择

决策树剪枝

目的

避免过拟合

先剪枝

当信息增益达到预先设定的阈值时,就不再分裂,取叶子节点中出现频率最多的类别作为类标签

这一种用的比较多

后剪枝

先创建完整的决策树,然后再尝试消除多余的节点

先减去,测试决策树的准确度,如果减去后精度更高,则减去

参考文献

https://blog.csdn.net/u012328159/article/details/79285214

决策树(decision tree)(二)——剪枝

参考文献

决策树算法的Python实现

https://zhuanlan.zhihu.com/p/20794583

模型评价

优点

可以直接处理非数值型数据

以树的形式可视化展示

缺点

对于数值型数据处理不好

随机森林

模型用途

进行特征的重要性度量

参考文献

理论解释

https://blog.csdn.net/weixin_33178459/article/details/112894613?spm=1001.2101.3001.4242.1&utm_relevant_index=3

代码

https://blog.csdn.net/xiezhen_zheng/article/details/82011908?spm=1001.2101.3001.4242.1&utm_relevant_index=3

数据维度相对低(几十维),同时对准确性有较高要求时,基本上不知道用什么方法的时候都可以先试一下随机森林

模型评价

优点

集成算法,准确性高

两个随机性的引入,不容易陷入过拟合

缺点

可解释性较差,算是黑盒模型

参考文献

大致描述

https://blog.csdn.net/weixin_43178406/article/details/86653527?spm=1000.2123.3001.4430

BP神经网络

模型训练过程

向前传播输入

输入样本--输入层--各隐层--输出层

向后传播误差

从输出层,经由各隐层,到第一个隐藏层逐层传播误差-更新网络权重及偏倚

模型结构

在数学建模的模型描述中只要给出你的结构即可

审稿人不喜欢神经网络,因为不直观

慎重选择

模型在论文中的表达

将网络结构和学习率等参数进行了介绍

实验数据的组成

数据维度越高,随机森林越强 数据量越大,神经网络就越强

朴素贝叶斯算法

理论基础

朴素贝叶斯给出一个较强的条件独立性假设

分类过程

朴素贝叶斯法分类时,假设输入变量都是条件独立的,通过在训练数据上学习得到模型,计算出每个类别的先验概率和条件概率,依照模型计算后验概率,将后验概率最大的类作为输入变量所属的类输出。

模型评价

优点

算法逻辑简单,易于实现

缺点

在属性个数比较多或者属性之间相关性较大时,分类效果不好

参考文献

带你理解朴素贝叶斯分类算法

https://zhuanlan.zhihu.com/p/26262151

分类模型的评价指标

准确率

错误率

特效性

灵敏性

ROC曲线

用构图法揭示灵敏度和特效性的相互关系

AUC

ROC曲线下的面积

AUC = 1,是完美分类器

0.5 < AUC < 1,优于随机猜测

AUC = 0.5,跟随机猜测一样

AUC < 0.5

就考虑另一种可能就大于0.5了

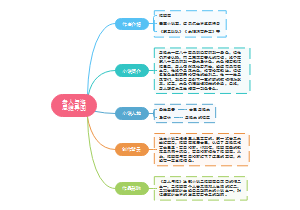

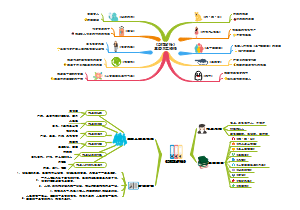

预测模型

回归分析

模型用途

找到变量之间的关系式

根据某几个变量,进行预测另一个变量值

评价模型指标

三个误差指标

离差

实际值与平均值之差

回归差

估计值与平均值之差

残差

实际值与估计值之差

离差=回归差+残差

三个概念

总平方和TSS

n个观察值与其均值的误差总和

回归平方和ESS

残差平方和RSS

实际值与拟合值之间的差异程度

拟合优度

R^2越接近于1,说明回归曲线拟合度越好

回归分析的步骤

确定变量

寻找与预测目标的相关影响因素

建立回归模型

步骤

画散点图,大体判断曲线类型

确定回归模型的类型

逻辑斯蒂

对数函数

对比两种回归模型哪个适合

计算预测误差

检验模型

确定预测值

利用回归预测模型计算预测值

软件工具

SPSS

参考文献

https://www.bilibili.com/video/BV16y4y1h7uM?share_source=copy_web

种类

因变量为连续变量

线性回归

因变量为分类变量

logistic回归

因变量为计数变量

泊松回归

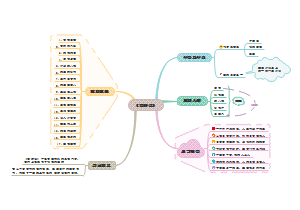

聚类

Kmeans聚类算法

聚类算法

模型介绍

聚类主要根据数据之间的相似度(距离或者相似性系数)进行分类

通过欧几里得距离和余弦相似度进行测量距离

K是提前设定的,表示分几类

模型用途

数据预处理

多维数据进行聚类分析,从而简化

对文字进行聚类

参考文献

https://zhuanlan.zhihu.com/p/28044899

数据分析

分类

K-means聚类

层次聚类

Q型聚类

R型聚类

步骤

得到两两距离

求出距离矩阵

生成树形结构

K-means聚类算法

算法流程

1. 确定k值

即确定多少个集合

2. 从数据集中随机选取k个点作为质心,有k个质心

3. 对数据集中每一个点,计算其与每一个质心的距离(如欧式距离),离哪个质心近,就划分到那个质心所属的集合

两点距离有不同的定义,最常见的就是欧式距离

离散变量

4. 一次聚类后,再重新计算质心

5. 如果新计算出来的质心和原来的质心之间的距离小于某一个设置的阈值(变化不大),算法终止

6. 如果新质心和原质心距离变化很大,需要迭代3~5步骤。

不同类型变量的处理

二元变量

则对变量进行0-1赋值

建立列联表,用杰卡德距离进行计算

分类变量

将分类变量二值化

转化为二元变量后再列联表分析

有序变量

对变量根据大小对应赋值

对赋的值进行z-score标准化

z-score参考文献

https://blog.csdn.net/weixin_38706928/article/details/80329563?spm=1001.2101.3001.6661.1&utm_medium=distribute.pc_relevant_t0.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-1.pc_relevant_aa&depth_1-utm_source=distribute.pc_relevant_t0.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-1.pc_relevant_aa&utm_relevant_index=1

模型评价

优点

原理简单,收敛速度快

调参的时候只需要改变k一个参数

缺点

很难确定K的取值

对异常值敏感

结果可能只是局部最优而不是全局最优

特征选择

好处

提高预测准确度

降低过拟合的风险

增加模型可解释性

连续变量处理方法

I. 计算自变量之间和自变量与因变量的相关性

自变量之间相关性强,则只要一个与因变量相关性高的自变量即可

II. 递归消除法

不断去除不重要的特征、检验性能,直到得到性能最高的

III. 正则化

不重要的特征相关性系数会变成0

离散变量处理方法

I. 计算缺失值的比重进行判断

II. 通过随机森林算法对特征值重要性进行计算,来进行特征的筛选

参考文献

https://www.cda.cn/view/200690.html