导图社区 《数据要素价值发挥的探索与实践》读书笔记

- 105

- 0

- 0

- 举报

《数据要素价值发挥的探索与实践》读书笔记

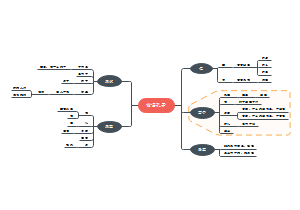

这是一篇关于《数据要素价值发挥的探索与实践》读书笔记的思维导图,主要内容包括:参考文献,第三部分 数据要素价值发挥的实践,第二部分 数据要素价值发挥的理论与技术,第一部分 数据要素基本理论和价值发挥难点,前言,序。

编辑于2025-02-02 15:44:23- 数据

- 数据要素

- 相似推荐

- 大纲

《数据要素价值发挥的探索与实践》读书笔记

序

50000年前,人类发明语言,提高表达及交流信息的效率; 5000年前,人类发明文字,开启知识存储传递的文明之旅; 1000年前,人类发明印刷术,推动知识复制登上新的台阶; 1946年,电子计算机诞生,数据随着信息技术的发展与扩张而迅速发展。

如今,数据逐步成为一种新的基础性和战略性生产要素。数据生产要素的运用是优化经济结构的重要推动力,经济社会发展正在经历一场全面性的变革。数据生产要素将成为这场变革的主要动力来原,催生了继农业经济、工业经济之后一种新的经济社会发展形态--“数字经济”。数字经济与实体经济持续深度融合,已经对社会治理、经济运行、生产生活等带来了巨大的影响,人类社会进入了数据生产力时代。

2019年10月31日,党的十九届四中全会通过的《中共中央关于坚持和完善中国特色社会主义制度推进国家治理体系和治理能力现代化若干重大问题的决定》,正式把数据列入生产要素,与土地、劳动、资本、技术等传统生产要素并列,这也拉开了我国以数据作为生产要素的数字经济发展新序幕。

将数据列为生产要素在全球是首创,既是理论上的重大创新,也是技术发展,尤其是数字技术发展的必然趋势。数据作为生产要素,还需要更多的理论探索和相关实践。

2023年以来,我国明显加快了将数据作为生产要素的推进步伐,与数据生产要素相关的各种政策规划纷纷出台,数据资产管理等一系列相关措施纷纷落地。国家及地方数据局成立、各地数据交易所和数据集团组建、不同地区关于数据要素重大会议的隆重召开,无一不在说明,数据作为生产要素,在我国已经进入到了实操和落地阶段。

数据作为生产要素,有着完全不同于传统生产要素的属性:数据既具有一般商品所包含的价值、交换价值和使用价值,又具有一般商品所不具备的非消耗、非排他、零边际成本等独特属性。这些独特属性带来了数据在确权、定价、流通交易和价值发挥等方面完全不同于已有生产要素的表达方式。当前,对数据作为生产要素本身的理解和认知还处在初级阶段,数据要素价值发挥的逻辑,也还处在早期探索阶段。

数据作为生产要素,就必然要参与生产和分配。这涉及数据本身的确权、流通、交易等一系列环节。但数据自身的独特属性,使得数据相关政策制度、市场建设、安全保障等方面存在一些难点。为了解决这些难点,构建数据价值发挥的路径,国家正在规划数据基础设施,支撑数据汇聚、处理、流通、应用、运营、安全保障能力建设,打通数据流通使用的堵点难点,确保数据“供得出”“流得动”“用得好”,充分挖掘数据要素潜能。

数据要素价值发挥才刚刚起步,道路漫长且曲折,我们将围绕国家数据要素战略,与合作伙伴共同探讨与实践,尤其是利用可信数据空间技术,围绕数据要素乘数效应,支撑数据运营体系,进一步推动和促进数据作为生产要素在采集汇聚、共享开发、授权运营、流通交易和开发利用等环节的价值发挥。数据要素价值发挥领域百家争鸣,我们将继续汲取国内外优秀经验,进一步在数据要素价值发挥的道路上继续探索与实践,服务国家经济高质量发展大局,为数据要素价值发挥做出更大的贡献。

本书涉足部分领域尚未形成统一共识,且编写过程仓促,错误在所难免,敬请读者朋友们交流和指正!本书是对数据要素价值发挥摸索过程的思考与总结,并记录了探索与实践过程的路径,还些不一定适用于所有数据价值发挥的场景。同时,我们探索的路径也只是万千路径中的一条。因此,在阅读本书的过程中,请读者以一种审视的态度,共同探讨数据要素价值发挥的路径到底应该是怎样的?如何抓住这个历史机遇?数据要素与信息时代、数字经济时代、大模型时代共振,定是那片寻觅的新蓝海。 谭林 2024 年4 月6 日于长沙

前言

数据作为生产要素,通过与传统生产要素结合,在实体经济中发挥数据乘数效应。数据作为一种生产要素,由其自身的特殊性,以及价值发挥面临的难点突出,亟需提高数据要素与其他要素的协同效率,实现全局优化,复用数据扩展生产可能性边界,融合数据价值,推动量变到质变。

然而,数据要素价值发挥遇到“供不出”“流不动”“用不好”“不安全”等问题,导致数据价值发挥受阻。作者认为,数据价值发挥需要从机制、体系、技术、市场等多方面共同发力,才能形成有效数据大市场。当市场上有足够的可用数据供给,通过市场培育,就会形成数据生态,并在各行各业渗透,从而提升行业效率,实现数据要素“乘数”效应。例如,

在工业领域,通过数据流通可以提升供应链效率和韧性;

在农业领域,通过市场价格数据指导精准农业生产规划;

在医疗领域,通过电子病历数据共享提升就医便捷度。

本书基于国家相关政策背景,结合团队多年研究成果和一线亲身实践探索经验,凝练出对数据要素价值发挥的政策和技术的思考,以及与众多优秀合作伙伴在数据要素价值化领域的探索与实践成果。

本书分析了数据要素相关政策背景,阐述了数据要素价值发挥的理论和技术基础,并通过可信数据空间实现对数据流通和数据安全技术的融合,并内置一套数据安全流通机制和数据市场交付体系,支撑数据要素安全流通。

可信数据空间作为数据要素价值发挥的重要抓手,通过在不同行业进行实践探索,已摸索出一套可行的数据要素流通解决方案。

可信数据空间

为了构建理想化的数据价值发挥的路径,作者不断思考、探索与实践,从政策制度分析、技术理解与攻关、产品设计、行业经验探索与实践,逐渐摸索出一条数据要素价值化的可行路径。随着国家对数据基础设施的定义越来越清晰,作者发现,在数据要素价值化的探索道路上,在路径、形式上是何其相似。

早在2017年,区块链火遍全球,那个时候,数据主权价值不断被提及,先驱们期望通过区块链智能合约来实现公平的数据价值化路径。然而,那时数据相关的要素和技术都还不够成熟,无法支撑数据价值发挥。2019年10月,党的十九届四中全会首次将数据确立为一种生产要素。那时,数据要素相关的制度还没有制定,《数据安全法》等相关法律还没有出台,只有相关的技术还在黑暗中探索前行。站在2024年4月这个历史点上,数据要素价值发挥似乎是处在一个最好的时代。2023年1O月25日国家数据局正式挂牌,2024年1月4日国家数据局等17部门联合印发《“数据要素x”三年行动计划(2024-2026年)》,2024年4月1日,2024年全国数据工作会议在北京召开,会议指出:我国将多措并举推进数据要素市场化配置改革,数据要素价值发挥迎来最好的时代。

国家正在规划数据基础设施,支撑数据汇聚、处理、流通、应用、运营、安全保障全流程,打通数据流通使用的堵点难点,充分挖掘数据要素潜能。本书也是围绕这样一条主线,探索数据要素价值发挥的路径。作者通过将网络、算力、流通和安全数据基础设施融合,重点基于数据流通和安全设施,打造可信数据空间,并构建数据汇聚、处理、流通、应用、运营、安全保障能力支撑数据要素价值发挥。

可信数据空间作为一种承载数据主权,支撑数据采集汇聚、共享开发、授权运营、流通交易和开发利用的载体,为数据要素价值发挥提供了较好载体。本书围绕数据要素价值发挥的逻辑,探讨了数据要素基本理论和价值发挥难点、数据要素价值发挥的理论与技术和数据要素价值发挥的实践。全书通过可信数据空间的各项能力进行展开,并在实践当中探索可信数据空间在数据要素价值发挥的作用。

读者对象

对于在数据要素领域的工作者,通过阅读本书,可以了解数据要素价值发挥的路径,相关的技术、产品,以及在工业、农业、医疗、文化等场景中的应用案例。

对于希望了解数据要素价值化发挥的相关技术的读者,通过本书可以从数据价值化角度快速了解它们。

对于在不同行业工作的信息化工作者,可以通过本书了解数据要素价值变现的一种思路。

对于在大学研究、学习数据要素领域的师生,通过本书,可以了解数据要素价值发挥的技术、思路和产业路径。

本书特色

本书从数据要素价值发挥角度,从政策、理论、技术和实践四个维度进行编写,浅显易懂,从数据要素概念、技术路线、产品思路、解决方案全面覆盖,可作为数据要素领域的入门书、参考书。

致谢

本书由谭林博士组织并牵头编写,成立编委会,确定了本书的提纲和目录,完成了对各章节内容和质量的把控,以及做了最后的通稿校稿工作。具体主责分工如下:宋霞(第一章)、谭林(第二章、第三章)、尹海波(第四章、第十一章)、郭兆中(第五章)、储超尘(第六章)、刘齐军(第七章)、孙杰(第八章)、聂璐璐(第九章)、杨腕婷(第十章)、孔曼(第十二章)、吴文兵(第十三章)、姜载乐(第十四章)。感谢杨腕婷对本书出版的组织工作,感谢李洪、谭羡对本书封面和装帧设计工作,感谢编委会所有成员及其家庭成员为本书做出的巨大贡献。高承实博士对全书的编写给予了大量的指导和帮助,特此感谢。

特别感谢湖南省数据局、长沙市数据资源局、湖南股权交易所等政府机构单位领导对本书相关业务指导;特别感谢我们的合作伙伴,包括中国铁建重工集团股份有限公司、湖南镭目科技有限公司、湖南金龙智造科技股份有限公司、源品细胞生物科技集团有限公司、湖南惠农科技有限公司、湖南新五丰股份有限公司、土流集团有限公司、湖南天河文链科技有限公司等在业务方面的指导和支持。特别感谢湘江实验室重大项目(区块链高性能跨链互通与数据协同,23XJ02007)对本书的支持。

本书写作过程得到诸多领导、老师、同事、朋友的指正,湖南科学技术出版社团队在本书出版过程中给予指导,并付出艰辛的劳动,在此一并感谢。

第一部分 数据要素基本理论和价值发挥难点

第一章 数据要素概述

2019年10月31日,党的十九届四中全会通过的《中共中央关于坚持和完善中国特色社会主义制度、推进国家治理体系和治理能力现代化若干重大问题的决定》,正式把数据列入生产要索,与土地、劳动、资本、技术等传统生产要素并列。

1.1 数据成为生产要素的必然性

2021年,我国颁布的《中华人民共和国数据安全法》,从法律意义上明确了数据的定义,即“任何以电子或者其他方式对信息的记录”。

1.1.1 数据作为生产要素的定义

数据生产要素简称数据要素,即“那些以电子形式存存的、通过计算的方式参与到生产经营活动并发挥重要价值的资源。”

生产要素是用来创造和生产商品或服务的资源,是价值创造的必要条件,也是经济发展的基石。生产要素和原材料的区别在于,生产要素是社会化大生产之必需,却不能在最终的生产成品中被直接看到。

数据要素和数据紧密相连,但又存在本质区别。应该说,数据要素来源于数据,但不是所有的数据天然就是数据要素。

数据要成为数据要素需要具备两大必要条件。

一是把原始数据加工成机器可读的,具备投入生产和使用的条件。比如纸质文档记录的数据资源虽然承载着信息,但因为它不能被计算机读取,因此它只是数据,而不是数据要素。

二是数据要可以通过流通进入社会化大生产,就像其他要素那样可以通过社会化进行配置和使用。不能在社会化范围内广泛流通的数据,无论体被多么庞大,都是手工作坊似的自有资源,不是生产要素。

因此,具备“机读”+“流通”条件的数据才有可能成为数据要素。

数据和数据要素的区别可简单类比为钱和资本的区别。在货币经济时代,几乎每个人手里都有一定的“钱”,这个“钱”可以买东西,但这并不意味着每个人都拥有资本。资本是用于投资以期得到利润的钱,其本质是获利。因此,“钱”不等于资本,只有投入生产经营、可以产生经济效益的钱才是资本。

1.1.2 数据成为生产要素的必然性

在生产发展的每个阶段都会有一种生产要素,在当时的生产力条件和水平下是最重要的,作用也是最突出的,这就是关键生产要素。

土地成为农业社会的关键生产要素

资本成为工业化社会的关键生产要素

数据成为数字经济时代的关键生产要素

1.1.3 数据作为生产要素的前景

在经济学中,生产要素是指社会生产经营活动所需要的各种基本资源。这些资源可以进行市场交换, 形成各种生产要素价格与交换体系,并由此形成要素市场。在不同的经济形态下,生产要素的构成是不断演进的,作用发挥机理也不尽相同。

长期来看,数据将大规模地渗透进社会生产、分配、交换和消费的各个环节,成为推动全球经济新一轮增长的重要引擎。因为数据重建了人类对客观世界的理解、预测和控制的新体系和新模式。在这种新体系和新模式下,数据成为对物理世界进行描述、原因分析和结果预测, 以及决策的重要抓手,数据驱动的决策替代了传统的经验决策。

数据已经参与到我国国民经济的所有运行环节。数字经济不仅是对海量的数据进行处理分析,还需要数据与各个行业结合,并对数据进行有效利用,从而提高全要素生产率。在我国国民经济发展中,数据担当着推动质量变革、效率提升和动力转换的角色,数据对生产效率的提升将发挥乘数作用,数据应用的深化对国民经济各部门的发展也具有广泛的辐射和带动效应。

据统计,美国过去十余年的劳动生产率增长中,数字化的贡献度超过40%。相比传统生产要素,数据是生产力发展的倍增器,是社会进步的杠杆,数据对经济效率的提升和经济规模的增长有更大的溢出效应。

数据的乘数作用主要体现在以下三个方面。

一是效率倍增。

数据分别融入劳动、土地、资本、技术等生产要素当中,实现数据与其他生产要素的高效融合,产生多样的化学反应,进而实现生产效率倍增。

例如,数据作为金融产业内容表达、信号传导和资金投向决策依据,快速实现货币、资本、金副的有机转化和相互融合,实现金融产业整体效率的提升,催生了更高效率的现代数字化金融运行体系。

此外,数据与其他要素的深度融合,也不断催生出金融科技等新型资本、智能机器人等“新型劳动力”,持续释放出创新活力。

二是资源优化。

数据不仅可以与劳动、资本、技术等其他单一生产要素融合并带来倍增效应,数据还能够优化劳动、资本、技术、土地这些传统要素自身的配置效率。

例如,工业企业和金融机构间流通共享的数据,就为中小企业低成本融资提供了基于数据的信用评价手段;数据在劳动力供需市场的有效流转,就通过精准招聘优化了劳动力配置; 商业和工业企业利用数据进行物流优化,驱动工业4.0和智能化制造的发展,可以大大提高经济效率。

OECD发布的《数据和数据流动的映射方法》指出,数据的利用有助于产品、流程和组织的改善和创新,能够促进企业劳动生产率增长5%~1O%。

三是投入替代。

利用数据可以实现用更少的资源创造出更多的物质产品和服务,从而形成新的生产方式对传统生产要素投入的替代。

波士顿咨询(Boston Consulting)估计,移动支付对传统ATM机和营业场的替代,在过去1O年至少为中国节省了1万亿元线下支付基础设施建设费用;电子商务减少了对传统商业基础设施的大规模需求和投入;政务服务“最多跑一次”等基础设施减少了人力和其他资源消耗。这些都是通过使用数据,用更少的资源投入创造了更高价值的体现。

1.2 数据作为生产要素的独特性

数据虽然与土地、劳动、资本、技术并列为生产要素,但数据有着完全不同于土地、劳动、资本和技术等生产要素的特殊属性。数据虽然也具有一般商品所包含的价值、交换价值和使用价值,但数据又具有一般商品所不具备的非消耗性、非排他性、边际复制成本为零等特性。而这些传统生产要素所不具备的特殊属性,就带来了数据在确权、定价、流转、流通以及价值发挥方面完全不同于已有生产要素的表达方式。

1.2.1 数据在使用上的非消耗性

数据的非消耗性指的是数据在使用过程中不会被消耗,可以重复使用。这种特性使得数据成为一种可再生的资源,可以在不同的场合和环境下被反复使用。数据的非消耗性是数据区别于资本、劳动、土地等传统生产要素的重要特点之一。与传统资产(如机器、建筑物、自然资源)会自然地衰减或耗尽不同,数据在使用过程中不会发生物理性损耗,甚至在使用过程中还可能会产生新的数据,增加数据的总体规模。

数据与数据还会持续不断地进行融合。数据与其他数据相结合使用时能够挖掘的有效信息更多,数据的价值也会相应增加。

例如,一个公司在进行市场分析时,可以使用同一个数据集进行多次分析,而不需要每次都重新收集和处理数据,同时分析的结果会成为更高价值的数据。数据的非消耗性也使得数据可以被更有效地共享和交换。

然而,数据的非消耗性并不意味着数据是无限制的,因为数据的获取、存储和处理也都需要其他资源的支撑,这些资源是有限的。但相对于数据所能发挥的作用,这点资源上的投入还是微不足道的,尤其随着硬件基础设施性价比的进一步提升,投入相应的资源开展数据资源的采集、存储和处理是完全值得的。

1.2.2 数据占有上的非排他性

数据的非排他性指的是一旦数据生成并被采集,任何人都可以复制和使用这些数据,而这个数据的复制和使用并不会影响其他人对该数据的复制和使用。与传统要素不同,数据无法被特定的人或组织所独占或垄断,相反,任何人都可以通过复制和使用该数据获得利益。这种非排他性特点也带来了数据的可共享性,人们可以更容易地分享和利用数据,从而推动数据的更广泛应用和价值发挥。

数据的非排他性也带来了一些问题和挑战。

例如,大量数据汇集带来的个人隐私泄露问题,海量数据带来的非传统安全问题,个人隐私保护和企业利益之间的平衡问题,数据被恶意使用问题等。

在数据的占有和使用方面,需要建立相应的法律和伦理规范,保障数据的合法使用,实现相应的权益保护。

1.2.3 数据的零边际复制成本

数据可以通过数字化技术和设备实现无限复制,而且复制过程中不会产生额外的物质消耗。这种零边际复制成本是数据在所有生产要素中独有的优势。数据规模和种类的增加,可以产生更多的信息和知识,而且这些信息和知识的复制成本几乎为零。这意味着数据可以以极低成本甚至是无成本的方式被广泛地共享和使用,从而带来规模经济,产生倍增效应。

数据的零边际复制成本并不意味着数据就可以被无限制地复制和分发。实际上,数据的使用和分发也需要遵守相关的法律和规定,例如关于数据隐私和安全的规定。同时,数据的使用和分发也需要消秏一定的计算和存储资源,而这些资源也是有限的。因此,我们就更需要合理地管理和使用数据,以在确保安全和隐私的情况下,确保数据带来价值增值和效率提升。

1.3 数据作为生产要素价值发挥的主要方式

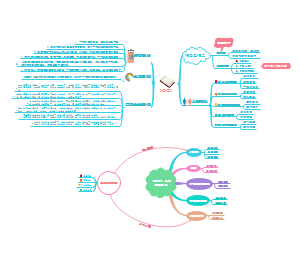

数据作为生产要素的价值表达,主要包括数据资源化、数据资产化和数据资本化三种方式。

数据资源、数据资产和数据资本概念

1.3.1 数据资源化

数字经济的核心驱动力量是数据。数据的价值在于依托数据数量、数据质量和内核知识蕴含的价值生成的数据脉象价值和数据脉动价值。资源是某主体拥有的人力、物力、财力等各种要素的总称,数据资源特指数据以资源的方式作为生产要素投入生产,数据资源化则强调数据资源整合后形成的数据价值。

(1)数据资源概念

数据资源、数据资产和数据资本都是数据发展到一定规模、集聚一定价值后的产物,在概念上有本质区别。21世纪人类的一大文明进步就是进发出了“数据是一种资源”的思想,正是基于这种思想基调,人类大胆赋予数据具有实物资产一样的权属,使得数据拥有了跟石油、煤矿、土地等重要资源一样的资产特性,可买卖交易、可获利、可支撑生产。

数据资源集聚了数据的原始价值,成为需要挖掘和探索的蓝海,需要科学有效的数据价值生成方法。既然数据可以像房屋一样隶属千某个主体成为资产,那么数据也可以像房屋通过抵押获得贷款一样获得资本属性,通过数据资源化、数据资产化、数据资本化表达其数据价值。

(2)数据资源管理

数据资源作为数据生产要素的一种表现方式,需要相应的市场交易环境,需要建立有效的数据资源管理体系。数据资源管理不仅关注数据资源自身的特点和属性,更关注通过数据资源的有效使用为数据所有者、数据经营者和数据使用者带来数据价值。数据资源管理包括数据成本管理和数据收益管理两个大的方面。

数据资源管理包含了数据标准、数据质量、数据安全、数据价值、数据共享和数据挖掘等更微观的管理内容,以及如何针对不同的应用场景和大数据平台提高数据资源价值增值能力。数据资源的有效管理和价值发挥,需要更专业的管理队伍和更细致的管理制度来确保管理流程的合规性、数据内容的安全性和数据价值的有效性。

(3)数据资源主体

原始数据散落在社会网络中,经数据采集、数据加工等环节后获得数据所有者属性。数据转化为数据资源后开始有了交易属性,由此需要明晰数据资源主体的责权利关系。由于数据隐私性的存在,数据所有者不能简单地让渡数据所有权,必须在数据资源化过程中明晰数据所有者、数据经营者和数据使用者三方主体和权属关系。

数据资源主体和权属

数据所有者完整占有数据资源的所有权,可以自由决定是否将数据资源所有权委托给数据资源经营者。数据资源经营者接受数据所有者委托,享有数据经营权和获取合法收益的权利。数据使用者依据数据经营者赋予的权益享有数据资源使用权,通过使用数据资源获取其价值及其衍生产品价值的权力,从而实现数据价值传递和数据价值变现。

(4)数据资源化发展过程

按照管理成熟度模型可以将数据资源化的发展过程划分为从数据建仓、数据治理、数据应用到数据运营的四个阶段,随着数据资源管理成熟度的提高,数据也从最初的资源化逐渐发展进入到规模化运营阶段。

数据资源化发展过程

数据仓库是在数据资源管理目标驱动下,为了增强数据资源集聚、存储和管理能力而建立的。数据仓库的建立过程非常缓慢。之后随着数据资源的进一步集聚,数据资源化也从最初的数据建仓阶段发展进入到了数据治理阶段,数据采集、计算、加工、分析等配套工具得以被发明出来,并且建立了元数据管理、数据共享、数据安全保护等管理机制。数据治理的迅速发展推动着数据资源化进入到数据应用阶段。数据应用的进一步发展和创新,就使得数据资源化进入到了大规模数据资源运营阶段。

数据资源化不仅是数据产品和数据服务创新能力的前提,而且有助于实现数据资源价值最大化目标。随着数据资源管理成熟度和数据资源管理能力的提高,数据资源化发展动能不断提升,这同时也推动着数据资源价值增值能力的快速提升。

1.3.2 数据资产化

数据资产化不仅有助于提升数据价值,增加数据变现途径,增加数据作为生产要素流通的灵活性,而且能够赋予数据更多金融属性,使数据可以演化成为无形资产。

(1)数据资产概念

数据资产目前尚无统一定义,会计学科强调数据资产的资产特性,经济学科强调其产权、收益权归属等。《数据资产管理白皮书(4.0)》将数据资产定义为:“由企业拥有或控制的,能够为企业带来未来经济利益的,以物理或电子的方式记录的数据资源,如文件资料、电子数据等。”

数据资产定义为拥有数据权属(勘探权、使用权、所有权)、有价值、可计量、可读取的网络空间中的数据集。该定义明确强调了数据具备的可获得经济利益的特征,也说明了数据资产应当具备可估量的价值,但没有触及数据资产的核心本质内容。近几年,分布式存储、云计算、人工智能、区块链等技术的发展和应用正不断为数据资产概念的落地和数据资产化过程提供支撑,在相关技术的支撑下,非结构化数据也被纳入数据资产范畴,如海量的标签库、企业级知识图谱、文库文档、视频、图片等。

(2)与数字资产区别

数字时代,数字资产和数据资产是两个经常被提及的概念。虽然它们都是数字经济时代的资产,但数字资产与数据资产有着明显的区别。

数字资产泛指所有以数字形式存在并可在互联网上交易转移的虚拟资产,包括加密货币、区块链代币、数字艺术品、虚拟房地产等。它们的本质是一串代码或数字凭证,代表着所有权和价值,可在区块链等分布式账本上进行点对点转移和流通。它们与数据资产需要通过对数据的挖掘、分析和利用,为企业带来经营优化、市场洞察、新业务机会等产生价值不同,数字资产本身就蕴含直接的货币价值或所有权价值,可在互联网上像实物资产一样交易流通,它们的价值很大程度上取决于市场供需和投资者预期。

(3)数据产品资产性

一般来说,作为产品参与交易的数据集或其衍生出来的信息服务被称为数据产品, 而数据产品是企业实现“对外交易数据资源资产化”的重要路径。在数据要素市场中, 可供交易的数据产品具有较为显著的资产专用性,需满足来源权威、合规性、可溯性、应用场景明确等质量要求。在此过程中,数据价值不断被创造、挖掘和释放。

数据产品是经过创造性劳动和实质性处理和加上活动所形成,具备资产性并以“商品形态”在市场上买卖和流通的物品,其资产性体现在三个方面。

一是合法合规,数据的主体、来源、生成及内容应当符合相关法律法规。若原始数据涉及授权,需从授权方式、对象、内容、时限等方面进行分析,确认数据授权覆盖全流程。

二是权属清晰,依据“三权分置”逻辑,登记数据资源持有权、数据加工使用权和数据产品经营权的权益主体和占比。

三是预期有经济利益流入,运用技术手段,对数据资产进行可靠计量和评估,为数据产品在数据交易所挂牌、撮合、交易、结算、交付提供依据,使得数据产品以货币或货币等价物的形式完成交换,实现数据相关主体未来预期可持续的经济利益流入。

(4)数据产品商品化

数据产品在满足资产性的基础上,经过商品化变成可交易的数据商品,进入数据交易市场。数据商品作为一般商品,具备马克思在《资本论》中所考察的商品的二重因素--使用价值和价值。同时,数据商品作为数字经济时代下的具体商品形态,一方面不存在物理意义上的形态,产品数量由一到多并不会增加其生产成本,使用也不会造成物理损耗;另一方面,从总体上看,伴随着使用人群的增加,最终形成一定的使用规模,将会给数据商品带来质与量的优化提升。因此,数据商品的非排他性呈现复用性和规模效益的统一。

(5)数据资产管理体系

数据作为一种新型资产,同实物资产一样具有价值,并且能够获得经济收益。但是,如果缺乏有效的管理,数据不但不会带来价值,而且可能会变成负债。为了构建有效的数据资产化模式,数据资产管理体系的建设就显得尤为重要。

数据资产管理贯穿于数据采集、存储、管理、分析和使用等数据的全生命周期过程中,而且进一步延伸到数据采集后的运营管理和数据价值变现等环节。目前,数据资产管理尚处于探索阶段,数据质量问题、数据安全隐患、数据价值评估方法、数据交换流通等内容的管理仍显薄弱。

数据资产管理体系及其挑战

①数据资产权属界定

数据资产权属界定是数据资产化前提。数据权不同于传统物权,物权的重要特征之一是对实物的直接支配,但数据权在数据的全生命周期中有不同的支配主体,某些数据产生时由所有者支配,有些数据产生时便被数据采集人支配(如微博、电商数据、物流数据等),存数据处理阶段被各类数据主体所支配。由于数据所有权可以转移、又作以界定,所以数据资产权属界定应该综合考虑数据所有权、数据经营权和数据使用权不同层面的权属关系。

数据资产权属界定可以简单理解为法律意义上由哪个企业拥有数据、经管数据和使用数据,表现在企业是否有数据购买合同(企业本身产生的数据除外)或者预先获得许可,有无约定数据资产所有权、经营权和使用权。数据资产权属界定需要明确相应的权利和责任,包括谁能够创建、读取、修改、复制、共享或删除等。即使企业对外开放或共享数据,有法律保护下,企业仍没有失去所有权、经营权和使用权。在数据具有可复制性的独特背景下,数据资产权属界定可以保障数据资产安全。

②数据资产价值评估

数据资产价值评估是数据资产管理的基础。在企业中,并非所有的数据都可视作资产,能够成为资产的数据首先是能够为企业产生价值的数据。数据资源转化为数据资产后仍有价值高低、资产优劣的不同。数据资产作为一种复杂的全新资产形态,共价值评估比传统资产价值评估更加困难、更具挑战性。

目前数据资产价值估值方法主要有成本法、收益法和市场法三类。

成本法是基于数据资产的成本构成测算数据资产价格,与数据资产价值的重新获取或建立数据资产所需成本紧密挂钩;

收益法是基于目标数据资产的预期应用场景,通过预期经济效益折现反映数据资产投入使用后的收益能力,预测数据资产的收益情况;

市场法是当市场上具备一定数量可比数据资产的估价对象后,通过相同或相似数据资产的对比和差异因素的调整,反映出目标数据资产市场价值。

③数据资产交易流通

2014年以来,我国出现了一批数据交易半台和数据交易机构,包括贵阳大数据交易所、上海数据交易中心、长江大数据交易中心等。2019年9月正式启动的“人民数据资产服务平台”,成为首个国家级别的大数据开放平台,也是行业内首个集数据合规性审核、数据确权出版、数据流通登记等服务于一体的数据资产平台。

互联网领域从业者也在积极探索新的数据流通机制,为数据资产交易流通提供行业观察、营销支待、舆情分析、引擎推荐等数据服务,并针对不同的行业提出对应的解决方案。这些实践意味着数据行业在建立行业标准、引领行业规范发展方面迈出了新的步伐。这对数据领域资源整合具有重要的意义。

④数据资产安全保障

数据资产管理必须在确保安全的前提下进行。当前数据资产安全不能得到有效保障的主要原因是市场缺乏信任机制,技术服务方、数据所有者、数据交易中介等都可能会私下缓存并对外共享数据,数据使用者不按协议要求私自留存、复制甚至转卖数据的现象也普遍存在。数据活动中非授权数据采集、传输、汇聚活动日益频繁,相应地,个人隐私、商业机密等一系列安全问题也日益突出。

按照国家或相关主管部门要求,通过评估数据资产安全风险, 制定管理制度规范保证数据资产安全,建立良性互动的数据交易生态体系迫在眉睫。面对完全不同于传统资产的数据资产管理特点,亟须建立包括政府、监管机构、社会组织等多方参与的,法律法规和技术标准多要素协同的,覆盖数据资产交易流通全过程和数据全生命周期管理的数据资产管理体系。

1.3.3 数据资本化

在数据成为数字经济时代的核心生产要素以后,数据资本作为另外一种更具创造价值的新型资本的概念也被提出来。在数据资本化以后,传统的市场结构、社会结构也相应面临大幅的调整。

(1)数据资本概念

“数据资本”一词首先出现在统计领域中。1967年,挪威中央统计局的一份工作文件认为数据资本是采集和计算数据的保留存量,在统计文件系统中起关键作用。数据资本如同金融资本、实物资本一样,能够生成新的、有价值的产品和服务,提高数据资本拥有者的预期收益。

在经济学中,数据资本拥有长期价值和后验性,即数据资本只有在使用后才能衡量其意义和价值。同时,数据资本也必然要具有增殖性,即数据资本会进一步增殖。数据资本化是通过数据交易流通将数据资产转变为数据资本的过程,从而在更高层次上实现数据价值。

从数据资源、数据资产到数据资本,逐渐增加的数据价值带来更高的价值预期。如何深入挖掘数据资本价值成为一个新的研究方向。数字技术的迅猛发展正在消除金融资本、实物资本与数据资本之间的鸿沟,巨大的颠覆性创新正在逐步将数据资本带到资本市场的核心位置。

(2)数据资本化生产函数

数字经济时代不仅要求劳动者具备数据分析、数据处理能力,而且要求劳动者能够生产数据资本。从数据到信息、再到知识的过程描述了数字革命的本质,即应用数据生产信息和知识,数据成为价值源。数据资本化需要投入劳动力、技术和数据,从而形成一种新型的生产函数关系。

数据资产形成过程伴随着技术进步,它表现为与数据资本积累相伴的数据处理、数据分析和数据使用能力的提高。数据资产逐渐转化为数据资本,而数据资本化的生产函数也演变为“数据生产力=数据资本+数据劳动力+数据技术进步”。

(3)数据资本化体系架构

在数据资本化生产函数中,数据是资本形成的原料。数据资本的兴起,需要一个全新的体系架构以厘清数据资本的属性。在新型的数据资本化体系架构中,应突出体现数据资本公益性和公有制属性,充分展现数据福利价值属性和价值作用。

①数据资本公益性

数据资本化的目的在于追求数据价值最大化,帮助实现数据资源的更好配置,以最大覆盖范围的公益性解决更多的问题。一方面,数据资本公益性体现了数据劳动正义重构的思想, 不仅坚持按劳分配的数据劳动原则,而且坚持普惠享用的数据共享原则;另一方面,数据资本公益性体现了公益性和营利性兼容的思想,不仅坚持公平、普惠基础上的公益性原则,而且坚持效率、效益基础上的营利性原则。

②数据资本公有制

数据本身并没有制度属性、阶级属性和意识形态,但是数据资本化会赋予数据这些属性,以代表不同的制度、阶级和意识形态。数据资本公有制创造了公平的社会环境,一方面有助于以国家利益遏制垄断,推动数据资本公有制发展,让更多的公民享有数据资产权益;另一方面,数据资本公有制有助于解决数据资本收益分配不公的问题,为每一个利益相关者提供公平、合理地享有数据资本收益的权利和机会。

(4)数据资本化的优势

数据资本化在更高层次上扩展了资本内涵,在数据资本化概念下,数据资源会拓展出更多的业务主体和生产服务领域,给企业生产带来更多指引、更大自主性和更多灵活性。在微观层面,数据资本化为企业生产增加了新的自变量,改变了产品服务的生产内容构成;在宏观层面,数据资本化也增加了国家经济内容的要素构成,对进一步盘活已有资源、活跃市场,增加了新的抓手和工具。

数据资本化正在形成新的生产方式、生活方式和经营方式,并且有助于重构产业结构、颠覆业务模式,提升“全产业链脉动”价值。数据价值载体从数据资源、数据资产到数据资本,拓展了“全产业链脉动”服务价值承载力,将从根本上提高制造业服务化转型发展能力。

第二章 数据作为生产要素的全球进展

数据是新的生产要素,当前已经成为全球性共识,只是各个国家的命名方式不一样而已。各个国家对数据的认识,对数据作为生产要素的理解也有所不同,不同的国家基于各自国家的历史、文化、法律和制度考量,虽然有着大致相同,但在细节上又有着巨大差异的制度安排和做法。

2.1 美欧对数据要素的认识和相关做法

2.1.1 美国数据经纪人制度较为成熟,数据市场政策开放性强

美国数字经济发展水平全球领先,是全球数字经济发展的领头羊,同时也是数字革命的重要发源地。美国率先发展出了人工智能、大数据、云计算等技术,在数据要索市场建设方面具有技术优势,发达的信息产业为其数据要素的发展提供了强大的支撑力量,同时广阔的市场也对数据和数据应用提出了广泛而深入的需求,两者的结合有力地促进了美国数据交易市场的形成和发展。

数据经纪人(Data Broker)是美国数据交易服务的主要参与方和支持方。数据经纪人通过各种渠道采集消费者个人数据,并对采集到的原始数据进行整理,衍生出更多的数据和数据产品,之后出售给与消费者没有直接关系的企业,并提供相关的使用授权许可。数据经纪人制度有效解决了供需双方信任缺失问题,促进了数据的有序流通,提高了市场化数据运用水平。

美国数据经纪人在制度设计和商业模式方面发展较为成熟。

(1)实行注册制对数据经纪人进行监管

在联邦政府层面

美国国会2014年起就针对数据经纪业务提出了多项立法提案,包括《2015年数据经纪商责任与透明度法案》《2019年数据经纪商法案》《2020年数据经纪商问责和透明法案》,这些法案重点在于提升行业透明度和安全性。

在州政府层面

加利福尼亚州民法典规定:数据经纪人每年应在加州总检察长处注册,支付一定的注册费用,并提供指定信息;未按照规定要求注册的数据经纪人应承担民事处罚,并将费用存入消费者隐私基金。

佛蒙特州《数据经纪法》规定:数据经纪人应每年向州务卿注册,注册时需提供基本信息、数据收集做法、个人选择退出政策,以及购买者资格审查情况和安全漏洞信息等,便于相关机构及时掌握州内数据经纪人基本情况,提高行业透明度。

(2)形成了稳定的商业模式

美国积极探索多元数据交易模式,根据主体可分为“消费者- 企业分销”“企业 - 企业集中销售”和“企业 - 企业 - 消费者分销集销混合”三种数据交易模式。

消费者 - 企业分销模式是指个人用户将自己的数据贡献给数据平台,以换取一定数额的商品、货币、服务、积分等对价利益,如个人网、名车志等。

企业 - 企业集中销售模式,以微软的数据平台为代表,数据平台以中间代理人身份为数据的提供方和购买方提供数据交易撮合服务。

企业 - 企业 - 消费者分销集销混合模式是指数据经纪商收集用户个人数据并将其转让、共享给客户。

企业 - 企业 - 消费者分销集销混合模式目前是数据交易市场的主流模式,已经具有了一定的市场规模,形成了庞大的数据经纪产业。

(3)打造丰富多样的数据应用场景

美国政府出台多个战略计划,拨付资金研发升级采集、存储、分析、管理等数据使用与流通关键技术,以提高大数据开发应用水平。美国科学技术委员会也成立“大数据高级指导小组”,负责指导联邦政府整体大数据攻关项目的落实。在美国政府不遗余力的推动和引导下,美国数据应用场景覆盖从消费领域到农业、医疗、教育、政府管理等领域,数据在相关产业中均发挥了重要推动作用。

①农业领域

在农业领域,美国政府从不同来源收集数据,通过对数据的使用和分工,使农业活动安排更为精准,推动了农业环境控制和经营管理水平大幅提升。例如美国某气候企业通过庞大的传感网络系统分析和预测农田的气温、降水、土壤湿度和产量,在此基础上建立模型来预判农民的保险金额和企业需要支付的保费。

②医疗领域

在医疗领域,美国政府通过整合和挖掘医疗大数据,推动个人、医疗机构和研究机构数据共享和流通,建立医疗信息交换共享平台,形成医疗大数据信息库。

③教育领域

在教育领域,美国政府利用日常数据对学生的学习行为、考试分数和职业规划等内容进行统计和分析,进而为美国教育中心教学改革提供决策参考。

④政府管理领域

在政府管理领域,美国政府依靠数据分析来优化政府决策,提高政府管理能力。例如拉斯维加斯开发网络仿真模型用来掌握全市的管网实时动态,以便在事故发生时能够快速响应。

(4)构建完善的数据治理体系

美国不断细化数据经纪人对消费者隐私保护的相关条款,以有效规避信息泄露风险事件的发生。数据经纪人掌握和经手大量个人数据,若不注重数据安全和隐私保护,极容易发生大规模的信息泄露事件。

美国联邦贸易委员会(FTC)曾着重强调:未来数据经纪人不得从其他方出于不法行为目的获取个人信息,还需保障消费者自主选择退出的权利以及数据隐私权。

2023年5月,美国加州参议院对数据经纪人相关条款进行了修订,

一是将数据经纪人注册机构更改为加州隐私保护局(CPPA),并细化了数据经纪人注册信息要求,包括提供收到隐私请求等内容的情况记录、是否收集未成年人个人信息、是否收集精确地理位置信息,以及是否收集生殖与健康信息、合规审计情况和网站的消费者行权途径页面等内容;

二是要求CPPA建立个人信息可删除机制,允许消费者通过单次身份验证,要求数据经纪人及相关服务提供商删除其个人信息;

三是数据经纪人应至少每31天接入一次该删除系统,处理消费者的相关申请。

而且自2028年起,数据经纪人每三年需要向CPPA提交由独立第三方机构完成的审计报告,以证明其履行了删除相关义务,重点保障消费者的删除权。

(5)推行“数据霸权主义”

在对外政策上,与欧洲重视数据隐私保护不同,美国更加强调数据市场的自由开放,在“数字自由主义”理念的指导下,试图设定全球数据治理规则。基于这一理念,美国利用政治、法律优势,实施各类“长臂管辖”政策,反对各种形式的数据流通壁垒,在数据跨境流动、数据存储本地化、源代码开放、市场准入、数字内容审查、数字知识产权、政府数据开放等关键议题上呼吁数据自由交流,推行“数据霸权主义”。

(6)推动数字技术研发创新

美国政府非常注重前沿性研究,在国家战略层面大力推进人工智能、量子信息、先进计算等数字技术研发创新。

一方面,美国政府通过大量的资金投入和项目建设推动技术研发发展。

从2015年起,美国财政部、国防部等机构拨付资金并推出多个项目,开展人工智能、通信网络等相关领域的科研活动。2022年6月,美国参议院投票通过《2022年美国创新和竞争法案》,承诺在5年内投入约2500亿美元,用于芯片、人工智能、量子计算、半导体等关键科技领域的研究。

另一方面,美国通过机构设置和人才培养来推动技术发展。

美国政府成立国家人工智能倡议办公室,专门负责监督和实施国家人工智能战略;同时积极出台相关法案,提高人工智能领域内劳动力供给质量。此外,美国与多个国家签署战略合作协议,就人工智能技术和数字基础设施进行合作。例如, 美国与英国签署人工智能研发合作宣言,促进两国在人工智能发展方面的合作;与希腊签订科技合作协定,在数字基础设施、云技能教育等方面推动两国科技合作;与日本签署《量子合作东京声明》,旨在促进两国量子信息科学和技术的合作。

2.1.2 欧盟数据立法顶层设计,首创数据中介制度

近年来,欧盟与美国在数字经济领域的竞争愈演愈烈。美国互联网企业的迅猛发展和扩张对欧盟数字经济形成了巨大冲击。数字经济早期发展速度较慢,欧盟主要以传统的反垄断方式开展对数字经济领域的治理。伴随着数据技术快速发展以及美国龙头企业给市场带来的巨大冲击,欧盟加大了对数据行业的规范和治理力度,自2016年以来,欧盟就先后以税收或反垄断之名,向苹果、谷歌、亚马逊、高逌等数字科技公司开出巨额罚款。

(1)统一数据管理

为促进欧洲数字经济发展、反击美国互联网巨头过度扩张带来的威胁,欧盟于2015年公布了《欧洲数字单一市场战略》,提出建立单一数字市场的三大支柱,其中第三大支杜为:最大化实现数字经济的增长潜力,推动欧盟范围内的数据资源自由流通。2016年,欧盟委员会进一步启动“欧洲数据自由流动”计划,颁布《通用数据保护条例》(以下简称“GDPR”)以及《非个人数据自由流转条例》,在法律层而对个人数据与非个人数据的流动进行了规范。欧盟已构建起完整的数据流通框架。

为使数据得到最大程度地利用,欧盟于2020年2月发布 《欧盟数据战略》,旨在解决欧盟数据领域中数据供给不足、利用率低等问题,致力于建立欧盟单一数据空间(a single European data space)和统一的数据制度框架,打破各国和各部门因标准规范不同而影响数据发展的局面。

(2)创新数据中介模式

2020年11月,欧盟委员会公们了《数据治理法案》草案,提出了一个基于中立和透明的数据中介模式,作为欧盟数据战略的下一个战略目标。《数机治埋法案》的主要目的在于设立数据共享和再利川的框架与模式,进而让数批实现更高的经济价值。该法案从三个角度对数据共享进行了规制:公共部门持有数据的再利用机制、数据中介服务要求和数据利他主义,对数据中介服务给出了明确的定义与规制要求,明确了数据中介服务的合法性地位,以提高公众对该类机构的信任。该法案于2022年6月23日生效,于2024年9月24日实施。这给了相关监管机构、涉及的企业和主体近两年时间以达到合规要求。

欧盟数据中介服务提供者的服务对象包括个人、企业、公共部门、学术或非营利组织等,旨在促成数据持有者和数据使用者的数据共享,帮助双方在业务、法律、技术等方面建立起直接联系。

基于服务对象的不同,欧盟数据中介服务提供者提供三类服务:

第一类是数据持有者(法人)与潜在数据使用者之间的中介服务;

第二类是受欧盟《一般数据保护条例》管辖的个人数据主体和潜在数据使用者之间的中介服务;

第三类是数据合作社的服务。

(3)统一数据市场治理

为了在全球数字地缘竞争中获得数据主权的独立性,欧盟建立了基于自身规则的数据治理体系。与美国在数据治理上更重视市场自由竞争不同,欧盟的数据治理更强调对人权的保护。

①对外政策

欧盟出台系列战略文件和数据法案,以加强对本土数据的控制权。

一方面,欧盟自2020年起相继发布《塑造欧洲的数字未来》《欧洲数据战略》和《欧洲数字主权》等一系列战略文件,重点关注区域外数据霸权扩张对本地市场竞争的影响。欧盟通过《通用数据保护条例》建立基于个人数据保护的贸易壁垒,欧盟以外的国家只有在符合欧盟认证数据保护标准的情况下,才能跨境流动和使用欧盟数据。自该条例颁布实施以来,欧盟科技企业获得的风险投资大幅下降,每笔交易的平均融资率比上线前12个月下降了33%。

另一方面,欧盟相继通过《数字服务法案》和《数字市场法案》,严格监控数字平台的治理和竞争问题,并重新定义了大型互联网平台企业的权利、义务和责任,以加强对本土数据资源的控制权和数据市场规则的话语权。

②对内治理

欧盟建立跨部门治理框架和欧洲共同数据空间治理立法框架,以加强数据治理。

一方面,欧盟设立数据创新委员会和数据保护委员会,前者以专家组的形式,由所有成员国主管机构的代表,以及欧盟数据保护委员会、欧洲委员会、相关数据空间和特定部门主管机构的代表组成。同时,鉴于数据治理“不可能的三角”,欧盟多年来一直致力于将“公平治理”作为核心理念,捍卫数据主权,同时不断加强对个人数据权利的法律保护。

另一方面,欧盟强调在数据治理领域建立单一市场。为解决各部门和成员国因数据治理程度差异而造成的不同步问题,欧盟试图建立统一的数据治理体系。

(4)积极布局基础设施

在基础设施方面,基于《欧洲数据战略》要求,欧盟持续加大投资,强化欧盟在数字经济方面的技术主权。

一是重点投资具有重大影响力的项目,如开发欧洲公共数据空间和互通互联的云基础设施,以此将不同领域的数据资源整合在一起;

二是在欧盟《通用数据保护条例》等法律法规的基础上,制定“云规则手册”,为欧盟用户构建有竞争力、安全和公平的云服务市场;

三是依托欧盟现有的科研计划,如地平线计划,提高对数据技术的研发资金投入,重点聚焦隐私保护技术、工业和个人数据空间支撑技术;

四是积极布局数据中心和算力中心。

2.1.3 德国率先打造数据空问,建立可信流通休系

在数据要素市场的建设方面,德国前瞻性地做好顶层设计,依托其先进的工业制造体系,在工业数字化转型领域遥遥领先。同时德国出台了一系列市场监管法案。但是,德国在基础设施建设方面发展较为滞后,市场碎片化导致其应用场景较为单一,如何平衡数据监管保护和数据应用是德国数据要素市场发展的一个难题。

(1)加速数据要素巾场形成

自2016年起,德国相继发布多个战略计划,以促进其数据要素市场形成。继“数字议程(2014-2017)”后,德国政府推出“数字战略2025”,首次就数字化发展做出系统安排,在国家战略层面明确德国制造业转型和构建未来数字社会的思路和十个行动计划。随后,德国在2021年发布《联邦政府数据战略》,从加强数据基础设施、创新与负责任地应用数据、提高数据能力并打造数据文化和加强国家数据治理等四个方面发力,旨在充分挖掘数据要素价值,推动德国成为欧洲数据共享和应用的先行者。同年6月,欧盟批准德国总额高达256亿欧元的经济复苏计划,其中一半以上的援助资金被用于数字领域。总的来看通过联邦立法形式,德国既体现了政府对数据要素和数字经济的重视,以及对数据在新形势下的重要价值的重视,同时也对数据要素巾场进行了规范,以扩大高值数据的流通和应用范围,确保公平参与,同时持续打击数据滥用。

(2)积极推动数据流通

德国在全球率先提出“工业数据空间”的概念,希望通过制度确保交易中的数据安全,从而建立一套国际标准,以主导欧洲数据要素市场的建设和发展。德国通过打造工业数据空间来构建行业内安全可信的数据交换途径,排除企业对数据交换不安全的种种担忧,实现各行各业数据的互联互通,形成相对完整的数据流通共享生态。

工业数据空间是一个基于标准化通信接口、确保数据共享安全的虚拟架构,融合了可信认证、数据自主权管理和数据连接器技术解决方案。

工业数据空间为数据要素的市场化确权和定价提供了新思路。工业数据空间的核心是维护数据主体权利,允许用户决定谁拥有访问其专有数据的权利,从而实现对数据的监控和持续控制。目前,德国工业数据空间已经得到包括中国、日本、美国在内的20多个国家,以及118家企业和机构的支持。

(3)较完善的政府数据开放体系日趋形成

德国政府同样制定出台政策和系列措施来促进政府数据开放,鼓励公众参与,提高政府的运行效率。

在政策法规方面,德国政府发布“国家电子政务战略”,重点开放政府数据,同时在多项法规中明确联邦政府及其行政部门必须在符合法律的前提下推动开放数据,强调数据开放义务,明确开放项目、范围和收费等内容,并搭建了政府数据开放平台。

在激励措施方面,德国政府在城市规划、公共建设、财政预算和环境能源等治理内容上积极鼓励公民参与,并形成了一套较为成熟的模式。如巴登-符腾堡州设置公民参与顾问职位,并在各个部门设置联系点,鼓励民众、企业等主体共同参与。从运行情况来看,虽然德国公共数据开放已经发展了一段时间,但目前许多开放政府数据平台仍处于初级阶段,如何有效整合利用数据资源,仍是数据开放需要解决的难点。

(4)多样化场景的数据应用成效日渐凸显

德国数据要素市场应用场景十分丰富,除在优势制造业以外,在农业、公共服务等领域,数据也发挥了不可替代的作用。

作为制造业大国,德国在制造业领域积极采纳新技术,推广新应用。在2013年,德国政府提出了“工业4.0”计划,以发达的工业体系为基础,充分挖掘信息技术的潜力,重视对工业数据的开发和利用。例如,在机车上安装智能传感器,实时捕获机车性能、空调等运行数据,分析各部件的运行状态,识别潜在的安全隐患,用以预测和消除错误,提高操作与维护的质量和效率。数据显示,这一实时分析功能有助于将机车维护成本降低8%~10%。

在农业领域,德国政府投入大量资金,与大企业合作研发“数字农业”技术,主要用于农场管理和使用、畜群管理数字化解决方案与设备研制,以及气候控制和环境等领域。例如,思爱普推出数字农业解决方案,可以实时显示农作物生产信息;德国电信推出数字化奶牛养殖监测技术,对饲养过程进行全流程监测。

数据在新型冠状病毒感染疫情防控等公共服务领域也发挥了巨大作用。一方面,大数据在疫情追溯、防控中的应用极大地降低了疫情带来的负面影响;另一方面,数据应用催生了无数新业态,同时数据以其蕴含的巨大创新潜能、推动了经济社会的转型与变革。因此,德国将数据视为走出疫情影响、加速经济恢复的重要支柱。

(5)推动数据开放共享

欧盟制定出台系列战略,鼓励数据开放共享。《欧洲数据战略》强调从战略层面和公共利益层面打造欧洲共同数据空间,明确建立工业、交通等9个领域的数据空间。

2022年,欧盟通过《数据治理法案》,就公共数据开放共享推出3个方面的举措。

一是建立有利于公共数据利用的机制和环境。例如,建立公共部门数据再利用新机制,允许自然人或法人在公共部门提供的安全处理环境中访问并利用公共部门和机构持有的受保护数据。

二是采取数据利他主义,鼓励企业与公共机构共享数据。例如利用电信数据预测西非的埃博拉疫情。

三是支持个人或企业分享公共数据。当个人或者企业希望共享或捐赠其拥有的数据时,可在其控制的数据空间内自由进行。例如,患有罕见疾病的病人可以自愿分享其医学测试结果,以用于改善对这类疾病的治疗。

(6)数据要素市场主体行为监管日趋严格

德国建立了“法律+制度”两个层面的数据要素市场监管体系。

①法律层面

在法律层面,德国通过立法已经建立了相当全面的数据保护法律法规。

一方面,德国出台系列综合立法,对数据要素市场进行全面监管。例如,德国参照欧盟《通用数据保护条例》制定了《联邦数据保护法》,明确了数据保护规则和框架。

另一方面,德国出台了针对各领域的专业立法,例如,《(反限制竞争法)第十修正案》旨在加强对数字行业巨头的监管;《通信法》和《媒体法》等业内专门法律对通信、媒体等相关领域的数据予以保护。

以《联邦数据保护法》为依据,德国各州基于各自的实际情况也出台了相应的数据保护法案。德国数据监管法律体系日渐成熟。

②制度层面

在制度层面,德国政府在国家层面设立了联邦数据保护专员。联邦数据保护专员只服从法律,接受联邦法律监督,独立行使职权,最大力度地保证了法律的公正性。此外,德国政府内部建立监督专员办公室,联邦各州也均设立数据保护专员,针对本州范围内的数据安全问题进行监管。

2.1.4 英国金融行业先行先试,促进数据的市场交易

脱离欧盟后,英国积极建设本国数据要素市场,制订了新的全球数据战略计划,数据市场规模在欧洲处于领先地位。在对外合作方面,英国与多个国家建立了全球数据合作伙伴关系,签订了新的数据传输协议。在数据治理方面,英国不断完善数据跨境流动治理框架,降低国际数据传输成本,为本国数字经济在脱欧后实现自主良性发展创造了有利条件。在基础设施方面,英国制定出台相关政策,大力推动数据中心等关键领域基础设施建设。

(1)欧洲最大的数据市场规模

2020年英国就已经成为欧洲最大的数据市场。英国数据市场规模约占国内生产总值4%,数字贸易占英国国际服务贸易的最大部分,2019年英国数字贸易出口额就达到了2340亿英镑。数据要素安全有序流通带来的生产力和竞争优势,使英国国内生产总值增长了约278亿英镑。2019年9月,英国政府发布《国家数据战略》,旨在通过数据流通和应用推动经济增长,改善公共服务,使英国成为下一轮数据驱动型创新的领导者。《国家数据战略》为促进经济发展建立了框架。《国家数据战略》承诺到2027年,英国政府对数据研究和开发的投资将增长到国内生产总值的2.4%,建立诸如数据伦理与创新中心和图灵研究所等机构,并就“数据信任”这一新型的数据共享框架开展开创性工作。

(2)政府数据开放极具借鉴意义

英国政府采取多项措施开放数据,使英国在全球数据开放指数中处于领先地位。

①政策制定

在政策制定方面,英国制定出台了《抓住数据机遇:英国数据能力策略》《G8开放数据宪章英国行动计划》《透明度与开放政府》《英国开放政府国家行动计划(2016-2018)》和《英国开放政府国家计划(2019-2021)》等系列文件。系列文件为英国政府数据开放提供了较为深厚的政策基础。

②机构设立

在机构设立方面,英国政府先后成立信息经济委员会和数据战略委员会,以制定和推行英国政府的数据开放战略,并监督政府数据开放工作的实施情况,同时成立公共数据集团和数据开放研究所,负责具体的数据开放业务。

总的来看,英国政府数据开放是国家从制度和架构两方面系统化推进的结果。

(3)开放银行战略价值日渐凸显

作为一个高度重视数据价值的国家,英国在开发和利用金融数据、促进金融数据的贸易和流通方面实施了开放银行战略。该战略通过开放安全的金融市场应用程序接口,向授权的第三方提供数据,使金融市场中的中小企业和金融服务商能够更安全、便捷地获取和共享数据,进而激发市场活力,鼓励金融创新。目前,英国已有100家金融服务商参与开放银行计划并提供创新服务,大幅扩大了数据交易市场的规模。

为了向用户提供更准确的信息服务,金融业随后发起了“开放银行倡议”。根据该倡议,金融服务商能够快速访问并获取企业数据,出具企业的信贷档案,以便贷款机构更为便捷地审核企业资质,提供最优贷款方案。目前,英国的“开放银行倡议”服务拥有300万个私人和企业用户,每年可带来上百亿英镑的收益。

(4)数据市场监管体系日益成熟

脱离欧盟后,英国自2021年开始自主建立独立于欧盟数据治理体系的数据保护制度。相较于欧盟,英国的数据治理有两个创新思路:

一是掌握制定规则的主动权,摆脱欧盟对数据流动的限制;

二是以“平衡”为创新导向,找到一个既有利于创新又能实现有效监管的数据跨境流动治理框架。

基于上述要求,英国政府专注于提供灵活的监管制度,在保障公民数据权益的同时鼓励对数据的开发应用。

2021年7月,英同启动其数字监管计划,以抓住数字技术发展的机遇,推进数据要素市场建设。其监管计划主要遵循以下三个原则:

一是创新为先,消除不必要的监管和商业负担,优先考虑技术标准等非监管措施;

二是确保监管的前瞻性和一致性,并确保监管规则、监管能力和水平适应数字技术的快速发展;

三是监管决策者应具有全球视角,并在决策时将监管行为对国际动态的影响考虑进来。

这一计划的出台标志着英国数字监管新篇章的开启。随后,英国还将《网络安全法案》提交议会审议,以出台推动数字产业发展的新制度。

(5)数据基础设施投资力度不断加大

英国政府从战略制定和产业扶持两个层面来推动数据基础设施建设。

①战略制定

在战略制定方面,英国2017年发布的《产业战略:建设适应未来的英国》明确提出英国在人工智能方面应重点发力的四个领域:

使英国成为全球人工智能和数据创新中心;

支持各行业使用人工智能和数据分析技术;

在数据安全和人工智能方面保持领先地位;

提高公民的职业技能。

随后,英国发布《在英国发展人工智能》《产业战略:人工智能领域行动》等政策文件,优先支持关键领域的创新。

②产业扶持

在产业扶持方面,英国政府设立多个基金项目,加大对数据基础设施的投资力度,如设置“产业战略挑战基金”并拨款9300万英镑用于机器人与人工智能技术研发。截至2020年12月,英国政府已向包括虚拟技术在内的沉浸式新技术研发投入3300万英镑,向数字安全软件开发和商业示范投入7000万英镑,向下一代人工智能服务等领域投入2000万英镑。2021年,英国研发投资高达125亿英镑,呈逐年上升态势。

2.2 亚洲其他地区数据要素价值发挥的理念和做法

2.2.1 日本设立“数据银行”,成立数字厅

由于面临经济持续低迷、人口老龄化、基础设施老旧等经济社会问题,因此日本试图通过发展信息技术产业,尤其是数据开放和云计算等相关技术和产业,以缓解相关社会问题带来的负担。一方面,日本率先布局顶层设计,制定出台一系列数字发展战略;另一方面,日本开创个人数据银行模式,稳步推进个人数据开发和利用。同时,在数据治理和基础设施方面,日本也展开了相关探索。

(1)以战略高位推动数据市场建设和发展

日本数据要素市场相关顶层设计工作起步较早,自l995年起便出台国家战略文件,明确重点发展信息通信、大数据等产业。2012年7月,日本推出《面向2020年的信息和通信技术综合战略》,将大数据作为发展的重点。2013年6月,日本公布新信息技术战略《创新最尖端信息技术国家宣言》,宣言全面阐述了2013-2020年期间以发展开放公共数据和大数据为核心的日本新IT国家战略,提出要把日本建设成为一个具有“世界最高水准的广泛运用信息产业技术的社会”。

近年来,日本在数据要素市场建设方面持续发力。2021年5月,日本通过《数字改革关联法》等6部法案,同时成立数字厅专门负责政府部门的数字化发展,旨在加速推进日本数字化改革。2021年6月,日本出台《综合数据战略》,明确数据战略的基本思路,制定社会愿景和实现该愿景的基本行动指南,旨在打造世界顶级数字国家所需的数据基础设施,为数据要素市场建设提供指导性方针。

(2)以数据银行促进个人数据交易

在数据交易方面,日本从自身国情出发,创新推出数据银行交易模式,最大化释放个人数据价值,提高数据交易流通的市场活力。数据银行在与个人签订契约之后,通过个人数据商店对个人数据进行管理,在获得个人明确授意下,将数据作为资产提供给数据交易市场进行开发和利用。数据银行以日本《个人信息保护法》为基础管理个人数据,基于促进流通的原则对数据权属进行界定。

从数据分类来看,数据银行内交易的数据大致可分为行为金融数据、医疗健康数据及偏好数据等几个类别。

从业务内容来看,数据银行从事包括数据保管、贩卖、流通在内的基本业务和个人信用评分业务。

日本通过数据银行搭建起个人数据交易和流通的桥梁,促进了数据交易流通市场的发展。

(3)以开放战略推动政府数据共享

日本数据开放比欧盟国家起步晚,但从总体来看,数据开放价值日益凸显。2012年,日本在《电子政务开放数据战略》中首次明确开放数据战略,通过对公共数据的二次加工,提高了行政和企业效率。此后,日本又陆续发布多个开放数据文件,如2016年的《开放数据2.0》和《促进公共和私营部门数据使用基本法》,2019年的《开放数据基本指南》,这些文件对数据开放的管理办法做出了详细规定。从开放价值来看,公共数据在工业制造、医疗、教育、犯罪预防、防灾减灾等领域的应用,产生了巨大的经济和社会效益。

一是在公益事业领域,如会津若松市使用开放数据绘制全市消火栓地图、佐贺市使用开放数据绘制本市移动热点地图等;

二是在服务行政活动中,通过公开数据,减少公民的“信息请求”;

三是在商业活动中,如扎伊姆公司基于公共数据为用户免费提供医疗账单服务,并通过提供付费服务和投放广告来获利。

(4)以个人信息保护构建数据治理规则

日本数字经济虽然起步较晚,但在数据治理领域持续推动个人数据保护,积极参与全球数据治理规则的制定。

在个人数据保护方面,日本2003年通过《个人信息保护法》,并先后多次修订,对个人数据进行严格保护。为落实该法,日本政府专门成立相关执法和监督机构,成立个人数据保护委员会,将其作为最高执法机构,监督私营部门的个人数据保护,同时与内务和通信部联合监管公共部门个人数据保护工作。

在国际数据治理规则接轨层面,日本充分利用世界贸易组织、二十国集团、世界经济论坛、亚太经济合作组织等多边组织,力图推动与美国、欧盟数据治理模式的对接。日本在《通用数据保护条例》生效两个月后,与欧盟签署《日本-欧训经济伙伴关系协定》,允许日本和欧盟之间的个人数据自由流通和共享。日本致力于构建数据“基于信任的自由流通体系”,推出“大阪轨道”系列行动,以谋求在平等地位上与美欧等国家和地区就数字经济的相关规则谈判。这表明日本致力于促进其数据治理方法与美国、欧盟数据治理方法的兼容和一致,并积极协调建立美国、欧盟和日本的“数据流通圈”。日本这一举措使其在与圈外国家谈判时具有极高的话语权,也从侧面反映了日本数据战略的灵活性。这些举措使其逐渐发展成为全球在数据治理方面最开放的国家之一。

(5)以制造计划推进数据基础设施建设

日本先后出台多个战略制造计划来推动其数据基础设施建设。日本在《科学技术创新综合战略2020》中制订并推广战略性创造计划,针对人工智能、物联网、大数据等革命性网络空间基础技术,以及自动驾驶、机器人、三维打印等革命性制造技术,制订研发支持计划。2020年,日本通过的《国家战略特区法修订案》积极推动“智慧城市”建设,以期在城市内实现自动驾驶、无人快递、无现金支付、在线问诊等生活服务。2021年,日本发布《信息和通信技术基础设施区域扩展总体规划2.0》,明确提出:通过年度预算拨付方式加快第五代移动通信网络和光纤的铺设进度,计划到2023年底将第五代移动通信网络基站数量增加到21万个。这是原来计划的3倍。此外,日本经济和工业部将投入1100亿日元用于下一代通信技术的研发,重点发展半导体和通信系统。

2.2.2 韩国Mydata模式建立监管体系

韩国政府在2020年启动数字经济发展计划,同时制定出台《公共数据法》,以战略规划明确数据的重要地位,要求国家和地方政府积极推动公共数据开放,并委托相关机构开发大数据平台,以更好地促进数据开放和数据应用。从监管来看,韩国也制定出台了系列政策,在保护个人隐私的基础上,促进数据跨境自由流通。

(1)明确数据对经济增长的战略地位

长期以来,韩国智能终端普及率和移动互联网接入速度均居世界前列,数据产出量达到世界先进水平。为充分利用这一天然优势,韩国持续制定出台大数据发展战略,并将大数据作为经济增长的新引擎加以推广。

基于朴槿惠执政时韩国政府提出的国家“创意经济”发展政策,韩国多个部门提出具体的大数据发展计划,

如科技政策研究院以构建“英特尔集成数据库”为目的提出的“数据中心战略”,

国家科技委员会2012年制定的《大数据发展环境未来战略规划》,

未来创造科学部提出国家级大数据发展计划以及《第五次国家信息化基本计划(2013-2017)》。

此外韩国在政府层面发布了《智能信息社会中长期综合对策》,建设基于大数据等技术的智能信息社会,积极应对第四次工业革命的挑战。

2021年,首尔市政府发布《首尔元社会五年规划》,并宣布从2022年起,在经济、文化、旅游、教育、书信等全市业务领域建立元宇宙管理体系,以提高城市的竞争力,增强城市活力和吸引力。这是韩国地方政府在虚拟现实服务领域的第一个工作计划。

(2)公共数据开放利用成效逐步显现

韩国制定出台《公共数据法》,明确要求政府推进公共数据开放和大数据平台建设,取得了显著成效。自2021年12月以来,韩国977个政府机构开通了公共数据共享平台,开放了49324份文件数据和8055个应用程序接口。

韩国交通部是韩国最早引入数据开放和分析应用的部门之一,例如,利用大数据分析市民交通卡和电信企业通信数据,预测地铁到站时间和车辆拥堵程度。

此外,首尔建立了“TOPIS”平台,该平台集成了综合公共交通管理系统、交通地图系统和监控摄像头系统,通过收集、传递和分析交通数据,与警察、气象部门和道路交通管理部门相互配合,极大地改善了城市交通状况。

该平台推出后,许多韩国企业开始探索如何利用平台上的公共数据开发新产品、新业务。据韩国技术信息通信部的数据,参与政府数据相关业务的新上市企业数量从2019年的5家增加到2021年的26家,企业市值已高达5.8万亿美元。

(3)数据要素巾场监管制度不断完善

韩国在数据治理领域建立了独特的国家治理模式,发展出独特的商业并搭建了相应的技术监管框架。

在个人数据保护方面,韩国在2011年3月通过的《个人数据保护法》为私营部门和公共机构处理个人数据提供了指导方针,该法案在整体上与日本公私分明的数据治理体系较为类似。该法案现已成为韩国数据保护领域的重要文件,在个人数据保护评估、跨境数据流动、数据披露申报、个人信息团体诉讼等方面做了更全面、更详细的制度安排,同时保证了通信行业、金融行业等各自领域立法的有效性。

2020年1月,韩国议会对《个人信息保护法》《信息技术与安全法》和《信贷信息保护法》等3部法律进行修正,并顺利通过修正提案,同时将数据保护条款纳入《网络法》。

在网络安全保障方面,2019年韩国政府发布了《国家网络安全战略》,提出六大战略支柱,包括提高国家重点基础设施安全、增强网络攻击应对能力、发展网络安全产业等举措。

2020年7月发布的“韩国新政”包括两项网络安全数字新政项目。

2021年9月通过的《数据产业振兴和利用促进基本法》建立了数据要素流通过程中的纠纷调解机制,支持数据交易和流通,推动培育数据要素市场。

(4)数据基础设施建设水平全球领先

韩国的信息和通信技术基础设施水平处于世界前列。自2009 年以来,韩国在国际电信联盟发布的信息和通信技术发展指数中一直处于领先地位,其地理和人口优势带动了信息和通信技术的快速发展。

截至2020年12月,韩国的互联网和智能手机普及率是世界上最高的。同时,韩国在联合国发布的电子政务发展指数中排名第一。韩国信息和通信技术政策基于明确的政府战略,在基础设施建设方面取得了非常大的成功。

为有效应对关键信息基础设施面对的威胁,韩国通过《关键信息基础设施保护法》,并在总理办公室设立了关键信息基础设施保护委员会,以进一步推动对信息基础设施的保护和开发。

2.3 我国数据要素市场的培育和推进

2.3.1 构筑数据要素市场蓝图

为有效解决公共数据的交易和流通,各地政府纷纷推出了“政府主导+企业主导”的两级模式,来构建本地数据要素交易市场。

我国改革开放的前沿阵地广东,充分吸收土地、资本等要素市场建设的有效经验,率先推出“1+2+3+X”数据要素市场化配置方案,探索数据要素市场化配置路径。

“1”是要统揽,做到“全省一盘棋”;

“2”是搭建并行的两级数据要素市场;

“3”是推动数据收集和交易等内容的新型数据基础设施、数据运营机构和数据交易场所建设;

“X”旨在促进数据在各个场景中的应用,释放数据要素的潜力。

一级市场强调政府管理机制,构建公共数据运营组织,打破原有公共数据运营模式,推动公共数据分级、分类管理,打破“数据孤岛”,确保公共数据顺利进入市场,实现流通和交易,同时利用规模经济,促进公共数据的深入升发和利用。

二级市场强调自由竞争原则,建立健全市场监管和各项保障竞争的制度,充分激发供给主体的市场活力,充分发挥价格机制的作用,由市场供求关系及其自身价值决定数据要素价格,优化数据资源配置,增强数据要素在数字经济发展中的基础性作用。

此外,北京以“北京金融公共数据专区、北京国际大数据交易所”为特色,上海以“上海数据集团有限公司、上海数据交易所”为龙头,福建以“福建省大数据有限公司、福建大数据交易中心”为核心,区域数据要素市场两级体系的雏形初步形成。

江苏上海、北京等地纷纷以生态培育为目标,创新数据要素市场发展模式。

江苏省率先开展数据要素市场生态培育项目,基于数据的资源、资产与资本属性,以构建生态系统的思路,围绕数据收集、管理、应用、流通等四大方向,引导政府、园区和各类企业先行先试,遴选了一批培育项目,并对其进行跟踪指导,打造数据要素市场价值链,构建数据要素市场生态体系,推动数据要素有序流动和高效配置。

上海数据交易所首先提出“数商”概念,将数据要素相关的业务主体汇聚到一个平台上,包括数据交易主体、数据合规咨询、质量评估、资产评估、交付等服务商,帮助企业和机构更好地整理、处理和管理数据,培育和规范新主体,构筑更加繁荣的流通交易生态。

北京国际大数据交易所则建立了面向全球的首个数字经济中介产业体系,对数据托管、数据经纪等一系列创新型中介产业进行培育。

数据托管是对受托数据清洗脱敏和数据来源合法性核验,进而实现数据的合规存储、授权管理和市场应用,促进数据价值的深度挖掘和提升;

数据经纪则侧重对接数据资源、撮合数据交易,促进数据可信有序流通和市场化利用,加速数据与经济活动融合,催生新产业、新业态、新模式。

2.3.2 安全是底线

安全是数据交易、流通和使用的底线,也是数据交易、流通和使用的基本法律要求。在数据交易、流通和使用中,需要确保数据的安全性和可靠性,以保护个人隐私、商业秘密和国家安全。

中国在数据安全和保护方面已经出台了一系列的法律和政策。2016年颁布的《网络安全法》是保障网络空间安全的基础性法律,其中规定了网络运营者、网络产品和服务提供者等主体的安全责任和义务。2018年颁布的《电子商务法》也针对电子商务领域的数据安全和隐私问题做出了规定。

为了进一步促进数据的安全管理和使用,国家还制定了《数据安全法》和《个人信息保护法》等相关法律。这些法律对数据收集、存储、加工、传输、使用等环节的安全要求进行了全面的规范,要求相关主体尊重个人隐私,保障数据安全,不得滥用数据获取不当利益。

同时,中国还成立了国家数据局,负责推进数据要素基础制度建设,推进数字中国建设,推进数字经济发展等工作。这些措施将有助于促进数据的高质量和安全使用,并推动数字经济的健康发展。

数据安全和隐私保护是数字时代的重要任务,也是法律要求。全球各国都在加强数据安全和隐私保护方面的立法和监管工作,以确保数据的真实性和可信度,保障个人隐私和商业机密,以促进数据的有效流通和共享。

2.3.3 价值发挥是关键

“数据二十条”和数据入表是实现数据价值发挥的基础性政策和举措。2022年12月2日,《中共中央 国务院关于构建数据基础制度更好发挥数据要素作用的意见》(简称“数据二十条”)发布。

“数据二十条”的核心内容是提出了4项数据基础制度,包括数据产权制度、数据要素流通和交易制度、数据要素收益分配制度和数据要素治理制度。在这4项制度中,数据产权制度是基础,流通和交易制度是核心,收益分配制度是动力,治理制度是保障。

“数据二十条”作为中央层而的顶层设计要实际落地,只有在数据被确认为是“资产”的前提下才可进行。2023年8月21日,财政部发布《企业数据资源相关会计处理暂行规定》(简称《暂行规定》),自2024年1月1日起施行。《暂行规定》明确了数据可以在一定条件下作为资产入表,这有利于完整、准确地反映企业在数据上的投入成本,同时有助于实现数据在市场流通时的合理定价,最终可以促进数据在市场上的交易。

数据资产估值入表是对企业分散的数据资源各项属性的完整登记和有效组织,是将其变为有价值数据资产的关键一步,同时也是开展数据标准制订、数据质拭提升、数据认责等治理工作的基础。

通过对企业数据资产全面盘点,可提升数据的可及性,从而有效支持数据资产治理和数据资产运营工作。

数据资产估值入表,理顺了数据产权治理,充分发挥了会计准则“启动器”作用,完成了数据从生产要素到经济资产的跨越,有利于释放出数字经济的新动能。

《暂行规定》的实施在核算企业数据资产方面具有里程碑式的意义。数据作为数字经济时代的第一生产要素,有望成为政企报表和财政收入的重要支撑,为后续数据要素的流通和交易奠定政策基础。

将数据作为独立的生产要素,与业务资源一样重点关注其价值属性,并从全生命周期视角体系化地推动数据“资源化-资产化-资本化”的发展,将能更加直观地展示新型数据战略的实施成果。

第三章 数据要素价值发挥的难点

数据作为生产要素要最大程度发挥其价值,就必然要对数据的权属、定价、交易和流通等环节的诸多内容做出相应的制度安排。而以上任何一个环节,都涉及方方面面的问题。这里面的绝大部分问题是数据自身的独特性所决定的。

3.1 数据要素市场制度难点

数据作为生产要素进入市场交易和流通,必然涉及数据的权属、价值评估、流通和监管等环节。

3.1.1 数据权属制度

我国民法典第127条对数据权益的民法保护做出了宣示性规定,宣告了数据权益本身就是一种民事权益类型,数据权益作为民事权益体系的重要组成部分,应当受到民法典关于民事权益保护规则的调整。

然而,从立法层面看,我国目前尚无法律和行政法规对数据权益做出具体界定,只有一些地方性立法在数据保护方面进行了相关探索。中共中央、国务院发布的“数据二十条”就建立数据产权制度、数据要素流通与交易、数据要素收益分配以及数据要素治理等基础性制度提出了全面和系统的意见,这对于规范数据保护和数据利用具有非常重要的指导作用。但是,地方立法和中央政策文件不能代替全国性立法。由于数据本身是一种新型财产,现有法律规则难以全面保护数据权益,从国家立法层面推动数据产权确权和数据权益保护势在必行。

(1)反不正当竞争保护法不能替代数据确权

有观点认为,可以通过反不正当竞争法对数据进行保护,即通过反不正当竞争法第2条的兜底性条款,以承担反不正当竞争法上的责任为手段,从反面对数据权益进行保护。然而, 通过竞争法调整数据纠纷并设定数据财产权的边界,实际上是在缺乏数据产权立法的情形下,不得已面为之的选择。

此外,由于反不正当竞争法并未为数据财产权提供系统的基础性保护规则,反不正当竞争法相关规则无法规范数据利用的具体行为,也无法对数据侵权做出具体认定并进行救济。

(2)知识产权保护不能替代数据确权

在满足特定条件时,部分数据将会受到知识产权规则的保护。例如,当数据以数据产品的形式呈现时,如果该数据产品具有一定的独创性(如构成汇编作品的数据库),那么其应当受到著作权法的保护。再如,当数据符合反不正当竞争法所规定的商业秘密的构成要件时,可以通过商业秘密的规则加以保护。正是由于某些数据可以成为知识产权的载体,加之数据和知识产权一样均是无形财产,交易流通的主要方式均是许可利用,知识产权中有关许可利用的规则也可以适用于数据交易。因此,有观点主张,借助知识产权的规则完全可以实现对数据的有效保护。

但是,数据权益不是归属于一个主体,而是归属于不同的主体,需要区分数据来源者与数据持有者和使用者的权益分别予以保护。针对数据来源者权益,又要区分自然人主体的来源者权益和非自然人主体的来源者权益,分别予以保护。知识产权保护的基本理念是赋予创作者垄断权利,从而激励创作者投入更多的时间和精力进行创作。但是,保护数据权利并不意味着赋予数据持有者和使用者对数据的垄断性权利,这将限制数据在市场中的流通。

所以,如果以知识产权保护替代数据确权,一方面将无法准确地确定数据权益,将知识产权的相关规则照搬到数据确权中,也会给数据确权带来不利影响;另一方面,通过知识产权保护替代数据确权,难以解决数据确权中涉及的公共利益和国家利益。知识产权的侵权构成要件和数据权利的侵权构成要件并不完全相同,倘若通过知识产权规则保护数据,将会引发系统性问题。

(3)个人信息保护不足以替代数据确权

在数据处理者处理个人信息生成数据的情形下,个人信息是数据的主要来源,但这并不意味着个人信息保护规则可以替代数据确权。数据确权与个人信息保护是两个互不相同、彼此独立的法律关系。数据确权主要调整数据处理者与其他市场主体关于数据利用的法律关系,而个人信息保护调整的是任一数据处理者与信息主体之间的法律关系。

因此,数据保护涉及多个法律部门,需要进行多维度的保护,其保护方法也具有综合性。数据权属制度是数据要素市场化和产业发展的关键制度安排,涉及数据的所有权、使用权、收益权等基本权益的确定和保护。

根据不同的数据类型和性质,数据权属制度可以包括以下三种类型:

①数据资源持有权。指数据所有者或持有者对数据的持有和管理权利,包括数据的所有权、管理权、使用权等。

②数据加工使用权。指数据加工者对数据进行处理、分析、挖掘等过程中产生的使用权,不改变数据的所有权和使用权。

③数据产品经营权。指数据产品开发者或经营者对数据产品进行开发、销售、运营等过程中产生的经营权,包括数据产品的所有权、销售权、出租权等。

在数据权属制度中,数据的所有权是基础和核心,其他权益的确定和保护都依赖于所有权的明晰。在推进数据要素市场化配置的过程中,需要建立健全的数据权属制度,明确各类数据的权益主体和权责关系,保障各方权益的合法性和公平性。同时,需要加强数据监管和法律保护,防止数据侵权和不当竞争行为,促进数据要素市场的健康有序发展。

数据权属制度是指规范数据权属关系的法律制度。在数据权属制度中,数据的权属关系被明确规定,以便于保护数据的权利人和使用者的权益。

数据权属制度通常包括以下四个方面的内容:

①数据的权属关系。规定数据的所有权、使用权、处理权等权属关系。

②数据的收集和使用。规定数据的收集和使用的条件和限制,例如数据的来源、数据的使用目的、数据的使用方式等内容。

③数据的保护。规定数据的保护措施,例如数据安全、数据隐私等内容。

④数据的转让和许可。规定数据转让和许可的条件和限制,例如数据的转让价格、数据的许可期限等内容。

数据权属制度是保护数据的权利人和使用者的权益,促进数据合理利用和流通的基础性制度。数据权属制度通常由国家立法机关制定,例如《数据保护法》《数据权属法》等。

(4)数据知识产权的探索与挑战

2021年9月,中共中央、国务院印发《知识产权强国建设纲要(2021-2035年)》,明确提出“研究构建数据知识产权保护规则。”同年10月,国务院印发《“十四五”国家知识产权保护和运用规划》,再次提出“研究构建数据知识产权保护规则”的要求。此后,国家知识产权局围绕构建数据知识产权保护规则开展了大量工作。2024年2月29日,浙江省市场监督管理局的《关于深化数据知识产权改革推进数据要素赋能发展的意见(征求愁见稿)》标志着数据知识产权探索将进入实际运用实施阶段。

作为一项全新的制度探索,数据知识产权一方面面临更复杂和高难度的挑战:传统知识产权主要针对实物产品、方法或服务,如专利、商标、著作权等,而数字经济时代的知识产权则主要针对数字产品或服务,如软件、网络内容、数字音乐等。目前,数字技术的发展速度远超过知识产权法律的制定和完善速度,导致数据知识产权法律体系存在滞后的情况。数字经济的特点是技术含量高、产权多样、应用范围广,这对于保护数据知识产权提出了更加复杂和高难度的挑战。

另一方面数据要素确权存在难题:数据本身的复杂性是数据知识产权存在难以界定的重要原因之一。在法律学的层面上,数据信息作为法律关系客体,数据权利是以数据权利客体“数据”来定义的,而当前我们对于数据的认识还不全面;另外,人工智能算法会对数据进行深度学习和创新性的处理,其产品甚至可以做到“以假乱真”。而面对这种情况,生成的数据可能来自多个知识产权的权利人,这就使得对于明确这些数据的权利归属的需求会更加迫切,而目前还没有权威、公认的界定数据产权的方法,理论层面仍存在多项需进一步探索之处。

3.1.2 数据资产评估制度

(1)数据资产的确认

评估对象范围的界定直接影响着价值评估的准确性。评估范围的扩大或者缩小,会直接导致评估值的偏大或者偏小。例如,在对企业流动资产评估时,很容易把机器设备作为流动资产列入评估范围,这样就会导致评估结果偏大;或者会忽视企业的低值易耗品,结果就会导致评估结果偏小。

数据资产评估时,评估对象是“数据资产”。数据资产在具体确定评估范围时存在以下难点:

第一,数据资产的属性仍不清晰,是列入无形资产还是单独列示数据资产一个新科目,数据资产如何进入会计报表,仍存在一系列问题;

第二,企业数据资源形式多样,数字、文字、图片、视频都属于企业的数据资源,但是在评估时要去除无效、重复等一些不能给企业带来经济价值的信息。

会计对于资产的定义规定了三个条件:

一是企业拥有该项数据资源的所有权或者使用权;

二是该项数据资源应当是企业通过已经发生的购买行为等交易方式取得或者自行开发形成的,并且其成本能够可靠地计量;

三是企业使用该项数据资源能够产生现金或现金等价物的流入,并且其价值能够可靠地计量。

只有符合上述确认为资产条件的数据资源才能确认为资产。数据的开发必须基于特定业务需求,只有能够满足生产经营需要的数据才能创造经济价值,转化为资产。所以,数据资源确认为会计认可的资产,具有比较大的难度。

(2)评估方法的选择

《资产评估执业准则-资产评估方法》规定:当满足采用不同评估方法的条件时,资产评估专业人员应当选择两种或者两种以上评估方法,通过综合分析形成合理评估结论。但是存在法律、行政法规规定,评估对象仅满足一种评估方法,受操作条件限制这三种情形时,资产评估专业人员可以采用一种评估方法。

对于数据资产评估方法的选择,要综合考虑评估目的、特点和评估方法的适用性。对数据资产进行评估,目前有三种方法,但这三种评估方法也都存在相应的难点。

①市场法

市场法的运用前提就是要有活跃的数据交易市场。目前虽然一批数据交易中心先后得以建立,比如中关村数海、数据堂、浙江大数据交易中心、贵阳大数据平台等,但是到具体数据交易时,定价的公开、透明性难以保证。

其次就是对评估对象和可比资产的差异如何量化处理。数据资产的价值受经济、技术、法律等多方面因素影响,这无疑加大了评估工作量,而且以上各因素对于价值的影响不同。如果采用层次分析法对各个影响因子赋予权重,层次分析法在使用矩阵运算时也要有专业人员对一些因素进行量化,存在一定的主观性。

②成本法

成本法的评估思路就是资产的重置成本扣除实体性贬值、功能性贬值和经济性贬值等三种贬值。

运用成本法的前提是资产存在贬值。同无形资产一样,数据资产不具有实物形态,且价值存在着较大的不确定性,其价值可能会随着数据量的积累而升值,也有可能因为数据失去时效性而贬值。数据资产主要包括获取、分析加工、维护等环节的成本。由于目前数据资产未能在资产负债表上明确列示,数据资产的成本会因为会计核算和构成多样而导致成本的全面性难以保证。

此外由于数据资产不具有实物形态,所以不用考虑实体性贬值。功能性贬值和经济性贬值的求取比较复杂。目前解决思路是运用AHP法对导致数据资产产生的功能性贬值因素赋予权重,评估专业人员确定各因素的贬值率,加权得到功能性贬值率。由于法律法规限制而导致的禁止流通或者需要脱敏带来的费用也作为经济性贬值。

③收益法

收益法评估资产价值的前提是未来资产的收益和风险可以量化。根据数据资产的特点可以得知,数据资产的不确定性比一般无形资产更要大。这首先体现在法律保护年限上。我国有专门的对于专利权、著作权的法律保护期限,但是数据资产目前还没有明确的法律对其保护年限进行约束,所以其收益和风险以及未来收益期限的不确定都给收益法在数据资产评估上的运用造成了困难。

但是目前对数据资产评估还是主要采用收益法,其次在具体参数确定时辅之以其他方法。相比于市场法和成本法,收益法更适合数据资产的评估。但是这并不代表收益法是首选方法。在评估模型的探索中既要不断完善收益法,也要考虑突破收益法的思维束缚创新评估模型。

3.1.3 数据流通制度

当前,我国逐步构建了四个层次的数据要素流通规则:一是党和国家明确提出要建立数据要素流通全流程合规与监管体系;二是地方政府出台的数据促进条例,促进数据流通和开发利用;三是以数据交易机构为主的交易平台制定的数据交易流通规则;四是数据要素流通标准体系。

(1)党和国家的制度安排

国家层面,《中华人民共和国网络安全法》(2017年6月1日起施行,以下简称《网络安全法》)、《中华人民共和国数据安全法》(2021年9月1日起施行,以下简称《数据安全法》)及《中华人民共和国个人信息保护法》(2021年11月l日起施行,以下简称《个人信息保护法》)共同构筑了维护国家主权、安全和发展的数据基础法律,形成了中国数据合规法律体系的“三驾马车”。

《网络安全法》明确了关键信息基础设施运营者在个人信息和重要数据的境内存储、出境评估等方面的法律义务。

《数据安全法》对“数据分级”做出了规定,从多个方面规定了相关企业的数据安全义务,包括制度管理、风险监测、风险评估、数据收集、数据交易、经营备案和配合调查等内容。

《个人信息保护法》对“个人信息”做出了界定,明确个人信息不包括匿名化处理后的信息,确立了个人信息处理的合法原则、正当原则、必要原则(即处理个人信息限于实现目的的最小范围)、诚信原则、质量原则(即要避免个人信息不准确或不完整)、安全原则(即保障个人信息的安全)等六大基本原则。

中共中央、国务院关于数据要素流通有三个重要文件:

一是2020年3月30日,《中共中央 国务院关于构建更加完善的要素市场化配置体制机制的意见》提出加快培育数据要素市场,加快推动各地区各部门间数据共享交换,研究建立促进企业登记、交通运输、气象等公共数据开放和数据资源有效流动的制度规范,支持构建农业、工业、交通、教育、安防、城市管理、公共资源交易等领域规范化数据开发利用的场景,制定数据隐私保护制度和安全审查制度;

二是2022年1月6日,国务院办公厅印发《要素市场化配置综合改革试点总体方案》,明确提出探索建立数据要素流通规则,要求完善公共数据开放共享机制、建立健全数据流通交易规则、拓展规范化数据开发利用场景、加强数据安全保护,具体提出了探索开展政府数据授权运营、探索建立数据用途和用量控制制度、推动完善数据分级分类安全保护制度、支持打造统一的技术标准;

三是2022年12月2日,中共中央、国务院发布的“数据二十条”,以促进数据合规高效流通使用、赋能实体经济为主线,完善和规范数据流通规则,构建促进使用和流通、场内场外相结合的数据要素流通和交易制度,明确提出建立数据流通准入规则、建立数据分类分级授权使用规范、建立实施数据安全管理认证制度,出台数据交易场所管理办法,建立健全数据交易规则,制定全国统一的数据交易、安全等标准体系。

此外,《中共中央 国务院关于加快建设全国统一大市场的意见》《数字中国建设整体布局规划》《中华人民共和国国民经济和社会发展第十四个五年规划和2035年远景目标纲要》《“十四五”数字经济发展规划》《“十四五”大数据产业发展规划》《“十四五”国家信息化规划》等文件,都提出加快建立数据基础制度、市场规则和标准规范,推动公共数据汇聚利用、畅通数据资源大循环、有效释放数据要素价值。

例如,《“十四五”数字经济发展规划》提出推动数据资源标准化工作,深化政务数据跨层级、跨地域、跨部门有序共享,加快构建数据要素市场规则,探索建立数据资产登记制度和数据资产定价规则,健全数据交易平台报价、询价、竞价和定价机制。

(2)地方政府颁布的数据条例

近年来,为了让数据真正成为生产要素,大部分省市都颁布了相关数据条例(包括大数据条例、数据条例、数字经济条例等,统称为“数据条例”),促进数据作为生产要素开放流动和开发利用。各省市在数据流通方面有四个共识:

一是推动公共数据面向社会开放,并持续扩大公共数据开放范围,推进公共数据和其他数据融合应用,不断提高公共数据共享、开放和利用的质量与效率;

二是加快培育数据要素市场,完善数据要素市场规则,推动构建数据收集、加工、共享、开放、交易、应用等数据要素市场体系,促进数据资源有序、高效流动与利用;

三是重视制定数据处理活动合规标准、数据产品和服务标准、数据质量标准、数据安全标准、数据价值评估标准、数据治理评估标准等地方标准;

四是推动大数据与农业、制造业、服务业、新兴产业深度融合,深入开展大数据领域金融、人才、科研、技术、市场等方面的制度创新。

(3)大数据交易机构的规则体系

一方面,针对数据交易过程中面临的数据确权难、定价难,市场交易主体互信难、入场难、监管难等一系列痛点难点问题,大数据交易所积极探索建立数据交易规则。

例如,2022年5月27日,贵阳人数据交易所通过创新探索,发布了全国首套数据交易规则体系,包括《数据要素流通交易规则(试行)》《数据交易合规性审查指南》《数据交易安全评估指南》《数据产品成本评估指引1.0》《数据产品交易价格评估指引1.0》《数据资产价值评估指引1.0》《贵州省数据流通交易平台运营管理办法》《数据商准入及运行管理指南》等文件。

另一方面,地方政府也在积极探索制定数据要素流通交易规则。

例如,2023年年初,深圳市发展和改革委员会印发了《深圳市数据交易管理暂行办法》和《深圳市数据商和数据流通交易第三方服务机构管理暂行办法》,对数据交易主体类型、数据交易场所运营机构、可交易的数据类型和如何确保数据交易安全进行了规定。

(4)数据要素流通标准体系

《促进大数据发展行动纲要》明确提出,建立标准规范体系,推进数据采集、政府数据开放、指标口径、分类目标等关键共性标准的制定和实施。

“数据二十条”明确指出应围绕构建数据基础制度,逐步制定完善数据流通、安全与治理等主要领域关键环节的政策及标准。

数据要素流通标准体系是对数据资源的市场化流通进行规范,包括数据要素流通交易业务相关的基础标准、数据标准、技术标准、平台和工具标准、管理标准、安全和隐私标准以及行业应用标准等内容。

2014年,工业和信息化部和国家标准化管理委员会指导成立了“全国信标委大数据标准工作组”,主要负责制定和完善我国大数据领域标准体系。

目前,我国在数据要素领域已经形成了国家标准、地方标准、行业标准和团体标准的标准化体系。随着数据要素市场的完善,数据要素流通标准将不断健全。

3.1.4 数据监管制度

(1)数据执法监管的特点

随着数据相关制度的推出和数据要素市场的发展,依据制度落实数据安全、个人信息保护、防控数据垄断等要求,成为相关执法监管部门的工作重点。当前我国数据执法监管总体上呈现出以下特征。

第一,数据执法监管工作涉及领域多、范围广、任务重、难度大,系统性、整体性、协同性强。《网络安全法》《数据安全法》《个人信息保护法》等法律的落地实施,基本上形成了直接部门主导执法,相关部门协同的格局。

第二,逐步形成了“强监管”态势。网信、公安、工信等部门多次进行年度性、季度性的执法活动,对数据相关领域的违法犯罪活动保持高压态势,同时出台各类部门规章或规范性文件明确监管要求,要求压实主体责任,规范数据的有效利用。

第三,严格法律责任追究,对大型互联网企业开出高颌罚单。执法部门依据《数据安全法》和《个人信息保护法》,对互联网企业违法处理数据的行为实施了高额罚款。《数据安全法》规定了“最高一千万元”以及“违法所得一倍以上十倍以下罚款”两种处罚额度。《个人信息保护法》第六十六条规定了不同情形下违法处理个人信息的行政责任,其中第二款将违法处理个人信息且情节严重行为的罚款金额设定为五千万元以下或者上一年度营业额5%以下。2022年9月14日发布的《关于修改<中华人民共和国网络安全法>的决定(征求意见稿)》提出:关键信息基础设施的运营者使用未经安全审查或者安全审查未通过的网络产品或者服务的,可对其处以上一年度营业额5%以下罚款。此处“按营业额比例”进行罚款,与前述“最高五千万元罚款限额”可择一从重行使。这些规定对涉事企业起到了足够的震慑作用。

(2)数据执法监管存在的问题

作为新兴领域的执法主体,无论是数据执法队伍建设,还是执法队伍的执法能力建设,目前还存在相应的短板。面对数据要素市场的独特性,数据要素市场化发展面临的新形势、新矛盾、新问题,传统的监管执法机制明显抓手不足,监管执法乏力。这些问题主要体现在以下三个方面。

第一,执法主体过多。数据监管领域“多头监管”的情况较为常见,公安、网信、工信等部门都可以基于部门立场对数据处理者执法,而真正出现数据泄露、数据滥用等数据安全事件后,用户又经常投诉无门,存在部门之间推诿扯皮的现象。执法监管体制有待进一步理顺。

第二,单向“强监管”现象严重,不能很好地满足营商环境优化的需求。数据是数字经济发展的重要驱动力量,《优化营商环境条例》规定:“政府及其有关部门应当按照鼓励创新的原则,对新技术、新产业、新业态、新模式等实行包容审慎监管,针对其性质、特点分类制定和实行相应的监管规则和标准,留足发展空间同时确保质量和安全,不得简单化予以禁止或者不予监管。”新业态有着新的特点,应考虑到数据技术应用在发展初期的草根性,监管部门需要不断调整监管方法和监管力度,保护数据产业发展的有利环境。缺少沟通的单向“强监管”以及在处罚上不断加码的“严监管”都不利于数据产业健康生态的形成。

第三,行政处罚的裁量基准不明确。《数据安全法》《个人信息保护法》等法律规范强调要通过罚款乃至于高额罚款对相关主体起到切实的震慑效果,但尚未明确行政执法的具体尺度和标准。

此外,在建立和健全数据监管制度时,也需要注重法律规范和自律管理的结合,应发挥政府监管和市场自律的协同作用,以切实实现数据要素市场的健康有序发展。同时,也需要重视国际合作和交流,积极参与国际数据治理规则的制定和完善,推动全球数据要素市场的健康发展。

3.2 数据要素市场建设难点

基于数据自身的特点,数据要素市场建设至少包括了数据登记制度、数据定价模式、数据交易模式和数据服务运营模式等几个方面的内容,而每个方面内容的建设,都存在相应的难点。

3.2.1 数据登记制度

数据资产登记起源于我国政务数据资源目录体系建设,是解决我国数据要素流通“确权难、定价难、入场难、互信难、监管难”等问题的前提。

资产登记需要数据持有者明确数据资源目录,梳理数据资源,交由第三方数据资产登记机构进行核验和统计分析。第三方数据资产登记机构基于制度规则与数字化技术,对数据资产进行审核、评估,并对数据资产及持有者的各项信息(包括数据资产名称、数量和流通轨迹等)予以登记,标注数据资源的持有权归属,为数据“确权”提供参考,有效地将数据资源转化为数据资产,推动各类数据积极参与数据要素市场化流通,保障数据在合法合规的框架下实现交易流转与共享,促进数据价值释放。

(1)数据资产登记的必要性

数字经济时代,数据成为核心生产要素,是推动产业结构转型升级、实现经济社会高质量发展的重要推手。目前,数据要素市场的发展仍面临数据权属不清、数据定价机制不明等一系列难题。加速推进数据资产登记工作,能够尽快将数据资源转化为可参与市场流通的数据资产,明确流通共享数据的产权归属,提高数据要素市场主体间的互信程度,保证数据流通交易合法合规,推动数据要素市场科学、高效监管机制的形成,促进数据资源整合、开放共享与价值提升。

数据资产是能带来未来经济收益的数据资源,数据资源只有具备可控制、可计量和可变现的属性,才能转化为数据资产。

数据资产登记,

一是解决了数据的可控性问题。

数据资源只有在企业合法合规控制和管理的前提下,才能转化为数据资产。对元数据评估与审计后,数据资产被明确记入第三方数据资产登记机构,数据权限归数据登记方所有,为数据所有者颁发登记证书,明确数据产权归属,才能使数据权属受到法律保护。数据资产登记保障拥有者在合法合规的情况下,实现对数据的完全控制,获取数据流通产生的经济利益,并约束他人使其无法从中获取其不应得的收益。

二是解决了数据的可量化问题。

数据资源资产化,就必须将数据从企业实际生产与运营中分离出来,并能够以货币为单位计量。数据资产登记工作的推进,有利于推动数据持有者对数据进行目录式梳理和分级分类管理,并登记数据名目,界定管理范围,便于后续的盘点、检索与使用,使数据具备计入资产负债表的前提条件,促进数据资产进入市场流通,实现价值最大化。

三是解决了数据的可变现问题。

数据资源转化为数据资产,才可以为企业带来持续的经济收益。一方面,数据资产登记为企业数据类型,获得质量背书,证明运用该数据资产的产品存在市场价值,具有明确的使用价值;另一方面,数据资产登记能够保证对数据资源加工与处理的合规,帮助提高数据资源价值,并帮助数据资源创造新价值。

数据资产登记能够实现数据在一定时期内的重复使用,加速推进数据资产化,进而推动数据要素市场化配置。数据资产登记工作采用区块链等数字化技术,保证了数据产权归属的唯一性,推动了海量数据资源资产化并参与市场交易,扩大了数据要素流通范围,保证了数据流通使用的安全和合法合规,实现了数据要素的市场化和价值化,能够进一步发挥数据蕴藏的价值。

(2)推行数据资产登记的制约因素

数据资产登记制度的确立与推广,能够解决当前我国数据要素市场培育面临的一系列难题,但同时数据登记制度也面临着制度体系不完善、相关服务机构缺口较大,以及登记平台缺乏等挑战。

①数据资产登记制度有待完善。

我国各级政府部门对数据资产登记制度体系建设进行了有益探索,但目前仍然缺乏全国统一的数据资产登记立法。

一方面,现有数据资产登记制度地域限制较强。我国部分地区已制定数据资产登记相关制度,对数据资产登记对象类别与认定标准、基本条件、机构设立基本要求与权威性认证、认定证书信息与颁发条件等关键内容进行了约定,但这些约定仅限于该区域内的数据资产管理。例如,山西省颁布的《政务数据资产登记目录清单编制规范》与贵州省颁布的《贵州省政府数据资产管理登记暂行办法》,都仅限于本省政务数据资产登记工作,难以实现数据资产登记的跨区域互认和统一管理。

另一方面,数据资产登记制度存在较强的类别局限性。各省建立的数据资产登记制度仅对特定类别的数据资产登记做了规定。例如,山东省省内数据交易机构颁布的制度条例对公共数据资产与企业数据资产的针对性更强,广东省颁布的电子数据资产凭证仅限千公共数据资产,浙江省“数据资产云凭证”仅应用于个人数据,尚未在政务数据、公共数据、企业数据与个人数据等多个领域同步推广应用。

②数据资产登记机构相对匮乏。

数据资产登记机构既是数据进入流通环节的入口,也是构建数据要素的核心基础设施和推进数据要素市场化的关键环节,但我国现有数据资产登记机构相对匮乏,以致数据资产登记战略难以落地执行。

自2015年起,我国虽然陆续成立了中关村数海数据资产评估中心、内蒙古数据资产评估中心等服务机构,开展了数据资产登记确权服务,但多作为辅助性业务,针对性不强。

专门负责数据资产登记确权业务的第三方数据资产登记机构缺位,面对海量的数据资产登记需求存在较大的缺口。

③数据产品登记平台亟须建立。

数据资产登记平台是完成数据资产登记工作的重要载体。目前,我国数据资产登记平台相对分散,类别限制较多,功能较弱,且缺乏统一标准。

一是数据资产登记平台建设尚未实现互联互通。

部分地区政府已构建相应的政务数据资产登记平台,部分第三方数据交易机构也建立了企业与公共数据资产登记平台。例如北京国际大数据交易所数据资产登记中心作为全国首个数据资产登记中心已正式揭牌,但上述平台均不能实现数据资产登记的互联互通,仍存在不同类别数据的资产登记壁垒,限制了数据要素资源与数据资产的汇聚融合与价值发挥。

二是数据资产登记程序尚未明确统一。

不同数据资产登记平台的业务要求存在明显差别,例如数据资产登记申请所需材料规范不同、数据资产登记调查内容不同、审计要求不同等。数据资产登记服务体系难以统一,对数据资产在全国范围内的可信登记与上链形成掣肘。

三是数据资产登记平台的规范性存在地区差异。

对数据资产登记证书这一明确数据资产权属的必要证明文件缺乏统一的构成要件标准,各地区数据资产登记平台对数据资产登记证书包含内容(包括数据资产的登记日期与机构、数据来源、数据提供者、数据使用期限与使用限制,以及数据保密要求等)和形式规范存在较大差异,不同平台的数据资产登记证书与数据要素产权唯一性难以互认。

3.2.2 数据定价模式

从经济学角度来讲,价格是单位产品或服务价值的表达,是交换价值在流通中的转化形式,而定价就是确定单位产品或服务价值的过程。数据作为生产要素具备经济属性,其自身价值也需要通过价格来进行表达。

具体米讲,数据产品是指经过数据收集、整理、分类、加密等一系列处理之后的数据衍生品和服务,根据数据处理和传输方式的不同,数据产品可以分为数据包、数据服务、数据应用程序接口和数据报告等不同形式。

数据定价指的是对原始数据加工和处埋之后,对能够作为生产要素的数据产品和数据服务的价格界定。

(1)数据定价影响因素

由于数据户品的特殊性,数据产品在定价时要充分考虑交易场景多元化和市场结构的复杂性。具体而言,需要考虑以下三个因素:

第一,数据产品的价值高度依赖场景,存在高情景相关性;

第二,数据产品的交易不同于传统商品,数据交易包括使用权、持有权等不同权利谱系的交易,需要分别界定;

第三,单边市场和多边市场的复杂结构会影响数据产品和数据服务的定价。

(2)数据定价制度

在具体场景下,基于市场结构和交易方式界定等多种条件确定数据价格,既包括对数据资产的估值,又包括将数据产品作为商品进行销售的价格。数据定价制度是数据要素市场的基础性制度。概括而言,数据定价制度主要包括四个方面内容:

一是完善由市场决定数据要素价格的机制,形成数据价格共享机制并搭建动态监测预警体系,对数据价格予以实时透明展示;

二是培育规范的数据交易平台,健全数据交易平台询价、报价、竞价和定价机制,探索协议转让、挂牌等多种形式的数据交易模式;

三是鼓励市场主体探索数据资产定价机制,推动形成数据资产目录,逐步完善数据定价体系;

四是健全生产要素由市场评价贡献、按贡献决定报酬的机制,充分体现数据的价值。

(3)数据定价机制面临的主要问题

①数据产权不清晰。

明确的数据产权是数据要素市场化的前提,也是制约数据定价的关键因素。市场中的大多数数据都是由多个主体共同开发的,但不同主体在数据形成过程中的贡献却难以区分清楚,由此围绕数据产权就产生了很多争议。

确定数据产权,就是要解决数据归属、数据使用权和数据收益归属问题。目前的法律规定和数据产权理论尚没有办法清晰界定数据产权划分和归属问题。数据产权的模糊性导致难以准确界定哪些数据可以交易,哪些数据不应在市场上流通。数据产权如果不能科学准确界定,那么数据定价的实现难度就会更大。

②数据价值难以评估。

与传统生产要素相比,数据的独特属性使其价值难以得到科学有效地评估。

第一,数据价值通常是在多个环节中生成的,数据价值生成的各个环节虽然都是相对独立的单元,但并非将整个数据价值生成环节全部走完才能够产生数据价值。从数据采集到数据处理和分析,每个衔接环节都会产生阶段性成果,这些阶段性成果也可以满足特定场景需求。所以,数据在不同价值生成环节中的价值变化,导致无法静态地评估其价值。

第二,数据产品的使用是可重复的,存在多主体使用的情况,且数据本身在使用后也不会被消耗。此外,不同主体对数据产品的价值估值也是不同的,由此导致数据难以被统一定价。

第三,数据价值发挥涉及要素融合,数据产品通常需要与实物资产和有形资产结合才能生成价值,但在最终计算价值时,需要将最终成果剥离出来进行价值评估,这也为单独确定数据产品估值带来困难。

③数据价值测度体系不健全。

作为重要的新型生产要素,明确定价机制,实现科学的价值评估是数据交易的前提。目前,数据的价值测度体系建设还面临一定的困难。因为数据价值测度与数据自身的特性息息相关:

一是数据存在显著的异质性,标准化的数据占整体数据的比例很低;

二是以流量形式存在的数据其价值更能得到体现,而以存量形式存储的数据价值可能锐减;

三是数据价值高度依赖使用场景,同一数据在不同场景的价值差异较大;

四是数据的价值变化呈非线性特征,例如一项数据随着收集量的增加,边际成本递减,而价值却不断增加。

④数据交易规则尚未形成。

作为一个新事物,数据交易目前在全球尚未形成统一的、规范的交易规则,也尚未形成完整成熟的交易模式。从实践来看,大多数数据交易都依赖相关平台,包括交易模式、定价、监管等内容,而数据要素的市场监管又不同于传统市场。数据交易市场透明度低,买卖双方关于交易价格的信息不对称将会阻碍数据要素定价机制的形成,有可能导致数据垄断行为出现,甚至出现数据产品被复制、盗用、滥用等情况。

3.2.3 数据交易模式

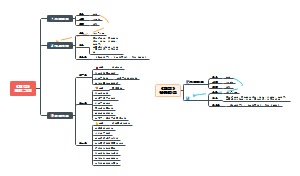

数据要素不同于传统要素,在建立数据要素市场交易模式的时候,需要探究数据要素市场与传统要素市场的差异,然后才有可能建立起适合的数据要素市场交易体系。根据交易内容(数据加工的程度)差异,目前数据交易一般可分为直接交易和间接交易两种,数据交易由此也形成了两级市场体系。

数据市场直接交易和间接交易对比

直接交易指的是数据卖方向数据买方直接提供没有加工的原始数据,间接交易模式指的是数据卖方向数据买方提供经过一定加工的数据产品。两种交易模式在适用条件、交易方式、交易规模等方面都存在显著差异。

在适用条件方面,当原始数据价值容易评估的时候,直接交易更适合,当数据的网络外部性较强、敏感性较强,数据脱敏后才能保证数据安全的时候,间接交易更适合。

在交易方式方面,直接交易可以采用订阅模式、捆绑销售、多阶段销售(先提供部分随机数据,再交易所有数据)等多种方式,间接交易可以采用两步定价法(固定费用+计量费用)、拍卖、第三方平台等方式。

目前已经有多种数据交易模式,典型的有以下七种。

(1)数据交易所模式

数据交易所一般是政府牵头、多方参与建设的一个场内交易场所,例如贵阳大数据交易所、东湖大数据交易中心、华中大数据交易所、上海大数据交易中心、江苏大数据交易中心等。在数据交易所,数据供需双方在政府监管下进行数据和数据产品交易。但由于信息不对称,数据和数据产品交易存在很多障碍,因此大部分数据交易所的交易规模有限。

(2)场外直接交易模式

现实中大量的数据需求,很多无法通过数据交易所得到满足,因此市场上很多数据需求者通过一定渠道找到数据供给者,然后双方协商,通过数据交易合同进行数据交易。这种场外交易存在很多问题,比如私下交易难以监管、数据容易被二次转让等。同时,场外交易模式下数据提供者的数据权益也难以被保证,而且数据安全和隐私保护也难以实现。

(3)资源互换模式

资源互换是很多互联网平台当前的常用手段,通过免费的APP服务,互联网平台获取用户的数据使用权。这种模式带来了很多问题。

首先,由于双方地位不平等,互联网平台往往会过度收集用户数据,包括经常性收集其基本功能需要之外的数据。

其次,数据滥用问题严重。互联网平台常常会过度使用用户数据,在没有得到用户授权的情况下将数据用于其他用途或者将数据转让给他人。

再次,用户的数据复制权、可携带权等权益无从保障,一般用户较难将自己的数据迁移到其他平台。

最后,平台利用用户数据开发数据产品,但是用户难以获得其合理的数据收益。

《个人信息保护法》针对当前存在的问题,规定了个人信息处理有最小方式、最小范围、最短时间的“三最”原则。

(4)数据云服务模式

数据供给方向数据需求方以“云”的方式提供相应的数据服务,而不是直接提供数据,这样数据需求者相当于购买了数据服务。这种模式有利于保护数据安全和供给方的权益。

(5)会员模式

数据供给方建立俱乐部,然后数据需求方通过注册会员方式,即可以获得相应的数据访问权限。会员可以分级,不同级别的会员有不同级别的数据访问权限。这样数据供给方就可以通过区分消费者增加数据收益。

(6)数据接口模式

区别于直接提供数据,还有很多数据提供者会向数据需求者提供数据的接口(API)。这种模式可以促进数据的流通,增加数据的交易规模,而且可以控制数据开放的范围。

(7)数据产品交易模式

可以基于隐私计算、密码学等数字技术对数据加密,将数据包装成产品,实现数据的“可用不可见”。在保障数据安全的前提下,数据提供者可以向数据需求者提供数据产品和服务。这种模式的技术要求较高,但是安全性也较高。

尽管现有的主流数据市场已经形成了两级市场交易体系,但现有的数据要素交易模式还是不能解决所有场景的数据需求。

3.2.4 数据服务运营模式

从数据来源分类,目前进入市场交易的数据还可以大体分为政务数据和企业数据。不同来源的数据具有不同的特点和属性,也就具有不同的数据服务运营模式。

(1)政务数据市场化运营

政务数据市场化运营是指将政务数据资源的所有权、收益权和使用权等权益开放流通,将政务数据资源转化为政务数据资产。政务数据市场化运营可细分为标准化场景服务、已汇聚政务数据的受托服务和未汇聚政务数据的受托服务三种模式。

政务数据标准化场景服务

已汇聚政务数据的受托服务

未汇聚政务数据的受托服务

数据汇集区包括政务原始数据区和政务数据挖掘加工区两部分。数据运营服务平台是联通政府数据供给侧、数据需求方和数据交易平台等多主体的数据处理区。政府的受托服务运营是在平台数据资源不出安全域的情况下,为支持具备开发能力的产业用户和生态技术服务商提供按需的数据开发服务。数据实验室主要面向生态技术服务商和产业用户,基于固定安全边界提供数据资源、算力、办公场所等条件,以支持数据运营平台受托服务业务及自身算法孵化的封闭数据开发。数据需求者依据自身需求提出相关数据产品使用申请,平台运营者审核之后配置数据产品使用权限。其中平台数据指被接入平台的原始数据,经过平台的清洗、过滤、挖掘、标签化、分级分类等相关操作后,可用于服务数据需求者和平台运营者的数据。

在数据由收集、存储向平台运营层流动的过程中,需要经过数据申请与数据授权审批、数据接入和审查等环节。例如,数据平台运营者向数据所有者提出数据使用申请,并提供数据使用场景说明,政务数据所有者对数据使用清单及使用场景审核,完成签字审批和存证等流程。审批通过后,在数据运营服务平台上同步数据任务创建,并完成数据下发与数据脱敏等工作流程。平台中的产品包括API、产品应用、行业解决方案、数据类项目等标准化场景数据服务,基于上述服务开展产品运营,主要是实现对数据运营平台产品超市的设计、研发、运行、监管与维护等工作,包括平台运营者对标准化数据产品进行产品筛选、产品分类与付费类型筛选等。

数据运营平台作为市场交易载体,承担着提供交易规则、审核交易主体资格、监督交易行为相应的自律监管职责,需对进入数据运营平台的数据供给方、需求方进行资格审查,以签订协议的方式确认其资格,并全程监督其运营行为。从标准化运营视角看,政府和平台运营者要对购买数据产品的数据需求方的资质和需求目录进行合规性审核并签订购买协议,平台运营者为需求者提供数据衍生品接入服务。

按照上述运营思路,受托服务过程包括服务商入驻和实验室入驻两部分。服务商包含生态产业用户和服务提供商,服务商入驻平台须首先向平台运营者提出申请。进驻平台的生态技术服务商承接众包开发和算法研发等任务,可以向平台运营者申请入驻数据实验室。生态技术服务商与数据需求者须向平台提供相应资质证明,由政府监管方与平台运营者共同进行资质审核,并签订相关入驻协议。从需求角度来看,生态技术服务商或数据需求者将相关产品、需求所涉及的数据目录提交平台,由政府监管方与平台运营者对其合规性进行审核,平台需求结合生态技术服务商能力进行交易撮合,并由平台提供流程保障和相对应的算力支持。

当数据使用方或申请方申请尚未汇聚至数据运营平台的政务数据时,相关申请在被受理后,数据需求将被汇总至大数据局等管理监督部门。大数据局等管理监督部门按照数据需求启动数据汇聚工作。在申请材料移交至数据源提供部门的资质审查环节,管理监督部门联合数据运营平台,结合申请方的申请材料,共同审查该数据是否涉及国家机密、商业秘密、个人隐私,或者法律法规规定不得开放的数据。数据申请方的资质、数据用途、数据处理和安全管理能力如符合要求,管理监督部门则会同业务受理方共同要求申请方签署相关协议,并通知相关数据源的委办局进行详细审查,之后将数据汇聚至数据运营平台,并依据相关规定为申请方提供所需的数据服务。上述过程表明,平台、算法和算力水平的提升和优化,会逐步实现数据使用效率和数据安全的平衡,并形成良性的内生数据供需闭环,为不同生态主体提供充足、有效的数据集合,进而推动不同算法体系和平台规模的创新和迭代。

通过切实满足数据使用单位对政府数据的需求,能够充分发掘其在数据创新方面的潜力,同时进一步推动更多主体参与到数据创新应用中,形成积极参与的良性数据生态系统。运营平台在政府授权下,能够从政府部门取得运营数据,数据运营服务产生的经济效益又能够用于政府数据的进一步运营,数据运营平台也可以增强自身数据服务能力,这在某种程度上也提升了政府的公共治理能力。

(2)企业数据市场化运营

就企业数据而言,数据市场化运营主要采用受托服务模式。数据运营者与企业数据所有者结合市场需求协商企业数据使用场景,经协商确认的企业生产、销售、管理等数据由企业授权数据运营平台运营,获得授权的企业通过交换共享或数据服务接口的方式接入数据运营平台,企业的授权数据进入政务网受控区,依据应用场景需求形成标准化数据产品并上架至数据运营平台。

企业数据受托服务可分为无需政府审核和需要政府审核两种情形。

无需政府审核的企业数据受托服务流程

需要政府审核的企业数据受托服务流程

在需要政府审核的情况下,若政府部门对受托运营企业的数据申请内容和使用目的存疑,企业方应将申请材籵移交至政府审核,再将受托服务的需求引入数据实验室。上述相应的操作行为均需实时进行上链(区块链)处理。

数据运营平台的健康发展需要合理、完善的政府监管配套措施。各级政府作为数据要素市场化、资产化的主导者,应自上而下明确数据市场化的目标,在宏观层面上统筹、协调数据资产化各个阶段和过程的关系。通过设立大数据局等政务数据的专有管理监督部门,建立和完善数据市场交易的监管制度,保证数据资产的安全、合法和规范有序运行。单纯的行政监管往往会面临监管成本高、权力寻租、效率较低等政府失灵问题,因此应确立平台内部技术监管与行政监管并行的监管模式,由政府部门和数据运营平台分别承担监管职责,并按照政府部门整体监管、运营平台具体监管的原则各自规范流程。

从行业自律视角,企业应将其授权的数据库、数据管理平台接入数据资源平台。数据核查过程基本与政务数据的处理一致。如果申请方受托运营的企业数据与数据申请内容和使用目的存疑,应将申请材料移交至企业方与数据运营平台方双向审核。从运营平台内部监管技术层面来看,上述市场化机制对应的监管流程可以通过实时上链(区块链)来实现。区块链技术可以保障数据处置的公信力,便捷的操作步骤可以降低政府监管的困难程度,并解决数据要素市场化运营的一系列痛点。

首先,区块链具有确权功能。区块链架构中的识别技术与共识机制能够避免交易被篡改,这有助于验证数据资产所有权的流转。当所有权出现争议时,数据所有者能够通过区块链交易的时间戳等方式证明其合法性。其次,区块链在交易前能够帮助数据需求方确定数据集是否符合需求。数据需求方在数据交易前无法明确供给方提供的数据是否与描述相符,运用区块链技术后,所有“元数据”都记录在链,可进行证据留痕验证,这在一定程度上可规避数据需求方随意泄露数据和对数据进行修改的风险。

近年来隐私计算技术的发展,使得各参与方在不泄露各自数据的前提下可以对数据进行联合学习、联合计算。通过打造数据实验室,以封闭的物理和网络环境,在隐私计算的帮助下,可以保持数据在存储、传输和应用层面的绝对安全。再利用区块链等技术实现业务全流程的上链存证,保证流通过程的不可篡改、全程可追溯。这些技术手段的应用,一方面降低了个人、企业和政府数据的泄露风险,提高了数据使用安全,促进了数据互通协作和融合;另一方面,隐私计算能够证明、记录企业是否践行了相应的数据保护责任,从而与区块链技术共同解决数据市场化运营过程中的交易可追溯问题。数据脱敏、加密和在不同场景下的应用,可以转化为基于数据融通的数据产品和数据服务。

数据运营平台是需求导向的。一方面政府或者企业方提供常规数据,数据运营平台为潜在的数据需求方提供服务,例如根据企业、法人等市场主体的经营内容为其设计、规划数据应用场景;另一方面则要根据数据需求方的需求,向政府部门或者企业提出数据申请,实现个性化、定制化服务。更进一步,数据运营平台还可以利用现有的数据分析能力提供业务咨询、解决方案和市场运营策略,并主动与可能的数据需求方建立业务联系,实现政府数据与市场主体的需求贯通。数据运营平台还可以利用数据和技术流入,为政府的创新发展和智慧治理带来策略上的提升和公共服务能力的改善。

3.3 数据安全问题

数据采集、清洗、汇聚,以及在形成数据产品、提供数据服务全过程的每一个环节,无一不涉及数据安全问题。数据安全问题可以说是数据要素市场形成和运行过程中的最大挑战。数据安全问题又可以大体分解为公共安全、隐私安全和合规等方面的问题。

3.3.1 数据的公共安全

数据的公共安全是指公共数据被非法获取、篡改或破坏,以及超过一定数量的个人数据和企业数据由于泄露和非合规汇聚,而带来的对公共利益的损害。公共数据通常包括来自公共机构(包括各级行政机关和经法律法规投权的具有管理公共事务职能的组织,以及供水、供电、供气等公共服务运营单位)在依法履行职责或者提供公共服务过程中收集、产生的数据,这些数据的公共性较强,一旦数据被泄露或破坏,可能会对公共利益和社会秩序造成严重影响。

为了保护公共数据的安全,通常需要采取以下措施。

①建立健全公共数据安全制度。

建立健全公共数据安全制度可以为公共数据的安全提供法律保障,例如建立公共数据安全管理制度、制定公共数据安全法律法规等。

②采用先进的数据安全技术。

采用先进的数据安全技术可以提高公共数据的安全性,例如采用数据加密技术、身份认证技术、访问控制技术等。

③加强数据安全培训和教育。

加强数据安全培训和教育可以增强公共机构服务人员的数据安全意识,减少数据泄露风险,例如进行数据安全培训、数据安全教育等。

④加强数据安全监管和检查。

加强数据安全监管和检查可以发现和修复系统的问题,防止公共数据被非法获取、篡改或破坏,例如进行数据安全检查、进行数据安全审计等。

个人数据和企业数据,在其采集、存储、脱敏、汇聚、应用,尤其是出入境等环节上,也需要加强法律法规建设,严格法律法规要求,同时强化技术分析和技术防护。

3.3.2 数据的隐私安全

数据的隐私安全是指防止个人隐私数据被非法获取、篡改或破坏。个人隐私数据通常包括个人身份信息、个人健康信息、个人金融信息等敏感信息,这些信息的泄露或破坏可能对个人利益和社会秩序带来严重影响。

为保护个人隐私数据的安全,通常需要采取以下措施。

①建立健全个人隐私数据安全制度。

建立健全个人隐私数据安全制度可以为个人隐私数据的安全提供法律保障,例如建立个人隐私数据安全管理制度、制定个人隐私数据安全法律法规等。

②加强个人隐私数据安全监管和检查。

加强个人隐私数据安全监管和检查可以及时发现并修复存在的问题,防止个人隐私数据被非法获取、篡改或破坏,例如进行个人隐私数据安全检查、个人隐私数据安全审计等。

3.3.3 数据的合规标准

数据的合规标准是指对数据收集、处理和使用的规范和要求,以确保数据的合法、合规、安全和可控。数据合规标准通常包括数据隐私标准、数据安全标准、数据质量标准、数据管理标准等内容,这些标准通常包括了国家法律法规、行业标准和组织内部规定。

为确保数据的合规性,通常需要采取以下措施。

①建立健全数据合规管理制度。

建立健全数据合规管理制度可以为数据的合规提供法律保障,例如建立数据合规管理制度、制定数据合规法律法规等。

②加强数据合规培训和教育。

加强数据合规培训和教育可以增强公众的数据合规意识,减少数据违规风险,例如进行数据合规培训、进行数据合规教育等。

③加强数据合规监管和检查。

加强数据合规监管和检查可以发现和修复存在的问题,防止数据违规行为,例如进行数据合规检查、进行数据合规审计等。

第二部分 数据要素价值发挥的理论与技术

第四章 数据要素价值发挥的理论基础

土地作为最基本的生产要素,在人类历史长河中发挥了重要的作用,与劳动力和资本共同构筑起了现代经济繁荣。土地具备物理独占性和使用排他性,且具备内生动力,不需要任何外部要素和力量的加持,就可以天然长出树木和庄稼。数据与土地、劳动力、资本、技术一起构成生产系统的五大要素。数据不同于土地,作为生产要素,既需要劳动力和资本的加持,同时也离不开“第一生产力”的科学技术赋能,才能发挥出其价值。

数据要素价值发挥经历了从数据到知识,再从知识提取价值的过程。价值来源于主体对数据携带的知识的认同,知识再经过主体产生效用或效益。例如,企业数字化转型的前提是实现业务数字化,企业获得价值需要通过数据洞察来优化业务来达成。洞察和优化是对数据价值的挖掘,是数据要素价值发挥不可缺少的环节。这个环节可分为两个阶段,即数据的收集和数据价值的提取。数据要素价值发挥是收集到一定体量的数据后,数据经由技术加工发生质变并完成数据价值提取,再将数据产生的价值服务于特定主体,从而生成效用和效益。

本章首先从数据要素的底层逻辑切入,阐述数据要素激发量变到质变的过程;然后从计算机技术发展视角,分析数据要素市场经济逻辑的组织形式,以及和数据交易所的差异性;最后,构建数据要素安全流通理论基础,并阐述数据要素价值发挥在当下的可行路径。

4.1 信息论与数据要素内在价值

信息的来源很多,通过人与人、人与自然的父互,人可以获得直接信息,人也可以通过书籍、音像等多媒体资源获得间接信息。随着数字技术的广泛应用,数据成为信息最主流的存储和传播方式。从数据中提取信息的过程也是数据价值挖掘的过程。

4.1.1 数据价值发挥途径

数据是对客观事物本身,客观事物的性质、状态以及相互关系进行记录并可以鉴别的物理符号或这些物理符号的组合。信息时代,数据作为被存储或记录的未加工原始素材,既是信息的承载体,也是构成信息的基础。

信息论奠基人克劳德·艾尔伍德·香农(Claude Elwood Shannon)认为:“信息是用来消除随机不确定性的东西”。控制论创始人维纳(Norbert Wiener)认为:“信息是人们在适应外部世界,并使这种适应反作用于外部世界的过程中,同外部世界进行互相交换的内容和名称”。信息是基于需要对数据进行加工,提供决策价值的有效依据。有价值的信息,沉淀并结构化后形成知识。狭义地说,知识是信息综合加工后提取的对系统的认识。智慧是生命所具有的一种高级创造思维能力。知识是人作为主体,基于对信息的理解而创造出来的一种新的认识。数据->信息->知识->智慧,是数据价值发挥的一个基础路径。

数据价值发挥金字塔

在从数据提取信息的过程中,劳动力与技术起到了关键作用。知识的提取也是类似的过程。信息在满足特定场景的需求后,经由技术和人类劳动的转化才能形成知识。信息基于特定的目标设计,产生具体动作并服务于特定目标的能力,本质是依赖于已经植入系统的相关知识。

例如在智能家居中,当我们推开门时客厅灯自动亮起这个场景。这个过程中,门的开关数据被实时收集,智能家居的控制系统接收这个数据并理解了这个数据背后的信息,然后基于规则,当门打开时自动打开客厅顶灯。“门被打开”是数据被加工后形成的信息,而“开客厅顶灯”是决策的执行。这就是从数据到信息,再将信息转变为价值(决策)的完整过程。实际上,上述过程隐含了一个“门开-开灯”的大的逻辑规则,这是人基于常识设定的一条知识。因此,数据价值发挥涉及数据加工和信息重组。

人工智能大模型提供了一种新的从数据->信息->知识的实现模式。这种模式基于大模型海量参数构建“基础知识库”,再结合新数据生成新知识。计算机通过对人类过往经验积淀数据的大量训练,识别出数据中包含的逻辑模式,形成“基础知识库”,直接完成数据到信息,信息到知识的提取。这个过程的具体案例有物体识别、模拟发声以及基于大模型的生成式人工智能等。这个过程就像一个智者,只需输入少量新信息,就可以结合已有的信息和知识,生成新知识,甚至新智慧。大模型之前的决策式AI通过训练获得知识,大模型时代的生成式AI通过训练获得知识中的逻辑。这些能力使得人只需要简单给出提示词,即可获得大模型积累的海量知识背后的价值。

数据、信息、知识和智慧是人类面向复杂世界,基于人类认知方式形成的常规路径,但这个路径也绝非坦途。即便“基础知识库”是集人类儿千年文明形成的产物,也无法给出普遍适用于任意行业和任意人群的通用方案。此外,大模型输入的数据以公开数据为主,而高价值数据往往分布在不同的机构和个人手中,甚至还有大部分信息、知识和智慧是在一部分人的头脑中,并没有以数据作为载体,更不用说被大模型吸收了。因此,最佳策略是基于鲜活的数据、灵巧的加工方法和专业化的知识提取分工,构建数据要素价值转化路径,然后在必要时再借助“基础知识库”,完成数据到智慧提取过程的融合,释放数据价值。

例如,某企业售后服务部门积累了数年的设备维修方法,并形成了经验库,但这些经验仅局限在企业内部分享。如果用户咨询一个产品售后问题,这个时候就需要有经验的售后人员,通过收集客户的问题数据,形成专屈于该客户及其设备的信息,最后基于经验库知识给出该客户问题的解决方案。这个过程,就是通过企业内部经验数据和客户特有数据而发挥价值的简要过程。

4.1.2 大语言模型时代的数据价值

2023年5月2日至9月27日,全球几乎所有著名影视剧编剧组成的团体-美国编剧工会,组织了一次持续了148天的罢工。这次罢工的诉求除了提高薪金水平,改善工作条件之外,还包括限制在编剧创作过程中使用生成式人工智能。

这次大罢工,本意是禁止人工智能参与编剧创作,然而大罢工又确实给人工智能编剧功能的使用带来了机会。人工智能模型基于人类创作的内容进行训练,又创作出人类几乎无法分辨的内容。ChatGPT的编剧水平不断进步,大有青出于蓝而胜于蓝之势。

AI虽然不理解人类情绪,但创作出与人类特定情绪相关的内容已不是什么难事,比如写诗就难不倒AI。罢工中抵制AI的事件,与2023年3月29日包括特斯拉的马斯克、苹果的联合创始人沃兹尼亚克、人工智能教父级人物杰弗里·辛顿(Geoffrey Hinton)在内的1100多位业界知名人士呼吁停止大模型人工智能试验一样,都是人类基于大模型的迅速进化而对未来人类发展的担忧。目前看来,人类对大模型的抵制没有起到作用,大模型进化反而越来越快。

ChatGPT通过汇集大量数据训练一个超大神经网络,使得网络出现了涌现能力。斯蒂芬·沃尔弗拉姆在《这就是ChatGPT》中提到:如果你有一个足够大的神经网络,那么,你也许可以做任何人类可以轻松做的事情。但是,你不会捕捉到自然界一般能做什么,或者我们从自然界中塑造出来的工具能做什么。正是这些工具的使用-无论是实用的还是概念性的-使我们能够在最近几个世纪里超越“纯粹的人类思想”的界限,并为人类目的捕捉更多物理和计算宇宙中的东西。ChatGPT 从根本上一直试图做的是产生迄今为止它所获得的任何文本的“合理延续”,其中“合理”是指人们在看到人们在数十亿个网页上写的内容后可能期望某人写的东西。

ChatGPT通过大量语料训练的神经网络(ChatGPT3有l750亿个参数),压缩了人类提供的全部知识,然后通过提示词不断推断出下一个字出现的概率。例如“数”这个字,如果在学生的语境中,“数学”一词出现的概率高于其他;而在政府公文中,“数据”一词出现的概率高于“数学”。正是这种概率计算,使得ChatGPT基于用户的提问,可以生成更加符合用户期望的语料。

ChatGPT生成内容的能力来源于其模型足够大,大到可以把人类所有知识压缩到一个巨大的网络中,然后根据用户提示,重组出一个新的语料信息。ChatGPT工作原理依然属于自然语言处理(NLP)范畴,通过神经网络以某种人类无法解释的方式压缩大量语料,然后输出重组后的自然语言。几千年人类文明的积累塑造了大语言模型在语料“理解”和输出上的“无所不能”。

无论是人类文明沉淀的内部数据,还是企业内部积累和维护的数据,这些数据均需要完成信息化、知识化,最终才能沉淀出人类特有的智慧。在大语言模型的生成式AI时代,数据的内在价值提取变得越来越容易,如何发挥好数据要素的价值将会是未来竞争的关键,其中技术的发展及其人类对工具运用的能力同样是关键。

人工智能基于人类产生的数据进行自我训练,在大语言模型之前就已经被成功应用。例如,2016年Alpha Go击败韩国围棋天王李世石;2017年5月Alpha Go击败中国顶尖棋手柯洁;同年10月,基于规则自学习的AlphaGo Zero以100比0的成绩击败老版本Alpha Go。AlphaGo Zero基于规则训练的人工智能已经远远超过了基于人类棋谱训练的人工智能。特斯拉汽车自动驾驶中启用了仿真模拟来实现各类驾驶场景模拟,从而加强了自动驾驶模型在各种场景下的识别能力,远比基于常规的天气、路况训练的模型要强大得多。如果大语言模型用这类机器模拟生成的数据进行训练,大语言模型的能力也将会有新的突破。但无论怎样,最基础的数据依旧是人类提供的,毕竟人类语言不同于只有一套规则的围棋。因此,在大语言模型时代,数据将会变得比以往更有价值。

4.2 数据要素价值发挥关键路径

自纸张发明之后,信息记录的方式,传播的范围均发生了巨大的变化。西方的哲学思想可以传播至今,中国历史文化延续数千年,第一、第二次世界大战依然记忆犹新,这些都是人类记录和传播信息的丰功伟绩。自计算机和计算机网络发明以来,以数字方式表达的信息的计算和传播速度更是产生了根本性的飞跃。那么,在今天这个时代,什么样的数据更具有价值?哪些因素影响数据作为生产要素的价值发挥?数据要素价值发挥如何实现乘数效应呢?

4.2.1 影响数据要素价值发挥的关键因素

进入信息化时代以后,人类生产数据的速度呈指数级增长,大语言模型更是把机器生产数据的速度推上一个新高度。那么,数据作为生产要素,哪些因素会影响到其价值发挥呢?

(1)时效性是影响数据价值的一个重要因素

人处理信息和数据的能力非常有限,因此,人类更喜欢接收和处理最新的信息和数据。而数据作为生产要素,尽管大部分时候可以由机器来处理,但数据处理的结果最后总还是要作用到人的身上。因此,数据的时效性会是影响具价值发挥的一个重要影响因素,这也是人类避免信息过载的最佳选择。比如,除了气象史领域的专家,对于大部分人而言,当日所在地的天气情况就远比100年前当地的天气情况更有价值。

一般而言,数据越快得到处理,其价值就越大。历史上美国股市曾经因为西海岸能够比东海岸的交易所更早得到最新的股票价格而被指控泄密,因为即使是光纤通信也有数十毫秒的延迟。美国股市的高频交易已经把数据的时效性发挥到了极致,这也正是时效性在数据要素价值极致发挥方面的表现。金融行业推荐性标准《证券公司核心交易系统技术指标》(JR/T 0292-2023),该标准从左侧到右侧的延时在不同类型的系统中定义为8~10毫秒。由此可见,金融行业对数据的时效性要求之高。

证券公司核心交易系统参考架构图

数据如何高效利用,发挥其最大的价值,也决定于数据收集和数据被允许使用的方式。还是以交易撮合为例:在金融场景中,证券交易所是完成交易撮合的场所,各证券公司代理用户完成报价,反馈交易结果。在这个过程中,报价数据从证券公司转移到了交易所的撮合系统,最后信息被返回证券公司。因为这个过程不涉及其他隐私数据,撮合过程顺利进行。如果把证券交易所换为数据交易所,在证券公司考虑数据安全的情况下,证券公司就会要求数据交易所为其交易建立一个专区,完成交易后,清除数据计算过程数据。数据交易过程还涉及非标准算力问题,这比交易撮合复杂得多。因此,数据要素利用过程涉及数据安全、计算算力、数据传输等影响数据处理时效等诸多因素,需要逐一解决,并不断优化。

(2)数据质量是影响数据价值的另外一个因素

正如汽车质量会影响汽车市场发展一样,数据质量同样是影响数据要素市场是否能够存在和健康发展的关键因素。数据质量受数据来源的可靠性、数据记录的规范性和数据治理水平等因素影响。

确保数据质量无外乎有两种途径,

第一种是采集来的数据本就是高质量的,例如淘宝的交易数据、美团的外卖数据。这类数据因为涉及人类衣食住行的交易,因此在产生时就携带了用户与系统交互过程的准确且完整的数据,如双方交易的商品、价格、配送地址、用户信息,甚至支付信息。这类数据的来游是可靠的,记录也是规范的,因此质量很高。

第二种是通过数据治理相关技术完成数据质量的提升,如数据补全、数据清洗等技术,使得已收集的数据质量得到改善。企业可以通过制定数据标准和规范,提升内部数据治理水平,从而提高数据质量。

数据的重要作用是为行动提供有益的指引。如果因为数据质量问题而导致行动目标发生偏差,将会极大打击市场信心,甚至有可能导致市场崩塌。那么如何衡量数据质量呢?一种方法是静态质量评估,另一种方法是动态质量评估。

静态质量评估采取类似1S0 9000质量管理体系或3C认证等标准,从数据的规范性、数据产生和数据管理过程等方面进行评估。静态质量评估方法可以确保在数据要素市场交易的数据符合最基本的品质。

动态质量评估有赖于同类数据商品形成相互竞争的局面,从而通过数据要素市场建立起正反馈机制。如果多个第三方运营公司在确保信息安全的前提下完成数据治理工作,那么所形成的数据商品将会形成竞争,竞争内容则包括了数据治理水平、数据服务提供效率等,从而只有质量较好的服务商可以生存下来。

(3)数据体量同样是数据价值的一个重要维度

除数据的时效性和质量之外,数据的体量同样是数据价值另外一个重要的维度。随着人工智能对数据中信息和知识的提取能力变得越来越强大,通过汇聚大量的数据解决特定领域的问题,对发挥数据内在价值就变得非常关键。在同等数据质量的前提下,汇聚的数据量越大,对特定领域问题的解决针对性就越强。

然而,数据体量受存储、网络、算力等诸多因素限制,更为重要的是数据权属特性会制约数据体量的进一步增长。如果某机构汇聚了全国所有人口实时数据、运营商活动数据,甚至手机位置数据,那么个人隐私将无从谈起。比如在新型冠状病毒感染疫情期间,全国人口位置活动信息在防疫中就起到了关键作用,但这种数据也将每个人的位置信息暴露无遗。既要大数据体量,又要高数据安全,这是数据要素价值发挥过程中不得不平衡的两个互相矛盾的方面。

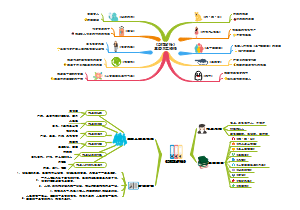

4.2.2 数据要素价值发挥的乘数效应

数据一般分散在各主体内部,通过数据收集、治理和利用,可以带来一定的价值。当数据量增长到一定程度后,数据之间的关联性和复杂性也随之增加,从而有可能产生涌现现象,新的价值和机会也会随之出现。当数据作为生产要素在市场上交易时,数据的价值也将随着使用用户数量的增加而呈现出乘法效应。

数据要素价值发挥的乘数效应逻辑示意图

假设机构A为构建身份认证服务与三大运营商分别签署了协议。但运营商考虑信息安全问题,只提供结果核验查询服务,按笔收费。机构A通过封装三大运营商服务接口,在阿里云出售该项认证服务,按笔付费。由于机构A提供了更好的用户体验,这使得其用户无需考虑用户归属运营商细节,因此可以合理向用户收取附加值费用。假设机构B基于机构A的身份认证服务开发了另外一个付费类应用,要求用户每月进行一次身份确认核验,那么机构B间接使用了运营商提供的数据服务,使得运营商还可以获得额外的数据服务的价值。

大部分数据要素价值创造很难像上图所示那样形成明确的数据服务链条,这会导致数据服务无法获得两次以上组合后的数据服务价值,也会阻碍数据要素价值的有效发挥,降低数据要素供给动力。在上述例子中,如果付费类应用机构基于该项认证服务提供专属服务时,缓存认证结果,后续只需要通过手机短信核验用户与手机的绑定关系,这就使得该机构在比较大范围的时段内无需再次付费认证。虽然身份三要素(姓名、手机号和身份证号码)存在更新的可能性,尤其是手机号码,但一般情况下在三个月周期内身份三要素还是有一定的稳定性的。一般来说,人们活动的数据信息都有一定的稳定性,比如信用分,一般情况下变化很慢。

然而,在企业信贷场景中,各银行对客户贷款逾期的情况极其关注。银行希望在第一时间掌握客户逾期情况,使具先于其他银行收回本金或及时止损。尽管手机绑定身份的数据和信贷逾期的数据都是同一个人的,但因为不同主体对数据变化的不同偏好,出现了时间错配问题。

在线下门店开展客户营销时,进入商圈的客户是精准营销的重要目标(暂且先不考虑客户位置隐私问题)。这类基于客户位置的数据服务如果能够开放给门店,其服务价值是显而易见的。比如线下生活的美团APP,通过位置信息就实现了O2O(Online - to – Offline)场景下的广告精准营销。又比如基于运营商信号塔的用户信息,商圈也可以实现线下场景的精准营销。美团基于历史用户数据,在封闭的体系中,基于位置信息和喜好标签也可以实现精准推荐。在非美团可覆盖的场景中,基于用户和位置信息,还需要基于门店积累的客户标签数据才能实现精准营销。这类位置空间数据因为标签缺失,出现了空间错配问题。数据时间错配和目标客群的空间错配,阻碍了数据价值乘数效应发挥。

国家对数据要素价值的乘数效应发挥提出了更明确的表述。国家数据局在《“数据要素×”三年行动计划(2024-2026年)》提出:“数据要素×”行动就是要通过推动数据在多场景应用,提高资源配置效率,创造新产业新模式,培育发展新动能,从而实现对经济发展倍增效应。国家数据局从三个方面推动数据要素乘数效应,

一是从连接到协同,通过数据要素作用其他要素,找到企业、行业、产业在要素资源约束下的“最优解”;

二是从使用到复用,推动各行业知识的相互碰撞,创造新的价值增量;

三是从叠加到融合,推动不同领域的知识渗透,催生新产业、新模式。

数据要素价值发挥实现乘数效应的关键是数据要素与其他要素的协同、复用和融合,创造出新价值。通过技术手段,不断提升数据的实时性和质量,增大数据体量,并不断丰富应用场景,确保数据服务方可以获得应有的价值。这是数据要素价值发挥的关键路径。

4.3 数据要素市场经济逻辑新设想

上面的讨论还遗留了一个难题,即数据要素价值的时间和空间错配。这类问题从根本上来说,是数据的供给是否足够快、足够好和足够多,如果满足这三个条件,那么经过技术处理,数据供给方面大量无法实现的需求均可以得到满足。当然,还需要解决数据权属、数据安全和用户意愿间题。

4.3.1 数据要素市场经济逻辑

数据要素市场通过价格机制和竞争来调节资源配置,让数据配置到它更应该被配置的地方,成为促进数据价值发挥的重要环节。国家在政策层面通过政策设计和制度安排推动数据要素市场发展,数据资源持有权、数据加工使用权、数据产品经营权“三权分置”的数据产权制度框架有利于数据要素市场的形成。“三权分置”还可以让专业的人干专业的事,使得不同主体可以在数据要素价值发挥的不同阶段、不同层面、不同环节贡献专业的力量。数据要素市场提供了供需双方基于自身利益最大化进行博弈的平台,让市场各主体在安全性、便利性、收益率等方面权衡。

诺贝尔经济学奖得主乔治·阿克罗夫在其《“柠檬”市场:质釐不确定性与市场机制》的文章中提出了一个假设,如果二手汽车市场的汽车质量不均匀,买家给出的意向最高价格就会低于市场中质量较好部分汽车的价格,导致这个市场中质量好的玩家自动放弃市场。如果质量好的汽车卖家离开市场这个信息被买家知道,买家还会进一步降低意向价格,从而继续驱逐拥有质量相对好的汽车卖家,最终导致这个汽车市场崩溃。以上困境产生的根本原因是“柠檬”市场中买家不知道每一件商品具体的品质,从而尽可能低地给出市场交易价格。这篇文章之所以重要,是因为作者提出了人类社会在交易时遇到的一种天然约束,即“人与人之间的互信是如何建立的”这个问题。《薛兆丰经济学通识》提到有以下一些方法来帮助解决这个问题,包括多次交易、第三方信任背书、通过增加附加成本发出信号、以品质三包替代质量检验、以延保合约甄别用户、以共享合约保障品质等。这些是目前在广泛应用的建立互信的方法,比如二手车市场通过店面装修、售后服务、质量保证等方式与用户建立信任关系,确保市场可持续。由上可知,市场的建立除了需求之外,还需要确保参与市场的主体具备相应的知识,以及相对透明的信息。

数据交易市场的建立与二手车市场类似,需要有交易目标,也需要对商品定价。然而数据交易市场建立所面对的困难比二手汽车市场要多得多,主要表现在以下几个方面。

(1)数据定价具有主观性

大多数情况下,数据在没有被第三方使用过时,很难形成具体的定价。一是数据很难像玉米大豆等标准化程度高的商品那样,通过大量交易形成能够被市场接受的价格。二是数据在不同应用场景所发挥的作用不同,这导致数据定价更加困难。

(2)数据质量很难界定

虽然通过一些技术手段,可以对数据质量给出相应的度量,但是数据质量和价格一样,在需求未定的情况下,数据质量的好坏并不能被显现出来,或者说,能够被度量的数据质量,并不会完全决定其内在价值。只有当数据质量问题已经影响到数据价值发挥的时候,质量才是最终问题。

(3)数据加工工艺不确定

开发工艺也是数据与其他商品不同的地方。数据要素就类似于原油和汽油,不经过炼油厂的开发,石油的价值就很难体现出来,不经过相关数据加工工艺的开发,数据的价值也很难发挥出来。但是,数据不同于石油,石油的加工工艺可以是标准化的,但数据的加工工艺却是非标准化,是基于应用场景而定义的。数据价值的发挥需要另辟蹊径。

如果假设数据要素按“三权分置”处置,数据资源持有方购置数据加工装置,允许第三方拥有其数据加工使用权,并控制数据产品经营权。在这个界定下,数据持有方只是让渡了数据加工使用权,如果数据加工使用的过程可以保障安全,并在有效监管的情况下,数据持有方将会有足够的动力和信心开放数据共享。这里的关键改变是数据持有权和加工使用权的分离。数据加工使用权是数据持有方给数据需求方提供按需加工的一种权力,使得数据可以按照需求方的要求完成定制化加工,形成数据价值化链路。由于数据本身具备可复制性,数据方并不会因为让渡数据加工使用权而损失数据持有权益,反而因为其灵活的数据服务能力,激活了数据需求方的需求。

4.3.2 数据市场与数据集市

只有各参与方通过利益博弈后实现共赢,一个稳定的市场才会形成,这个市场也才会长久。而供给和需求的差异化,是市场形成的前提。因此,数据集市有可能优先数据市场先发展起来。正如目前既有跳蚤市场,也有大型超市,因为它们面对的人群和解决的问题都不同。跳蚤市场是基于社会特定群体生存能力的差异化交换需求而建立的市场。跳蚤市场中的大部分交易是熟人之间的重复博弈,建设门槛较低,只要有一定量的需求,跳蚤市场就会出现,因此其地域和规模也都极为有限。而大型超市是在小市场的基础上汇聚形成的,大型超市是市场机制成熟的一个重要信号--商品具备明确的价格体系和监督机制,可通过规模化提升商品流通效率。

数据要素市场的形成需要时间,需求也需要一个激发过程,基于此,数据集市大概率会优先数据市场先发展起来。在数据集市交易模式趋于成熟,形成一定规模后,数据市场才大概率会形成,而且会以面向不同行业的多层次市场的形式出现。正如今天既有大型综合超市,也有专业的大卖场,还有多层次的批发集散市场一样。

这里我们以鸡蛋作为数据要素的对照例子来说明数据要素市场的工作逻辑。

在菜市场有卖鸡蛋、西红柿、茶叶的商铺,也有卖蛋炒饭、茶叶蛋和用微波炉加热的餐馆。这里我们假设鸡蛋、西红柿和茶叶为数据资源,蛋炒饭、番茄炒蛋和茶叶蛋属于数据产品,而蛋炒饭、番茄炒蛋、茶叶蛋和用微波加热鸡蛋的过程就是数据加工的过程。

做蛋炒饭的餐馆需要到商铺那里购买鸡蛋,然后做蛋炒饭出售。商铺也需要从别处购买鸡蛋和西红柿。卖茶叶蛋的餐馆也需要从商铺那里购买鸡蛋和茶叶做茶叶蛋出售。因为用微波炉加热鲜鸡蛋可能导致鸡蛋爆炸,因此,卖鸡蛋的商铺老板需要确认购买鸡蛋的餐馆老板购买鸡蛋的理由,以防止可能发生的安全事故。

由于蛋炒饭、番茄炒蛋和茶叶蛋是餐馆的绝活,餐馆老板总不能在卖鸡蛋的商铺老板面前现场证明其安全性。为此这个商铺老板只需要知道餐馆老板使用鸡蛋的大致流程即可,比如做蛋炒饭的餐馆老板足用鸡蛋和米饭做原料,用鸡蛋炒饭;茶叶蛋餐馆老板是用水煮鸡蛋;而微波炉餐馆老板想直接微波炉加热鸡蛋。这样鸡蛋商铺老板就获取了拒绝出售鸡蛋给微波炉餐馆老板的理由。

上述过程,卖蛋炒饭、茶叶蛋的餐馆老板在没有透露加工细节的情况下购买到了受到商铺老板监管的鸡蛋,而微波炉商铺则被拒绝。

上面这个鸡蛋“小集市”展现了通过数据要素集市解决“鸡蛋”数据要素价值发挥过程中的几个问题。

一是通过数据源对数据加工方的审核和监管,避免了数据被用于非法用途,保护了数据安全;

二是数据加工方在监管的情况下没有透露加工的工艺参数给数据源方,保护了数据加工方的劳动成果;

三是数据源可以为多个不同的数据加工方提供数据服务,一份数据可服务多个主体,获得多方价值;

四是数据需求方可以使用多个数据源和多个已加工的半成品,且利益分配链条清晰可见,加工后商品的价值包含所有数据参与方获得的价值。

这个“小集市”的运作模式体现了数据要素经济模型运行的基本流程,各参与方按照分工,实现多方共赢。

4.4 数据安全流通理论基础

4.4.1 数据安全三角问题的产生

在数据要素流通中,有数据拥有者和数据使用者两大主体,分别掌握数据和数据加工算法。如果与传统生产要素流通场景类比,数据就对应了生产资料,而数据加工算法就对应了生产工具。在数据要素市场中,数据的安全性得到了最大程度的关注。然而,正如生产力的发展离不开生产工具的改进,数据加工算法同样有隐私与安全需求。数据安全流通并不是一个单边问题,而是一个复杂的多边问题。综合数据拥有者和数据使用者的需求,我们可以自然构建出数据安全流通的三角问题。

数据安全三角问题

(1)数据的完整性和隐私性

数据的完整性是指原始数据正确完成预处理,没有发生恶意篡改,同时如果提供错误数据,则满足不可抵赖性。数据的隐私性是指原始数据不以任何形式泄漏,这个泄漏既包括原始数据本身,也包括原始数据的相关统计学特征。

(2)算法及参数的完整性和隐私性

处理数据的算法可以进一步细分为算法和参数两部分。算法的完整性是指算法本身被严格且正确地执行;算法的隐私性是指数据计算和操作过程不泄漏任何信息。参数的完整性是指参数以正确方式生成、保存和使用;参数的隐私性是指计算过程不泄漏任何信息。因为在很多场景下,参数不但决定了计算效果,也会涉及核心商业机密。

(3)计算结果的完整性和隐私性

计算结果的完整性是指结果未被恶意篡改,是原始数据输入算法后经过运算得到的结果;计算结果的隐私性是指其公布范围可控,范围由实际业务场景决定。

数据安全三角问题让人自然联想到区块链不可能三角问题, 二者虽然涉及的内容不同,但是内涵一致,即“三个角”很难同时得到满足。

我们以淘宝推荐系统的模型训练场景为例进行说明。

淘宝使用用户的消费数据进行推荐系统训练,以便能够精准地在APP首页为用户展示其感兴趣的产品,从而提升交易额。

在该场景下,用户的消费数据淘宝是直接能够获取的,因此数据的隐私性并没有保证;

如果根据数据安全法,对用户的浏览数据进行安全保护且并不提供给淘宝,那么为了确保推荐系统训练的完整性,淘宝需要把算法给到用户侧,由用户在本地训练并将训练结果返回给淘宝。

这种方式虽然保证了用户数据的隐私性,但是淘宝算法的隐私性则无法保证,同时训练结果的可信性也无法保证,因为淘宝无法确认用户确实是在真实数据上进行了模型训练。

因此,数据隐私性、算法隐私性和计算结果的可行性,是数据安全中的三角问题,同时达到非常困难,在一些场景下甚至是不可能实现的。

4.4.2 数据安全三角问题的数学抽象

为更好地描述数据要素场景中的安全问题,本小节对数据安全三角问题进行数学抽象。高度数学抽象的好处是能够剥去不同应用场景的外衣,将共性内容进行精确提取,从而有效凝练科学问题。

数据安全三角的数学抽象

数据安全三角问题可以抽象为数学公式fp(x,w)=y,其中f是处理数据的模型/算法,p为模型/算法的参数,这两个参数为数据使用者所掌握;w为原始数据,为数据拥有者所掌握;y为计算结果,由数据使用者最终掌握;x为公共输入,即数据处理过程中输入的公共可知的内容。经过数学抽象之后,数据要素场景下不可能三角问题就可以表述如下:

数据拥有者输入w,数据使用者输入f和p,x为公共可知;

完成计算之后,数据拥有者获得f和p的概率是可忽略的,数据使用者获得w的概率是可忽略的;

数据使用者获得y,且满足等式fp(x,w)=y。

4.4.3 数据安全三角问题的求解方法

数据安全三角问题并没有放之四海而皆准的求解方法,而是在与实际应用场景的结合中,综合考虑场景中的信任假设和业务逻辑,提出适用于特定场景的解决方案,从而规避数据安全三角问题的约束,实现数据价值发挥的同时满足各方数据隐私需求。总体而言,有两个基本的求解思路,即折衷法和技术法。

(1)折衷法

折衷法是计算机领域常用的一种问题解决方法,常用以处理计算复杂度和通信复杂度的平衡,即在计算资源受限场景下,通过提升通信复杂度从而降低计算复杂度,或在通信资源受限场景下,通过提升计算复杂度从而降低通信复杂度,也就是在计算与通信之间进行折衷(Trade-off)。这个思路同样适用于解决数据安全三角问题。在不同的场景下,数据的隐私需求和算法的隐私需求是存在强弱区别的,因此在不能够兼得的情况下,就要“两害相权取其轻”,完成数据隐私和算法隐私的折衷,实现该场景下的最大收益。

具体而言,在数据隐私性需求强烈的场景,可以采取“数据不动算法动”的思路,将算法传输给数据拥有者,由数据拥有者在本地输入原始数据完成计算后,将计算结果返回数据使用者。这样虽然牺牲了算法的隐私性,但是保证了原始数据的隐私性。

在算法隐私性需求强烈的场景,则可以采取相反的思路,即“算法不动数据动”,将数据输入给算法拥有者并完成相关的计算。这种方法虽然牺牲了数据的隐私性,但是保证了算法的隐私性。而计算结果的可信问题,则取决于特定场景下数据拥有者和数据使用者之间的信任关系,以及是否存在第三方可信机构参与,甚至可以引入经济激励机制保证计算结果的可信。

因此,使用折衷法解决数据安全三角问题的核心在于对场景的深入理解和剖析,在资源受限条件下,在数据隐私、算法隐私和计算结果可信之间折衷,实现特定场景下的收益最大化。

(2)技术法

技术法就是通过引入新一代信息技术,解决数据安全的不可能三角问题。与折衷法不同,技术法致力于同时解决数据、算法和计算结果的完整性和隐私性问题,其基木思路是将数据安全三角问题中的痛点与新一代信息技术的技术特征进行对应,从而一一攻破。

完整性保证。

数据和计算结果的完整性保护需求和区块链的不可篡改性对应,因此可以将数据、算法和计算结果进行指纹链上存储与承诺,从而有效保证其完整性。而算法的完整性则与区块链公开透明的特征对应,因此算法的执行过程可以基于链上运算实现,从而保证其可验证性。当然在某些场景下需要结合隐私合约的技术(Confidential Smart Contract)以防止核心计算流程外泄。

隐私性保证。

隐私性需要依赖隐私计算技术去实现,如安全多方计算、同态加密和联邦学习等技术。在隐私技术环境下,数据处理的对象不再是明文数据,而是经过秘密分享或同态加密后的“密态数据”,从而防止计算过程中数据外泄。同样在模型训练过程中,不同数据集上的训练参数基于同态加密完成聚合,从而保证模型参数的隐私性。

计算结果可信性保证。

计算结果的可信,可以基于零知识证明实现。通过构造计算过程电路,结合链上数据承诺,即可生成计算结果正确性的零知识证明,证明该结果是“正确数据在正确算法下的计算输出”。

综合以上内容,技术法貌似能够解决数据安全三角问题,而不像折衷法在数据安全三角问题上进行平衡和折衷,但是该方法也存在其制约条件,即技术的应用能力问题。新引入的技术(如隐私计算、零知识证明)往往技术复杂度较高,使用门槛较高,从理论到实用还存在一定的距离。此外新技术的使用也会带来较大算力消耗,这导致这些新技术在某些场景下并不适用。因此,技术法和折衷法应该根据应用场景需求综合使用,最终有效解决数据安全三角问题。

第五章 数据要素流通与数据安全技术

数据要素价值发挥离不开数据流通、应用和运营,且数据安全技术是数据流通的核心保障。在数据要素流通领域存在“供不出、流不动、用不好、不安全”的问题,这些问题阻碍了数据要素高效流通、应用和运营。

数据“供不出”主要表现在:

一是数据权属不清晰,确权难,导致数据共享动力不足;

二是数据种类复杂,缺乏统一的数据口径、数据字典、数据标准和信息模型;

三是数据质量不高,缺乏数据治理,导致数据质量与实用性不高。

数据“流不动”主要表现在:

一是跨部门、跨行业、跨领域,壁垒较高,缺乏协调机制;

二是数据基础设施不完善,网络、算力、数据流通和数据安全基础设施不完善。

数据“用不好”主要表现在:

一是专业技术能力不够,无法快速、有效、安全支撑数据应用;

二是企业的数据应用水平不均衡,数据深度分析与优化占比不高;

三是缺乏数据应用场景创新土壤,可供使用数据体量不够,数据获取、加工、分析场景不足。

数据“不安全”主要表现在:

一是数据流通技术普及不够,存在数据泄露风险、商业秘密保护等问题;

二是数据可信支撑要素应用率低,数据交付无法控制和监管数据流通效率,安全和成本难以兼顾。

针对上述问题,本章基于国家数据局的规划和编者的理解,简要介绍数据基础设施的构成,并重点介绍数据流通基础设施和数据安全基础设施中的关键技术。通过本章可以深入了解数据流通基础设施和数据安全基础设施的技术细节,以及为何需要这些技术才能构成基础设施的关键能力,并支撑上传数据要素价值发挥的相关能力。

5.1 数据基础设施

随着国家数据局的挂牌成立,中国数据事业止在迎来崭新阶段。数据作为关键生产要素获得了全新重视,更加成为推动数字经济发展的关键战略性资源。国家数据局局长刘烈宏曾提出数据基础设施的概念:数据基础设施是从数据要素价值释放的角度出发,在网络、算力等设施的支持下,面向社会提供一体化数据汇聚、处理、流通、应用、运营、安全保障服务的一类新型基础设施,是覆盖硬件、软件、开源协议、标准规范、机制设计等在内的有机整体。

数据基础设施主要包括网络设施、算力设施、流通设施以及安全设施,它们构成了数据流通过程中数据处理和管理的核心柜架。其中,

以5G、光纤、卫星互联网等为代表的网络设施为数据提供高速泛在的连接能力,

以通用、智能、超级算力为代表的算力设施为数据提供高效敏捷的处理能力,

以数据空间、区块链、高速数据网为代表的数据流通设施打通数据共享流通堵点,

以隐私计算、联邦学习等为代表的数据安全设施保障数据的安全。

数据的四大基础设施共同确保数据在流通过程中能够高效、可靠地传输和处理,并保证数据的安全性和完整性,为数据资源开发利用落地和创新提供了稳固的基础支持,全面促进数字中国、数字经济、数字社会高质量发展的平台和载体。

5.1.1 网络设施

数据要素流通过程中的网络设施是指在数据要素从源头到目的地传输和流动过程中所涉及的网络基础设施和设备,这些网络设施包括各种网络设备、通信设备、传输介质和网络协议等,例如5G、光纤、卫星互联网等,它们共同构成了数据要素在网络中传输的基础框架,为数据提供高速泛在的连接能力。

在构建网络设施过程中,

首先,需要整合5G、光纤、卫星互联网等代表性的网络设施,以提供数据高速泛在的连接能力;

其次,建设高速稳定的数据传输网络,确保数据能在不同地域和环境下进行快速传输与交换;

最后,需要加强网络安全防护,网络设施中可采用加密技术和安令协议,保障数据在传输过程中的机密性和完整性。

上述方式构建的网络设施将为数据提供可靠的连接支持,促进数据要素基础设施的高效运行与发展。

网络设施在数据要素基础设施中扮演着至关重要的角色,它们承担着数据传输、通信、带宽管理和安全保障等重要功能,构建和优化网络设施是数据要素基础设施建设的关键环节。

网络设施的稳定运行和高效性为数据的高效流动和可靠传输提供了坚实支撑,加速了数据的流动和共享,推动了数字化时代的发展和普及,对于促进经济社会的发展具有重要意义。

5.1.2 算力设施

数据要素流通过程中的算力设施可以被定义为提供计算能力支持的设备和基础设施,更注重实时处理和流动性,一般需要具备高并发、低延迟的特性,同时也需要适应不确定性场景、强调数据安全、采用分布式流式计算架构,以满足动态数据流动的需求,与传统的算力设施存在较为明显的差异。

建设数据要素基础设施中的算力设施时,需要考虑算力的通用性,包括通用处理器、通用计算节点等,能够满足各类数据处理需求,提供灵活多样的计算能力。其次,基于数据要素流通中数据治理、加工与分析的需求,算力设施可引入智能化算法,能够实现数据的智能分析、挖掘和处理,提高数据处理的效率和准确性。另外,为满足数据共享交换过程中大规模数据处理和复杂计算任务的需求,算力设施需提供强大的计算处理能力。因此,算力设施通过整合超级计算资源和高性能计算设备的方式,构建超级算力设施,全面支持数据要素基础设施中的数据处理、分析和决策任务,实现对大规模数据的快速处理和实时响应。

算力设施中的通用、智能及超级算力特性,为各参与方提供高效便捷、安全可靠的数据要素存储、计算、分析能力,有效推动数据处理环节实现高效率、低成本、高智能的特性,推动数据驱动决策和创新发展,促进数据要素基础设施的构建和发展,助力数字化转型和智能化发展的实现。

5.1.3 流通设施

数据要素基础设施中的流通设施,是指为促进数据共享、传输和交换而构建的基础设施。它包括各种技术和标准,用于确保不同数据要素(如数据集、数据服务、数据产品等)在不同系统、组织和平台之间能够安全、高效地流通和交换。这些流通设施可以涵盖数据传输协议、安全加密技术、数据标准化方法、数据接口规范等,旨在打破数据孤岛,促进数据的互联互通,从而支持数据驱动的创新和应用发展。

首先,流通设施的建设需要整合数据空间、区块链、离速数据网等代表性的数据流通设施,以打通数据共享流通的堵点;

其次,通过建设统一的数据接入和交换平台,实现多源数据的集成和共享,促进数据在不同系统和组织之间的流通和互联;

最后,基于安全可控的数据流通机制,引入区块链等技术确保数据传输的安全性和可信度,同时推动数据开放共享和合规流通。

上述方式建设的数据流通设施将有助于加强数据共享和流通,实现数据在不同主体间“可用不可见”“可控可计量”,为不同行业、不同地区、不同机构提供可信的数据共享、开放、交易环境,有效提升数据流通环节的安全可靠水平,推动数据要素基础设施的健康发展和应用创新,为经济社会发展提供更为坚实的数据基础支撑。

5.1.4 安全设施

在当今数字化社会中,数据的安全隐私保护已经成为至关重要的议题。在数据要素基础设施中,安全设施的作用愈发凸显。安全设施通过引入先进的隐私计算、联邦学习等手段,可有效保障数据的隐私与安全,还能确保数据在流通过程中的完整性和可靠性。

数据基础设施中的安全设施的建设方案可以结合多种技术手段和安全机制,全面保障数据要素流通的安全性。

首先,在建设安全设施过程中可以采用隐私计算技术,实现对流通共享中的数据进行加密处理,确保在数据传输和存储过程中得到保护;

其次,安全设施通过结合联邦学习等技术,实现数据的分散存储和模型训练,避免集中式数据存储带来的风险,同时确保数据的隐私性和安全性;

最后,在安全机制方面,通过建立严格的访问控制机制和权限管理体系,限制数据的访问范围,防止未经授权的数据泄露和篡改。

安全设施的建设有助于各参与方建立数据安全保障体系,推动各参与方在数据合规性方面形成最佳实践,贯穿数据生命周期全流程,确保数据的可信性、完整性和安全性,更能推动跨组织间安全数据交换与合作,为数据要素流通提供了坚实的保障和支持,促进数字化社会的安全发展与创新应用。

5.2 数据空间

数据空间通过定义数据归属权,以及以空间为主体参与数据流通的一套机制,服务数据要素流程应用场景。通过数据空间宣示数据主权的同时,结合区块链技术实现分布式、可信的数据空间网络,再结合高速数据网络支撑数据高效、安全、可信流通,从而支撑起数据流通基础设施。

5.2.1 数据空间定义

据IDS(国际数据空间协会)定义,数据空间是一个虚拟空间,它基于通用协议和格式以及安全可信的数据共享机制,为数据交换提供了一个标准化框架。《欧洲数据战略》中提到,为实现欧洲单一数据市场,需建设欧盟数据空间,即一种能保障企业数据、公共数据、个人数据有序流通应用的技术体系。其核心价值是赋予了数据提供方一种新型的权利--数据主权,即数据所有者保留对其数据的控制权,可以确定谁可以使用数据以及在什么条件下使用数据。数据空间作为数字化时代的一种新型数据管理和利用方式,正在逐步成为数字化转型的重要支撑。数据空间的诞生,象征着网络空间正在由“以计算为中心”向“以数据为中心”的转变,为数据的共享、交换和利用提供了更加便捷、高效的方式。

数据空间在欧盟、日本、韩国等均在跟进。2016年,工业数据空间协会(IDSA)成立;2019年更名为国际数据空间协会。2020年《欧洲数据战略》明确建设9 大数据空间(制造业、绿色化、交通、健康、金融等)。2024年,欧盟现有17大通用数据空间与46个行业数据空间,覆盖制造业、运输、金融、能源、农业等行业。

我国数据空间主要围绕可信展开。2022年,工业互联网产业联盟发布《可信工业数据空间系统架构1.0》。2023年,全球数商大会发布国内首个可信数据空间标准《可信数据空间系统测试规范》。2023年年底,国家数据局会同有关部门制定了《“数据要素X”三年行动计划(2024-2026年)》,指出要深化数据空间、隐私计算、联邦学习、区块链、数据沙箱等技术应用。

国家数据空间可以向下细分为行业空间、区域空间,形成多层次的数据空间,从数据全生命周期和基础设施的横向和纵向来看,又有分层、分类,实现不同的目标。

国内数据空间与数据基础设施关键

在数据空间中,数据的共享和交换需要遵循一定的协议和格式,以确保数据的安全性和可信度。这些协议和格式通常由国际数据空间协会等权威机构制定和维护,以确保数据空间的标准化和规范化。通过这些协议和格式,数据可以在不同的系统、平台和应用之间进行无缝交换和共享,大大提高了数据的利用效率和价值。除了协议和格式外,数据空间还需要建立安全可信的数据共享机制。这些机制包括数据加密、身份认证、访问控制等多种技术,以确保数据在传输和存储过程中不会被窃取、篡改或滥用。同时,数据空间的治理和监管也必不可少,需要建立相应的法律法规和监管机制,以确保数据空间的合规性和可持续性。

5.2.2 数据主权

数据空间是数据主权的一个重要概念载体。数据主权是指数据所有者对其数据的控制权和决策权,面数据空间就像法律文书一样,定义了数据的所有权和管理权。在传统的数据交换和共享模式中,数据往往由数据提供者完全控制,而数据使用者只能被动接受数据提供者的规则和限制。在数据空间中,数据主权强调数据所有者应有权利决定其数据的使用、分享和流通方式,同时保护其数据的安全和隐私。

数据主权的概念体现了数据所有者在数据交换和共享过程中的自治权和控制权,强调数据所有者在数据生命周期的各个阶段都应具有明确的控制和决策权限。这包括数据采集、存储、处理、共享和销毁等环节,数据所有者应能够自主选择数据的使用目的、范围和方式,以确保数据的合法、安全和有效使用。

在数据空间中,数据主权的实现需要结合法律、技术及交易三个维度,以保障数据所有者的权益和数据的安全性。这可能涉及数据共享协议的制定、数据安全技术的应用、数据治理机制的建立等方面,以平衡数据的开放共享和数据主权的保护之间的关系。

①法律层面:

法律应明确规定数据所有者对其数据的所有权,并赋予数据所有者决定数据使用方式的权利,通过相关法律法规,规定数据使用者需要获得数据所有者的明确同意,这样可以有效保障数据所有者的数据主权,防止数据被滥用或未经授权使用。

②技术层面:

基于加密、安全及数据访问控制等技术,可以确保数据在传输和存储过程中的安全性,保护数据所有者的数据免受非法获取和篡改,增强数据主权的实施效果。

③交易层面:

通过建立数据交易平台,为数据所有者提供一个公平、透明的交易环境,使得数据所有者能够更好地控制自己的数据流通和使用,从而增强数据主权。

总的来说,数据主权是数据空间中的重要概念,强调数据所有者应对其数据拥有最终的控制权和决策权,以推动数据交换与共享的可持续发展,并促进数据驱动的创新与应用。

5.2.3 数据空间内涵

数据空间提供了一个统一的环境,有助于有效组织、管理和交换不同来源、格式和结构的数据。其关键特征包括数据的标准化、互操作性和安全性,确保数据在跨系统和平台间流畅传输和共享。数据空间涉及数据所有权、数据隐私、数据安全、技术应用和交易机制等多方面内容,需要从法律、技术和交易三个角度进行全面考队和保障。借助数据空间,用户可更便捷地获取和利用数据资源,推动跨组织、跨行业的合作与创新,为数据驱动的应用奠定坚实基础,助力智慧型社会的构建。

在医疗领域,数据空间可以帮助医院和医生实现病历数据的共享和交换,提高医疗服务的效率和质量;

在交通领域,数据空间可以促进车辆、道路、交通信号等各种交通元素之间的数据共享和协同,提高交通的安全性和效率;

在金融领域,数据空间可以实现银行、证券、保险等金融机构之间的数据共享和交换,提高金融服务的便利性和创新性;

在工业领域,可信工业数据空间是基于数据使用控制、隐私计算、安全技术、存证溯源等技术综合构建的,遵从统一标准的,覆盖数据全生命周期的数据管控系统和价值生态体系,是实现数据要素高效配置的新型基础设施。

同时,数据空间还可以为企业和组织提供更加灵活和高效的数据管理和利用方式。通过构建数据空间,企业可以将分散在各个部门和系统中的数据进行整合和标准化,实现数据的集中管理和利用。这样一来,企业可以更加便捷地获取和利用数据,提高决策的科学性和准确性,进一步推动企业的发展和创新。

数据空间的出现,不仅为数据的共享和利用提供了更加便捷、高效的方式,也为数字化时代的发展注入了新的动力。随着数据空间技术的不断发展和完善,相信未来数据空间将会在各个领域发挥更加重要的作用,为社会的进步和发展做出更大的贡献。

5.3 区块链

区块链的概念来源于一位化名为“中本聪”(Satoshi Nakamoto)的学者2008年11月在密码学邮件组发表的论文《比特币:一种点对点的电子现金系统》。经过十几年的发展,区块链技术已趋于成熟,凭借其特有的运行机制,能够有效解决中心化系统中存在的单点故障、数据流转成本高和数据存储不可信等痛点,并正在重塑诸多行业的运行规则,也成为数字社会的核心底层技术。本节首先详细介绍区块链技术,包括其概念内涵、技术特征、安全与可信逻辑和关键研究领域,随后介绍区块链在数据要素领域的典型应用场景。

5.3.1 区块链的概念

区块链并不是一种单一的技术,而是分布式存储、点对点传输、密码学和博弈论等多种技术融合和创新的结果。工信部在2016年指导发布的《中国区块链技术和应用发展白皮书》将区块链的发展划分为两个阶段,分别对应区块链的狭义概念和广义概念。

(1)狭义概念

狭义上,区块链是一种按照时间顺序将数据区块以链条的方式组合成特定数据结构,并以密码学方式保证的不可篡改和不可伪造的去中心化共享总账,能够安全存储简单的、有先后关系、能在系统内验证的数据。在区块链发展的1.0阶段,其技术本质是一个具有鲜明技术特征的分布式数据库,因此也被称为分布式账本技术(Distributed Ledger)。

(2)广义概念

广义上,区块链是利用链式数据结构存储与验证数据、利用分布式节点共识算法生成和更新数据、利用密码学方式保证数据传输和访问的安全、利用自动化脚本代码组成的智能合约来编程和操作数据的一种全新的分布式基础架构与计算范式。广义概念和狭义概念最大的区别在于智能合约的引入,这也是区块链2.0相比1.0质的提升,区块链不再是分布式账本,而是进化为通用计算平台,由“记账”变为“算账”。

5.3.2 区块链的技术特征

(1)去中心化

去中心化是指区块链的运行不依赖中心化机构,所有节点权限对等,通过数学方式达成信任,共同维护系统正常运转。为了更加深刻地了解区块链“去中心化”的技术特征,我们将其与传统中心化系统和分布式系统进行对比。

在传统中心化系统中,往往存在一个管理员的角色,该角色负责系统的正常运行以及系统内部角色权限的分配,具有系统内最高甚至唯一的管理与控制权限,因此整个系统是中心化的运行模式。而在区块链中,并不存在一个管理员的角色,整个系统的管理权限进行了“分摊”,由区块链中的所有节点共同完成系统的运行和管理,具备明显的去中心化特征。

在分布式系统中,同样是由多个节点配合共同完成系统的运行,某种程度上也具备一定的去中心的特征。然而,分布式系统更多强调的是多节点参与,节点和节点之间是否对等是没有明确要求的,也就是说分布式系统中可能存在“多节点参与,单节点确认”的情况,这和区块链“多节点参与,节点对等”的设计形成差异。

(2)集体维护

集体维护是指区块采用特定的激励机制来保证系统中所有节点均可参与数据区块的验证过程,并通过共识算法来选择特定的节点将新区块涂加到区块链。具体而言,集体维护的内涵可以从系统决策和数据可用性两个层面进行剖析。

系统决策方面,除了新区块的添加是所有节点共同通过共识算法决定外,整个系统的核心参数也是由网络中的节点共同确定,比如区块链的大小、数字签名算法的类型、底层共识算法的类型等。区块链领域中经常提及的去中心化自治组织(Decentralized Autonomous Organization,DAO),本质上就是来源于区块链集体维护的技术特征。

数据可用性方面,区块链的数据并不是单一存储在某个节点,而是网络中每个节点都在本地存储完整的区块链数据,所有节点共同维护,且存储的数据是—致的。这就保证了数据的高可用性,离线和新加入的节点可以从其他节点迅速同步到最新的区块链数据,而数据丢久或损毁的节点也可以高效实现数据恢复。

(3)不可篡改

不可篡改是指写入区块链的数据无法修改,数据的完整性能够得到有效保护。这一点是区块链区别于传统数据库的核心特征,也是区块链能够实现数据确权和追踪溯源的内生能力支持。以下从两个层面来剖析不可篡改的技术内涵。

首先,不可篡改这一特征是由区块链底层的数字签名、链式结构和共识算法等技术共同保证。数字签名能够保证被签名数据的完整性;链式结构使得链上任意数据的修改都会引发“雪崩”效应,从而不满足区块链数据合法性的验证要求,防止数据篡改;共识算法则保证了区块链数据理论上无法“回滚”,因此随着数据所在区块深度的增加,被篡改的风险以指数级降低直至不可篡改。

其次,不可篡改并不意味无法对链上数据进行更新。在实际应用场景中,业务数据是存在更新需求的,即对已存证在区块链上的数据进行替代。这一需求与区块链不可篡改的特征并不矛盾,因为可以通过“追加”而非“覆盖”的形式完成数据的更新,既实现了当前最新数据的上链存证,又实现了数据修改历史的精准记录。

(4)用户匿名

用户匿名是指区块链的参与者以数字签名算法公钥作为身份标识,不会暴露现实身份。可以从两个层面去理解用户匿名:

首先,区块链原生的用户匿名是“伪匿名”,即链上数据并不直接反映用户现实身份,但是通过对链上数据进行归集并开展行为模式分析,是能够追踪到用户的现实身份。因此区块链领域才有隐私保护这一研究方向,通过复杂的密码学技术实现真正的“用户匿名”。

其次,用户匿名的范围与区块链的类型是紧密相关的。比如在联盟链中,节点是有准入条件的,需要共识节点对其身份进行认证审核后才能加入网络。因此,联盟链中的“用户匿名”更多的是业务层面的匿名性,而非对整个系统成员都具备匿名性。

5.3.3 区块链的安全与可信逻辑

(1)安全逻辑

区块链的安全逻辑体现在网络安全、数据安全和运行安全三个方面,三者相互作用,共同形成系统的内生安全。而这些安全性的产生则依赖于区块链本身具备的技术特征,具体介绍如下。

网络安全方面

区块链网络层使用对等网络协议(Peer–to–Peer networking,P2P),是一种在对等者(Peer)之间分配任务和工作负载的分布式应用架构。P2P架构天生具有耐攻击、高容错的优点。由于服务是分散在各个节点之间进行的,部分节点或网络遭到破坏对其他部分的影响很小,同时在部分节点失效时能够自动调整整体拓扑,保持其他节点的连通性。

数据安全方面

区块链数字签名、链式结构和共识算法的应用实现了不可篡改的技术特征,保证了链上数据的完整性,能够有效抵御数据的伪造和篡改;此外,集体维护的技术特征能够有效保证数据的可用性,具备高度的容错性,个别节点的宕机和数据污染,并不会影响整个系统的数据安全。

运行安全方面

区块链底层的运行逻辑严格遵循共识算法,只要满足共识算法的安全假设(如诚实大多数、拜占庭假设等),那么整个系统的运行过程就不受外部影响;同时智能合约也是链上数据的一部分,其运行逻辑受到数据安全的保障,不存在代码入侵和代码安全风险。

(2)可信逻辑

区块链的可信逻辑体现在数据不可抵赖性和计算可验证性两个方面。数据不可抵赖性保证了输入数据的可信,而计算的可验证性保证了数据处理过程的可信,二者共同决定了结果的可信,具体介绍如下。

数据不可抵赖性

是指任何参与方无法对已经承诺的数据进行修改操作,也无法进行数据的撤回或者否认橾作,本质上是由区块链不可篡改的技术特征决定。因此,区块链可以作为节点之间的可信信道,完成数据的交换与使用。相比在节点之间构建数据传输通道,以区块链作为数据载体能够有效提升交互的可信度以及稳定性,因此在一些学术论文中,区块链也经常作为公告板(Public Bulletin Board)的具体实例出现。

计算可验证性

是指发生在区块链上的运算过程能够被任意第三方进行验证,其本质来源于区块链公升透明的技术特征。首先,区块链上运算的载体为智能合约,而智能合约的代码是公共可见的,其承载的业务逻辑以及安全性是接受公共审计的;其次,智能合约代码的执行是在每个共识节点本地进行,之后各节点会将计算结果进行相互比对,比对一致后才作为最终结果写入区块链,因此智能合约的执行过程也是以分布式、可信的方式完成的。

5.3.4 区块链关键研究领域

目前区块链技术正处于成熟演进的过程,仍存在一定的缺陷导致其应用场景受限。为弥补这些缺陷,在学术界和工业界逐渐形成了四个主要的区块链研究领域,即可扩展性研究、共识算法研究、隐私保护技术研究和跨链技术研究,以下分别进行介绍。

(1)可扩展性研究

交易是区块链最基本也是唯一的事件类型,任何链上应用都依赖于发送交易去完成。因此业界常使用每秒处理交易的数量(Transaction Per Second, TPS)来衡量区块链系统的性能。比特币的TPS约为7,以太坊的TPS介于10到20之间。作为对比,Visa信用卡每秒处理交易约为2000笔,淘宝双十一交易的峰值约为每秒54万笔。显然现有区块链系统性能远远不能满足一些高频交易场景的需求。可扩展性研究的目标是最大限度地提高区块链的TPS。具体而言,根据所处区块链系统层级的不同可以将可扩展性方案分为Layer 0、Layer 1和Layer 2三类。

Layer 0方案针对区块链网络层提出,旨在通过提升P2P网络的传输效率来提高区块链系统的性能,通过在全球建立区块链数据路由网关并设置为区块链网络的骨干节点,其他节点连接这些网关完成交易数据和区块数据的同步。从而极大地提高了区块链P2P网络的传输效率,为上层性能的提升奠定网络基础。

Layer 1方案针对区块链链上提出,通过修改区块参数或者数据验证逻辑来提高区块链系统的性能,比如将区块大小由1M提高至32M和128M,增加了单个区块最大承载交易的数量,从而在出块时间不变的情况下提高了区块链的TPS,抑或将交易信息和非交易信息(即交易的数字签名)进行分离,广播的区块中只包含交易信息,从而增加了单个区块可容纳交易的数量,提高了区块链的性能。

Layer 2方案针对区块链链下提出,通过将交易转移到链下执行来提高区块链的性能,将用户资金在链上进行锁定,双方在链下完成资金转移后将凭证发送到链上进行结算,或者将链下交易压缩后打包上传到区块链,并利用欺诈证明(Fraud Proof)或者零知识证明保障其正确性,提高了区块链的交易验证效率。

(2)共识算法研究

区块链本质是由网络中所有节点共同维护的分布式账本。这些节点分布在世界各处,仅通过P2P 网络进行连接。因此就需要一种有效的机制去组织这些节点完成“记账”过程,保证全网仅有一条合法区块链。这一机制即为共识算法,它是区块链技术的核心组成部分,决定整个系统的可用性和安全性。共识算法解决的核心问题是记账权的分配,即决定每个高度区块的合法出块者。当前典型的区块链共识算法包括工作量证明、权益证明、委托权益证明和拜占庭容错。

工作量证明(Proof-of-Work,PoW)是最早的区块链共识算法,其核心思想是节点通过算力竞赛去竞争出块权,节点出块概率与其算力大小成正比,每个节点都有权提出区块,但是需要保证区块头的哈希值小于当前的目标值,只有满足这一条件的区块才会被其他节点验证通过并最终接入链中;

权益证明(Proof-of-Stake,PoS)是另一种被业界广泛接受并研究的共识算法,能够有效规避PoW高能耗的缺陷,其核心设计思想是链上权益越大的节点获得出块权的概率也越大,而背后的经济学原理在于权益越大的节点作恶的成本也越高,因此有更大的动机去严格遵守协议、提出合法区块、维护整个系统的安全;

委托权益证明(Delegated Proof-of-Stake,DPoS)与议会选举制度类似,即所有权益持有者经过层层投票选举得到一个董事会,最终由董事会的成员完成区块的生成和验证过程,因此DPoS可以理解为集中化的PoS;

拜占庭容错(Byzantine Fault Tolerance,BFT)能够在恶意节点存在情况下保证共识过程的一致性和活性,实现少量节点之间的高效共识,因此常应用于联盟链,它的安全基础为拜占庭假设,即所有参与共识节点中恶意节点数量不超过三分之一,而整个共识过程就是节点投票的过程。

(3)隐私保护技术研究

区块链是公共可访问的,即任何人都可以接入区块链网络并同步得到完整的区块链数据。这一特征在丰富区块链应用场景的同时,也为区块链的隐私保护带来严重风险。用户在区块链系统以账户地址作为其身份标识,通过将用户账户地址相关交易汇总并进行关联分析可以实现精确的用户画像。如果该用户与其他已知身份的地址发生过交易,那么有很大概率揭示其真实身份。隐私保护技术旨在借助混淆或者密码学手段去保护交易发送者和接收者的真实身份以及交易的真实金额。目前主流的隐私保护技术包括环签名、隐蔽地址和零知识证明。

环签名和隐蔽地址技术可以组合使用,从而隐藏发送者和接收者的真实身份。具体而言,交易的发送地址是一组地址,共同构成环签名的公钥集合,发送者的真实地址是这个集合中的成员,但是任何人无法判断具体为哪一个地址,而交易的目的地址是发送者为接收者生成的隐蔽地址,只有接收者能够进行识别并生成对应私钥;

零知识证明技术同样可以用于隐藏发送者和接收者的真实身份以及交易金额,用户可以将资金发送到屏蔽池(Shielded Pool)来对交易的内容进行保护,也可以随时从屏蔽池提取资金进行正常的交易,整个过程的合法性由零知识证明系统保证。

(4)跨链技术研究