导图社区 交直流混合微电网产学研平台数据治理与数据管理服务

- 8

- 0

- 0

- 举报

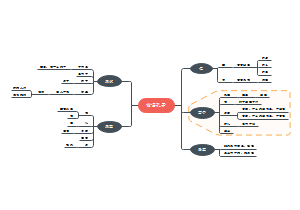

交直流混合微电网产学研平台数据治理与数据管理服务

这是一个关于交直流混合微电网产学研平台数据治理与数据管理服务的思维导图,涵盖了从数据采集到应用服务的多个层面,包括元数据管理、数据治理服务和数据共享审核等内容。

编辑于2025-04-09 00:52:01- 数据管理

- 数据共享申核

- 数据治理

- 相似推荐

- 大纲

交直流混合微电网产学研平台数据治理与数据管理服务

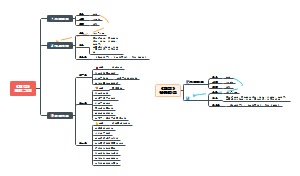

主从数据库建设

建立主从数据库(主从复制)的核心目的是实现数据冗余、读写分离和负载均衡。以下是通用的操作步骤,以及针对常见数据库(MySQL、PostgreSQL、MongoDB)的具体配置示例: --- ### **一、通用流程(适用于大多数数据库)** 1. **主库配置** - 启用数据日志(如二进制日志、WAL 日志等)。 - 设置唯一标识符(如 `server-id`)。 - 创建用于复制的专用账号(需授予复制权限)。 2. **从库配置** - 配置唯一标识符(不同于主库)。 - 指向主库的地址、端口、账号和日志位置。 - 启动复制进程,实时同步数据。 3. **验证与监控** - 检查主从状态是否正常。 - 监控数据同步延迟。 --- ### **二、MySQL 主从配置示例** #### **1. 主库配置** 1. **修改配置文件 `my.cnf`** ```ini [mysqld] server-id = 1 log_bin = /var/log/mysql/mysql-bin.log binlog_do_db = your_database_name # 可选:指定复制的数据库 ``` 2. **重启 MySQL 并创建复制账号** ```sql CREATE USER 'replica_user'@'%' IDENTIFIED BY 'password'; GRANT REPLICATION SLAVE ON *.* TO 'replica_user'@'%'; FLUSH PRIVILEGES; ``` 3. **查看主库状态** ```sql SHOW MASTER STATUS; -- 记录 File (如 mysql-bin.000001) 和 Position (如 107) ``` #### **2. 从库配置** 1. **修改配置文件 `my.cnf`** ```ini [mysqld] server-id = 2 relay-log = /var/log/mysql/mysql-relay-bin.log ``` 2. **重启 MySQL 并配置复制链路** ```sql CHANGE MASTER TO MASTER_HOST = '主库IP', MASTER_USER = 'replica_user', MASTER_PASSWORD = 'password', MASTER_LOG_FILE = 'mysql-bin.000001', MASTER_LOG_POS = 107; START SLAVE; ``` 3. **检查从库状态** ```sql SHOW SLAVE STATUS\G -- 确保 `Slave_IO_Running` 和 `Slave_SQL_Running` 为 Yes ``` --- ### **三、PostgreSQL 主从配置示例(流复制)** #### **1. 主库配置** 1. **修改 `postgresql.conf`** ```ini wal_level = replica max_wal_senders = 10 ``` 2. **修改 `pg_hba.conf` 允许从库连接** ```ini host replication replica_user 从库IP/32 md5 ``` 3. **创建复制账号** ```sql CREATE USER replica_user WITH REPLICATION PASSWORD 'password'; ``` #### **2. 从库配置** 1. **停止 PostgreSQL,清空数据目录** ```bash pg_basebackup -h 主库IP -U replica_user -D /var/lib/postgresql/data -P --wal-method=stream ``` 2. **创建 `recovery.conf`(或 PostgreSQL 12+ 在 `postgresql.conf` 中配置)** ```ini standby_mode = 'on' primary_conninfo = 'host=主库IP port=5432 user=replica_user password=password' ``` 3. **启动从库并检查状态** ```sql SELECT * FROM pg_stat_replication; ``` --- ### **四、MongoDB 主从配置示例(副本集)** 1. **主库和从库配置文件 `mongod.conf`** ```yaml replication: replSetName: "rs0" ``` 2. **初始化副本集(在主库执行)** ```js rs.initiate({ _id: "rs0", members: [ { _id: 0, host: "主库IP:27017" }, { _id: 1, host: "从库IP:27017" } ] }); ``` 3. **检查状态** ```js rs.status(); ``` --- ### **五、注意事项** 1. **网络与安全** - 确保主从服务器网络互通,开放数据库端口(如 MySQL 3306)。 - 使用防火墙规则限制访问,避免暴露敏感端口。 2. **数据一致性** - 首次同步前,主库数据应保持一致(可通过备份恢复至从库)。 3. **故障处理** - 若主库宕机,需手动或通过工具(如 MHA、Patroni)切换从库为主库。 4. **监控工具** - MySQL: `pt-heartbeat` - PostgreSQL: `pg_stat_replication` - MongoDB: `rs.status()` --- 通过以上步骤,你可以根据使用的数据库类型快速搭建主从架构。实际部署时需结合具体业务需求和数据库版本调整配置。

核心目标

搭建主从架构,实现数据冗余、读写分离和负载均衡

相关要求

主库启用数据日志;从库启用复制进程,实现同步数据;监控数据同步延迟

数据中台建设

建立数据中台是企业实现数据资产化、服务化和智能化的核心路径,能够打通数据孤岛、提升数据复用能力,赋能业务快速创新。以下是构建数据中台的系统性方法: --- ### **一、明确数据中台的目标与价值** 1. **定义核心目标** - 统一数据标准,消除数据孤岛。 - 提供标准化数据服务(如用户画像、实时报表、推荐模型)。 - 支持业务快速迭代和创新(如精准营销、风控模型)。 - 降低数据开发成本,避免重复建设。 2. **识别业务场景** - 从核心业务痛点出发(如跨部门数据无法协同、分析效率低)。 - 优先选择高价值场景(如供应链优化、客户生命周期管理)。 --- ### **二、数据中台架构设计** #### **1. 技术架构分层** - **数据采集层**:统一采集多源数据(数据库、日志、IoT设备、第三方API)。 - **存储计算层**: - 批处理:Hadoop、Hive、Spark - 实时处理:Flink、Kafka - 数据湖/仓:Delta Lake、Iceberg、ClickHouse - **数据治理层**:元数据管理、数据质量监控、血缘追踪(工具如 Apache Atlas、DataHub)。 - **数据服务层**:API 化输出数据(如用户标签服务、实时大屏数据)。 - **应用层**:支撑业务系统(BI、AI模型、运营平台)。 #### **2. 典型技术栈选择** - **存储**:HDFS、S3、HBase、Redis - **计算引擎**:Spark、Flink、Presto - **调度系统**:Airflow、DolphinScheduler - **数据治理**:Great Expectations(数据质量)、Apache Ranger(权限管理) - **服务化**:Kubernetes(容器化部署)、GraphQL(灵活API设计) --- ### **三、关键实施步骤** #### **1. 数据整合与标准化** - **统一数据模型**:定义企业级数据标准(如客户ID、商品分类)。 - **ETL 开发**:将分散数据清洗后入湖/仓,示例流程: ```sql -- 创建标准化用户表 CREATE TABLE user_unified AS SELECT user_id, COALESCE(email, mobile) AS contact_info, CASE WHEN source = 'CRM' THEN '内部系统' ELSE '第三方' END AS data_source FROM raw_user_data; ``` #### **2. 数据治理体系** - **元数据管理**:记录数据来源、字段含义、更新频率。 - **数据质量监控**:设置规则(如唯一性、非空校验),自动告警。 - **血缘追踪**:可视化数据加工链路,快速定位问题。 #### **3. 数据服务化** - **API 封装**:将数据能力封装为 RESTful API 或 SQL 服务。 ```python # Flask 示例:提供用户标签查询接口 @app.route('/user_tags/<user_id>') def get_user_tags(user_id): tags = query_db(f"SELECT tags FROM user_profile WHERE id = {user_id}") return jsonify(tags) ``` - **实时数据服务**:通过 Kafka + Flink 实现实时特征计算。 #### **4. 构建数据资产目录** - 分类管理数据资产(如原始数据、模型、API)。 - 支持自助查询,降低数据使用门槛。 --- ### **四、组织与文化转型** 1. **成立数据中台团队** - 角色:数据工程师、数据科学家、产品经理(数据产品)。 - 职责:维护中台架构、开发通用数据能力。 2. **推动数据驱动文化** - 培训业务部门使用数据工具(如BI平台、SQL查询)。 - 建立数据价值评估机制(如通过A/B测试验证数据服务效果)。 --- ### **五、典型挑战与解决方案** 1. **数据孤岛难以打通** - 通过组织高层推动数据共享,建立数据权责机制。 2. **技术选型复杂** - 优先选择云厂商托管服务(如 AWS Glue、阿里云DataWorks)降低运维成本。 3. **业务参与度低** - 采用“试点先行”策略,先在一个部门验证价值,再横向推广。 --- ### **六、成功案例参考** 1. **零售行业** - 数据中台整合线上线下数据,实现“千人千面”推荐,提升转化率20%。 2. **金融行业** - 通过统一风险指标计算,将风控模型开发周期从2周缩短至2天。 --- ### **七、工具推荐** - **数据集成**:Apache NiFi、Airbyte - **数据治理**:Collibra、Alation - **数据可视化**:Superset、Tableau - **云服务**:AWS Lake Formation、阿里云DataWorks --- ### **总结** 数据中台建设需要**技术+组织+流程**三位一体: 1. 技术上选择灵活可扩展的架构,避免过度设计。 2. 组织上打破部门壁垒,明确数据所有权。 3. 流程上以业务价值为导向,小步快跑迭代优化。 通过持续沉淀数据资产、赋能业务创新,数据中台将成为企业数字化转型的核心引擎。

核心目标

统一数据标准;消除数据孤岛;提供标准化数据服务;识别业务场景(如光伏发电、负荷、智能配电等)

架构设计

数据采集层(从数据库);存储计算层(中台数据库);数据治理层(元数据管理、数据质量监控、数据逻辑处理);数据服务层(API化输出数据,如用户标签服务、实时大屏数据);应用层(支撑业务系统,提供服务接口)

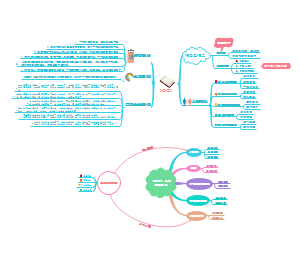

数据治理服务

元数据管理

记录数据来源、字段含义、更新频率

数据质量监控

设置规则(唯一性、非空校验)、自动警告

血缘追踪

可视化数据加工链路,快速定位问题

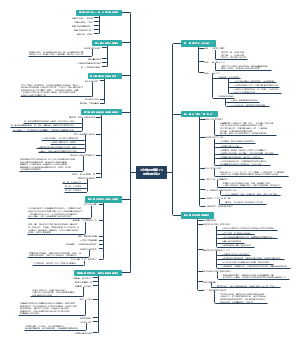

数据共享审核

实现数据共享审核机制是确保数据安全、合规使用的重要环节,尤其在跨部门或跨组织协作中。以下是构建高效数据共享审核机制的系统性方案: --- ### **一、明确审核机制的核心目标** 1. **合规性**:符合GDPR、CCPA等数据隐私法规及行业规范。 2. **安全性**:防止敏感数据泄露或滥用(如用户隐私、商业机密)。 3. **可追溯性**:记录共享全流程,支持事后审计。 4. **效率平衡**:避免过度审批影响业务效率。 --- ### **二、数据共享审核流程设计** #### **1. 分级分类管理** - **数据分级**(示例): | 级别 | 数据类型 | 共享要求 | |------|----------|----------| | L1 | 公开数据 | 无需审批 | | L2 | 内部运营数据 | 部门负责人审批 | | L3 | 敏感数据(如PII) | 法务+安全团队联合审批 | - **分类标签化**: 通过元数据标记数据敏感度(如`公开/内部/机密`)、用途限制(如`仅分析/不可导出`)。 #### **2. 标准化申请流程** - **申请表单**需包含: ```markdown - 申请人/部门 - 数据用途(如风控分析、合作方交付) - 请求的数据范围(表/字段级) - 使用期限 - 数据脱敏要求(如是否需要匿名化) ``` #### **3. 多级审批工作流** ```mermaid graph TD A[提交申请] --> B{数据级别} B -->|L1| C[自动通过] B -->|L2| D[部门审批] B -->|L3| E[安全团队+法务审批] D & E --> F[授权并记录] F --> G[数据交付] ``` --- ### **三、技术实现方案** #### **1. 权限控制与脱敏** - **动态脱敏**(如SQL查询时自动隐藏手机号后四位): ```sql CREATE VIEW masked_customer AS SELECT id, CONCAT(LEFT(phone, 3), '****') AS phone_masked FROM customer; ``` - **基于角色的访问控制(RBAC)**: 通过权限矩阵定义角色(如`数据分析师`仅能访问脱敏后的数据)。 #### **2. 自动化审核工具** - **规则引擎自动审批**(低风险场景): ```python def auto_approve(request): if request.data_level == "L1" and request.user.role == "BI": return True # 自动通过 ``` - **集成审批系统**: 与企业微信/钉钉/飞书审批流程打通,支持移动端审批。 #### **3. 审计与监控** - **操作日志记录**: 记录谁在何时访问了哪些数据,存储到不可篡改的日志系统(如ELK+区块链存证)。 - **异常检测**: 对高频访问、异常时段下载等行为触发告警(如通过Prometheus+Alertmanager)。 --- ### **四、关键策略与最佳实践** 1. **最小权限原则** - 默认拒绝所有请求,仅开放必要权限。 - 临时权限设置有效期(如72小时后自动失效)。 2. **数据水印与追踪** - 对共享文件嵌入隐形水印(如通过Python库`opencv`添加数字水印),追踪泄露源。 3. **第三方共享控制** - 合作方数据需通过API网关访问,限制QPS和总量。 - 合同条款明确数据使用边界及违约责任。 --- ### **五、组织保障措施** 1. **成立数据治理委员会** - 成员包含IT、法务、业务部门代表,定期评审共享策略。 2. **培训与意识提升** - 对员工进行数据安全培训(如识别敏感数据、正确申请流程)。 3. **违规处理机制** - 明确违规处罚条例(如警告、暂停数据权限)。 --- ### **六、工具推荐** - **审批流程**:Camunda、Jira Service Management - **权限管理**:Apache Ranger、AWS IAM - **数据脱敏**:Apache ShardingSphere、Delphix - **审计日志**:Splunk、阿里云操作审计(ActionTrail) --- ### **七、典型场景示例** #### **场景:市场部申请用户画像数据** 1. **申请**:提交表单,请求`用户年龄段`和`消费偏好`字段(L2级数据)。 2. **审批**:市场总监审批通过,自动触发数据脱敏(如模糊化地理位置)。 3. **交付**:通过加密链接下载,文件自带水印`仅供2024Q3促销使用`。 4. **监控**:系统检测到该数据7天后未删除,自动发送提醒邮件。 --- ### **总结** 一个健壮的数据共享审核机制需要: ✅ **流程标准化**(分级分类+明确审批链) ✅ **技术自动化**(动态脱敏+权限控制) ✅ **组织协同**(跨部门职责划分+安全意识) 通过“制度+工具+人”的结合,可在保障数据安全的同时提升共享效率。

核心目标

合规性(符合数据隐私法规);安全性(防止敏感数据泄露,如用户隐私、商业机密);可追溯性(记录共享全流程,支持事后审计);效率平衡(避免过度审批)

审核流程

分级分类管理

数据分级(L1:公开数据、L2:内部运营数据、L3:敏感数据);分类标签化(通过元数据标记数据敏感度<公开/内部/机密>、用途限制<仅分析/不可导出/可导出>)

标准化申请流程

申请表单(申请人/部门;数据用途<分析、合作方交付科>;请求数据范围<表/字段>;使用期限;数据脱敏要求(是否需要匿名化)

多级审批流程

A[提交申请]

B{数据级别}

|L1| C【自动通过】

G

|L2| D【部门审批】

F

|L3| E【安全团队+法务审批】

F

F【授权并记录】

G【数据交付】

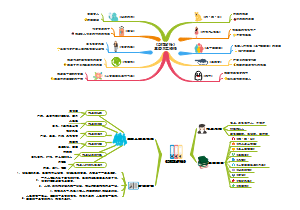

数据可视化

构建数据资产目录

分类管理数据资产(如原始数据模型、API)

支持自动查询,降低数据使用门槛

数据服务化

API封装(将数据能力封装为API或SQL服务)

实时数据服务(实现实时数据特征计算或查询)

数据下载

数据交付后,提供给用户下载数据