导图社区 模式识别

- 145

- 2

- 2

- 举报

模式识别

模式识别的思维导图,包括统计决策方法、线性分类器、概率密度函数的估计等内容的总结概括,希望对大家有用。

编辑于2022-11-11 22:06:39 山西- 统计

- 概率函数

- 相似推荐

- 大纲

模式识别

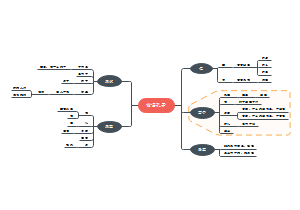

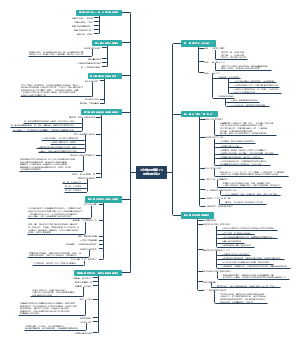

第二章 统计决策方法

2.1 关于贝叶斯的一些

类条件概率:类别为ω时,样本x出现的概率P(x|ω)

先验概率:类别ω出现的概率,只有ω₁,ω₂两种类别时P(ω₁)+P(ω₂)=1

全概率:样本x在所有类别里出现的概率之和P(x)

后验概率:P(ω|x)=[P(x|ω)P(ω)]/P(x)

全概率:P(x)样本x在所有类别里出现的概率之和

错误率:P

正确率:P(c) =1-P(e)

2.2 最小错误率贝叶斯决策

从最小错误率的要求出发,利用概率论中的贝叶斯公式,使得错误率最小的分类决策

使后验概率最大的决策

最小贝叶斯公式的变形

2.3 最小风险贝叶斯决策

样本数量不一定等于决策的数量——①除了判别类外,也可以对某些样本做出拒绝决策(不能判断属于任何一类) ②也可能决策时把几类合并成了一个大类

损失函数:对于实际状态为ωₒ的向量x ,采取决策αₒ所带来的损失为λ(αₒ,ωₒ)

条件期望损失 (条件风险)

此处考虑的是某一样本x采取某一决策α的损失的加权平均值

样本若有m个类别,则有m个损失,应将m个损失加权去平均

若对于样本有a种决策,那么这个样本即可有a个条件风险

期望风险

反映整个所有空间样本采取决策的平均风险

最小风险贝叶斯决策

在采取每一个决策时,都使条件风险最小则对所有x做出决策时其期望风险也必然最小

计算步骤

①计算后验概率

②计算条件风险

③在各种决策中选择风险最小的

0-1损失函数是一种特殊的最小风险贝叶斯决策此时等价物最小错误率准则

2.4

两类错误率

TP 真阳性 TN 真阴性 FP 假阳性 FN 假阴性

假阴性率(第二类错误率)=假阴/总阳

假阳性率(第一类错误率) =假阳/总阴

灵敏度(真阳性率)Sn =TP/(TP+FN)

特异度(真阴性率) Sp=TN/(TN+FP)

Neyman-Pearson决策

限定一类错误率为常数而使另一类错误率最小的决策规则

ROC曲线

Sn为纵坐标,FP为横坐标,反映随着阈值变化两类错误率的变化情况

曲线下的面积即AUC可以衡量方法的性能,对角线的AUC=0.5没有任何分辨能力 AUC越靠近1性能越好

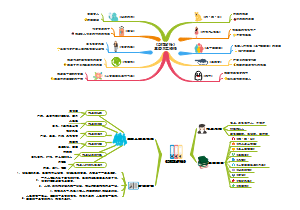

2.5正态分布时的统计决策

原因:客观世界中很多随机变量都服从或近似服从正态分布。对很多数据都可以做出正态分布假设并且有利于数学分析

正态分布的基础知识

单变量正态分布

概率密度函数

μ为随机变量x的均值(期望) ,σ²为x的方差,σ为标准差(均方差)

单变量正态分布函数P(x)由μ和σ就可以完全确定,样本都集中在μ附近,σ越大分散程度越大。

百分之九十五的样本都落在区间(μ-2σ,μ+2σ)

多元正态分布

概率密度函数

x是d维列向量,μ是d维均值向量=E(x)(x的期望) ,∑是d×d维协方差矩阵=E{(x-μ)(x-μ)T}

多元正态分由均值向量μ和协方差矩阵∑就可以完全确定,样本都集中在中心μ附近,区域大小由∑决定

等密度点:此时轨迹是一个超椭球面概率密度函数指数

正态分布概率模型下的最小错误率贝叶斯决策 判别函数:

一.∑₀=σ²I,i=1,2,... 每类的协方差矩阵相等,并且是对角阵, 类内各特征相互独立,具有相同的方差σ², 各类样本落入以μi为中心,同样大小的超球体内 判别函数简化为:

1.各类先验概率相等

可以忽略lnP(ω)

相邻两类的决策面为超平面并与两类均值点连线中点正交(相交并垂直)

判别函数gi(x) 是x的线性函数

最小距离分类器:当对某一样本分类时,只要计算样本到各类中心μ的欧式距离,然后归到min类。

2.各类的先验概率不等

判别函数gi(x) 是x的线性函数

决策面为超平面,并与两类均值点连线正交(相交并垂直) ,但是不连线中点,他们的交点向先验概率小的类型均值点偏移,即先验概率大的占更大的决策空间。将样本归类到maxg(x)

二 .∑i=∑ 各类的协方差矩阵相等,各类均值向量任意 各类样本集中于该类均值为中心的同样大小和形状的超椭球体内 判别函数简化为:

1.各类先验概率相等

可以忽略lnP(ω)

相邻两类的决策面为超平面并与两类均值点连线中点相交,但不垂直

决策规则:当对某一样本分类时,只要计算样本到各类中心μ的马式距离,然后归到min类。

2.各类的先验概率不等

判别函数gi(x) 是x的线性函数

相邻两类的决策面为超平面并与两类均值点连线中点相交,但不垂直 ,远离可能性较大的均值

三 .∑i≠∑ 各类的协方差矩阵不相等 此时判别函数为

判别面为超二次平面

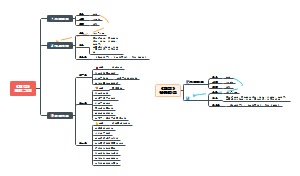

第五章 线性分类器

5.1 基于样本的分类器设计

基于概率密度的分类器的概率模型和估计概率密度函数以及其他模型参数并不容易,如果能直接根据样本求分类面,就可以省略对概率密度函数估计

基于样本直接设计分类器的三要素

1.确定分类器,也就是判别函数的类型(线性/非线性) g{(α),α∈Λ},α:未定参数

2.确定分类器设计的目标或准则(最小错误率/最小风险) 准则函数L(α)

3.设计算法利用样本数据搜索到最优的函数参数 求L(αº)=minL(α)

5.3线性判别函数的基本概念

表达式:g(x)=ωTx➕ω₀

ω权向量,X d维权向量,ω₀常数,阈值权,分类时c类会对应c个这样的判别函数

两类问题的决策规则

判别函数:g₁(x)-g₂(x)

决策规则

决策面

线性判别函数g(x)=0定义的超平面

假设x₁和x₂都在决策面上,有ωTx₁+ω₀=ωT(x₁-x₂)→ωT(x₁-x₂)=0

超平面性质

ω是超平面的法向量(ωT(x₁-x₂)=0)

超平面把特征空间分为两个半空间,对应ω₁类决策域R₁正侧g(x)>0和ω₂类决策域R₂负侧g(x)<0

若x为原点,则g(x)=ω₀为原点到超平面的距离

若ω₀>0,则原点在H的正侧

若ω₀<0,则原点在H的负侧

若ω₀=0,则H通过原点,具有齐次形式

g(x) 可以看成是特征空间中某点x到超平面的距离的一种代数度量

xp:x在H的投影 r :x到H的垂直距离 ω/‖ω‖

5.4Fisher线性判别分析

思想:选择投影方向,使得两类样本投影的均值差尽量大,两类样本离散程度尽可能小

基本参量

d维原样本的参量

mi:样本均值向量

Si:各类类内离散矩阵

Sw:总类内离散矩阵

Sb:类间离散矩阵

一维样本空间参量

样本在ω方向上的投影:yi=ωTx

两类的均值

类内离散矩阵(不再是一个矩阵而是一个值)

总类内离散矩阵

类间离散度

Fisher准则函数

使两类之间尽可能分开,类内部尽可能聚集 要求解使得准则函数取最大值时所对应的ω*

最优投影方向:设定分子为非零常数,最大化分子部分

得到分类面,确定分类阈值ω₀的方法

最优贝叶斯决策:符合正态分布且两类协方差矩阵相同

根据经验确定阈值

1)不考虑先验概率,用阈值ω₀=-1/2m~

2)考虑先验概率,采用此阈值估计值

5.5感知器

Fisher线性判别设计分两步,感知器则是直接得到完整的线性判别函数 g(x)

基本概念

增广样本向量:把向量x增加一维,取值为常数Y=[1,x₁,x₂,...,x]T

增广权向量:α=[ω₀,ω₁,...,ω]T

线性判别函数:g(y)=aTy

决策规则:若g(y)>0,则y∈ω₁,若g(y)<0,则y∈ω₂

线性可分性

若存在一个权向量a,使得当y∈ω₁时aTy>0,y∈ω₂时aTy<0,这些样本线性可分

样本规范化 此时样本的可分性条件就变成了存在一个a,使得aTy>0,i=1,2,...,N

解向量

线性可分情况下,满足aTyi>0,i=1,2,...,N的a为权向量

对于每个样本yi,等式 aTyi=0确定了一个穿过权空间原点的超平面,yi为其法向量

解向量如果存在,必须在超平面正侧

对于N个样本,解向量必定在N个正半平面的交叠区,而且该区域中的任意向量都是解向量

余量

考虑到噪声,数值计算误差等因素的影响,把解区间向中间缩小,不取靠近边缘的解

用b表示余量,要求解向量满足:aTyi>b>0

越靠近解区中间的解向量,对样本错分可能性越小

解向量求解方法

感知准则函数

若对样本yk错分,aTyk≤0,对所有错分样本求和来表示对错分样本的惩罚

当且仅当Jp(α*)=minJp(α)=0时,α*为解向量

剃度下降算法

批处理感知算法

1.)目标函数Jp(a)对权向量的剃度

2.)将▽J代入梯度下降法表达式

3.)没有错分样本时,得到一个合适的解a*

单样本修正法:每次就修正一个样本的做法

1.)初始值任意α(0)

2.)对错分样本yj

3.)对所有样本重复步骤2,直至Jp=0

感知器准则要求全部样本线性可分,经过有限迭代梯度下降就可收敛到解向量a。 当样本线性不可分时,不收敛

5.6最小平方误判别EMS

同时满足线性可分与不可分问题

最小平方误差准则函数

准则函数最小化方法

违逆法求解

梯度下降法求解

LMS算法中求解出的权向量与b有关

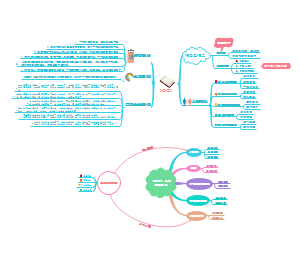

第三章 概率密度函数的估计

3.1 参数估计

参数估计方法

最大似然估计

贝叶斯估计

两种方法的区别: 最大似然估计把待估计的参数看做确定的量,取值未知 贝叶斯估计是把待估计的参数看做符合某种先验概率分布的随机变量

参数估计分类

监督参数估计

非监督参数估计

参数估计基本概念

统计量:针对不同的参数估计要求构造的函数

点估计,估计量,估计值

参数空间

3.2最大似然估计

似然函数及对数似然函数

参数向量 θ的最大似然估计,就是使得P(x|θ)最大的那个参数估计量θ₀ 最有可能出现的样本←等价于→似然函数最大的样本

极大似然估计的求解

一维变量参数的求解:似然函数连续可微条件下,最大似然估计量θ₀就是解dH(θ)/dθ=0

多维变量参数的求解:对参数向量θ的每一维分量分别求偏导即用此梯度算子

正态分布下的似然估计

均值向量的最大似然估计是样本的均值

协方差矩阵的最大似然估计是N个矩阵的算术平均

3.3贝叶斯估计

解决思想类似于贝叶斯决策,采用最小风险的决策方法

损失函数:假设参数θ估计为θ₀时所带来的损失为λ(θ₀,θ)

求最小化期望风险等价于求最小化条件风险

对于不同的损失函数,可得到不同的最佳贝叶斯估计

平方误差形式的损失函数λ(θ₀,θ)=(θ-θ₀)²

随着样本的增加,后验概率序列逐渐尖锐,逐步趋向于以θ的真实值为中心的尖峰趋向于ξ函数

贝叶斯估计的基本步骤

1.确定θ的先验分布P(θ)

2.求样本集的联合分布

3.求θ的后验概率分布

4.求贝叶斯估计量

3.4概率密度的非参数方法

直方图方法

x分成n个等间隔小窗,落入各小窗样本数qi/NV(N样本总数,V小窗体积)

V的选择策略(V过大估计粗糙,过小某些区域中没有样本 )

Parzen窗法 窗宽选择:样本数少选大点,样本数多选小点

Kn近邻估计 :通过控制小区域内的样本数kn来确定小区域大小

浮动主题

第一章 概论

1.1基本术语

模式识别也称模式分类

识别就是把对象分门别类认出来

模式:指需要识别且可测量的对象的描述

样本,样本集

类或类别:具有相同的模式

特征(属性)

已知样本/未知样本

1.2 模式识别的主要方法

基于知识的方法 (以专家系统为代表)

如果分类和特征之间的关系可以确切描述时,这种方法可能会更有效

基于数据的方法(无特别说明时模式识别通常指这种方法)

收集一定数量的已知样本,用这些样本作为训练集训练机器

适用于已知对象的某些特征与某种类别性质有关,但无法确切描述这种关系时

常见的基于数据的模式识别

统计模式识别

人工神经网络

支持向量积

如果分类和特征的关系完全随机,毫无规律,那么模式识别也无法得到有意义结果

1.3 监督模式识别与非监督模式识别

监督模式识别

已知划分的类别,获得一定数量的类别已知样本并建立分类器

非监督模式识别

划分类别未知,样本类别未知,根据样本特征将样本聚类,使同一类样本相似,而不同类之间有较大差异

答案不唯一

统计中称为聚类

1.4 模式识别系统举例

语音识别

说话人识别

字符与文字识别

复杂图像中特定目标识别

根据地震勘测数据对地下储层性质的识别

利用基因表达数据进行癌症分类

1.5 模式识别系统的典型构成

①原始数据的获取和预处理

②特征提取与选择

③分类或聚类

④后处理